如何讓第五代樹莓派待機用電精省達96%?

隨著樹莓派第五代的效能提升,用電量還是無可避免地增加,即便處於待機(standby)狀態也會耗挺多的電力,約1.29W!本篇文章,會教大家一些簡單的方法,透過編輯組態檔來達成待機省電的效果!

【Maker電子學】步進馬達的原理與驅動—PART4

本篇文章介紹驅動電感性負載時,電路中的可怕殺手:電感的反電動勢,並說明如何利用與驅動電路電流方向相反的保護二極體來吸收這個反電動勢。

運用BF16與NHWC技術實現進階版LLM微調訓練最佳化

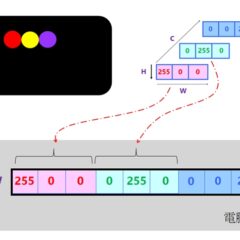

本文要來介紹如何利用BF16半精度浮點數以及將影像資料設為NHWC格式兩項技術,來最佳化大型AI模型的訓練速度與記憶體節省,並延續以

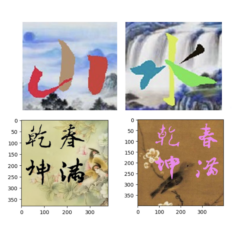

拿大模型程式碼來訓練自用小模型:以AI寫(畫)書法為例

本文會拿Diffusion來學習及創作書法字體,也就是俗稱的:寫書法。雖然Diffusion也能學習依循標準筆順,來逐筆寫出字形。為了從簡單範例出發,本文先讓Diffusion來學習程生成整個字形,而不是逐一生成各筆劃。

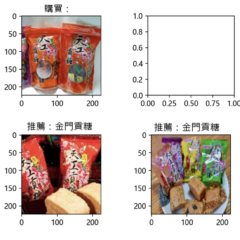

從CLIP應用領會潛藏空間(Latent space)的魅力

本文將從商店櫃檯的產品推薦應用來說明:我們可以拿CLIP的原始程式碼,搭配商家自有產品圖像(Image)和圖像敘述文句(Text),來訓練出企業自用的CLIP小模型,同時也領會其幕後潛藏空間(Latent space)的運作及其效果。

如何利用低位元量化技術進一步提升大模型推論性能

相比運算量的增加,大模型推論速度更容易受到記憶體頻寬的影響,導致算力資源無法得到充分發揮,進而影響性能;低位元量化技術是讓大語言模型(LLM)在部署過程中實現性能需求的最佳方案之一,本文將探討低位元量化技術如何幫助LLM提升性能,以及新版OpenVINO對於低位元量化技術的支援。