在2023年,麻省理工學院的Improbable AI實驗室以及Google DeepMind都取得了令人矚目的機器學習突破。這些創新的技術應用在家務、機器人技術和推理領域,揭露了未來更先進的機器人與人工智慧應用。

Improbable AI 實驗室的多模式框架:HiP

Improbable AI 實驗室的研究團隊提出了一種全新機器學習的多模式框架,即分層規劃的組合基礎模型(Hierarchical Planning, HiP)。與傳統的單一模型不同,HiP結合了三種不同基礎模型的專業知識,分別在語言、視覺和行動方面進行訓練。這種獨特的結構讓機器人在完成複雜任務時能夠更有效地進行推理和行動,同時消除了對配對視覺、語言和動作數據的高成本需求。HiP 的應用範圍廣泛,從家務任務到建築和製造都能得心應手。

研究人員進行了三種測試:第一項是要求它將不同顏色的區塊相互堆疊,然後將其他區塊放在附近,問題是:一些正確的顏色不存在,因此機器人必須將白色塊放入顏色碗中才能繪製它們;第二項是要將糖果與鐵鎚放入棕色碗中,但是要移動的物品很髒,機器人要將物品放入清潔箱中清潔完畢,再放入棕色碗中;第三項是機器人完成廚房的子目標,例如打開微波爐、清理水壺以及打開燈,目標是學習忽略不必要的物體。

HiP 在以上三個不同的操作任務上表現出色。這項技術不僅在機器推理能力上取得了顯著進展,而且在處理新信息和適應新情境方面也呈現出智能計劃的潛力。HiP 的成功展示了多模式整合的可能性,為機器人技術的未來開創了新的方向。

DeepMind 的 Robotic Transformer 2 (RT-2) 模型

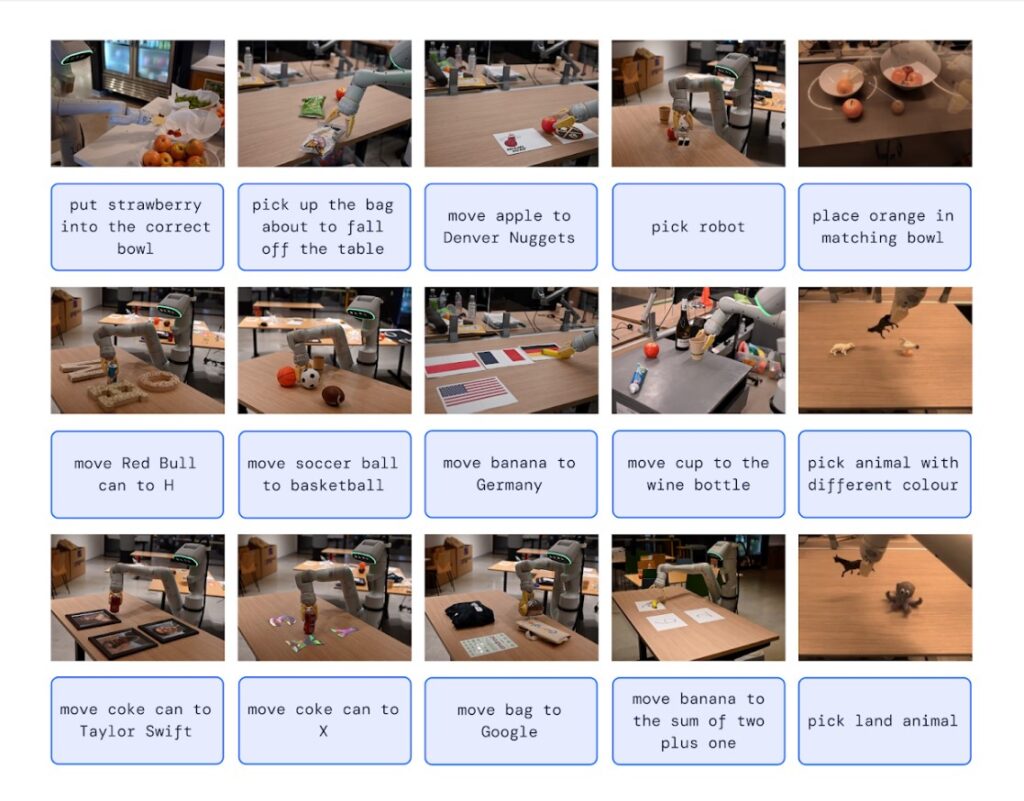

另一方面,Google DeepMind的最新機器人技術 RT-2 模型展現了機器人在學習、推理和行動方面的卓越能力。這個模型超越了其前身 RT-1,可以從簡單的視覺輸入中決定最佳的臨時動作,例如從放置在其前面的一系列物體中確定最佳的臨時錘子(如一塊岩石),或者確定疲倦的人應該喝哪種飲料(能量飲料)。最令人印象深刻的是,它可以用簡單的語言執行分配給它的基本任務,即使是不明確的說法(例如:移動香蕉到德國)。

RT-2 利用大型視覺語言主幹,透過與機器人運動數據的結合,實現對周圍環境的語義理解和基本推理。這種結合使得 RT-2 能夠根據所見內容進行推理,並且在處理未見過的任務方面表現出顯著的改進。儘管 RT-2 仍受到機器人數據吸收的限制,但它已經展現出強大的學習和推理能力。

小結

以上兩單位的技術突破均為機器人結合機器學習而能自主推理和行動帶來了新的可能性,同時也突顯了多模式整合和視覺語言應用的重要性。這些創新有望在未來的人工智慧發展中發揮重要作用,為機器人在不同領域的應用帶來更多可能性。

(責任編輯:Peter Wang)

參考資料

1.Multiple AI models help robots execute complex plans more transparently(Source)

2.Google’s RT-2 Robot Gives ChatGPT-Style AI a Body (Source)

3.Google Deepmind部落格(Source)

- Himax與Rabboni聯手實現穿戴式裝置終端即時AI推論 - 2025/07/15

- 思科解密AI驅動的商業創新與網路安全新趨勢 - 2025/07/15

- Q版、低價、開源:Reachy Mini機器人上桌了! - 2025/07/10

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!