用OpenVINO GenAI解鎖LLM極速推論:推測式解碼讓AI爆發潛能

借助簡化開發和最佳化硬體利用率的工具,OpenVINO使開發者能夠在各種即時和資源受限的場景中部署高性能的LLM;無論是構建回應迅速的聊天機器人或高效率虛擬助手,還是具備可擴展性的創意應用,OpenVINO正在重新定義AI推論的可能性。本文將探討如何利用OpenVINO GenAI的推測式解碼技術使這一變革性創新成為現實。

OpenVINO 2025.0來了…一起繼續玩生成式AI吧!

OpenVINO的最新版本2025.0,除了性能的再次提升,也擴大了GenAI模型的支援範圍,並針對Intel NPU導入了關鍵最佳化功能。讓我們一起來探索這些令人興奮的更新!

【 Edge AI專欄】使用Intel OpenVINO搭配YOLOv11輕鬆駕馭姿態偵測

Intel OpenVINO 在開源範例庫 Notebooks 上給出 YOLOv11 物件偵測、姿態估測及影像分割等三個案例。本篇文章,會跟著源碼說明來了解一下如何運行 【姿態估測】 範例「Convert and Optimize YOLOv11 keypoint detection model with OpenVINO™」及動作原理。

【學習程式新工具】用MS Copilot 生成 micro:bit 感測器程式碼

為了測試 ChatGPT 能否協助我們更有效的學習電腦程式語言,我們選用了 MS Copilot 來生成 micro:bit 板載上的感測器程式碼,然後在 V3 版的小彼特 Python Editor上驗證。

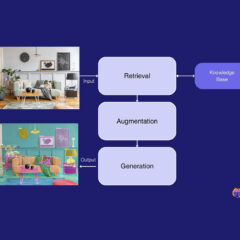

【RAG for Vision】如何結合RAG建構Multimodal電腦視覺系統

結合AI電腦視覺與RAG的Visual RAG已被視為是下一代AI應用進步的關鍵,本文介紹它的技術架構與應用案例。

【開箱評測】探索未來:結合迷你PC與生成式AI的個人多媒體助理

以mini PC作為多媒體AI個人助理的應用,展現了AI技術日益貼近日常生活的趨勢,未來這類設備將在提升個人生活品質和工作效率方面扮演越來越重要的角色,而本文將分析NUC BOX-155H這台mini PC在多媒體處理上的效能,並且分享一個未來十分看好、能成為個人多媒體助理的AI模型:Stable Diffusion及其多個版本的發展與應用選擇。