MobileDiffusion 是Google Core ML 計畫所推出的一種創新的文字生成圖像模型,專為行動裝置設計,致力於實現在極短時間內生成高品質的512×512影像,其相對較小的模型尺寸(僅 520M 參數)使其特別適合移動部署。

去年如MediaPipe在Andorid與透過Core ML在iOS上的進展,也還沒辦法在行動裝置上達到『亞秒級』的表現;而如Stable Diffusion、DALL·E和Imagen等擴散模型因為具有數十億參數,所以需要強大的桌面電腦或是伺服器,也沒辦法用在行動裝置上。MobileDiffusion 這項技術的推出代表著在行動裝置上文字到影像生成技術的一次重要進展,同時突破了過去在這一領域的種種限制。

(圖片來源)

技術背後:Stable Diffusion UNet

有效克服行動裝置有限運算能力所帶來的挑戰需要對模型的架構效率進行深入、全面的探索。為了實現這一目標,Core ML的研究對Stable Diffusion的UNet 架構中的每個組成部分和計算操作進行了詳細檢查。他們提供了一個全面的指南,用於製作高效的文本到圖像Diffusion模型,最終形成 MobileDiffusion。

MobileDiffusion 的設計遵循latent diffusion models的設計。它包含三個組件:文字編碼器、擴散 UNet 和圖像解碼器。其中文字編碼器使用CLIP-ViT/L14,這是一個適合行動裝置的小模型(125M 參數)。擴散 UNet則遵循UViT架構的思想,在 UNet 的瓶頸處放置更多的 Transformer 塊。這種設計選擇的動機是,由於注意力計算的維度較低,因此在瓶頸處的資源密集程度較低。

在影像解碼器方面,MobileDiffusion 採用變分自動編碼器(VAE)和輕量級解碼器結構。訓練了能夠將RGB影像編碼為8通道潛在變量的VAE,並通過修剪原始寬度和深度來設計輕量級解碼器。這種優化不僅提高了生成影像的品質,同時有效控制了模型的大小,使模型在半秒內生成高品質影像。

突破之處:一步採樣的巧妙運用

MobileDiffusion 的另一亮點是對一步採樣的巧妙運用:透過引入DiffusionGAN混合模型,實現在行動裝置上的高效生成。該方法巧妙運用預先訓練的擴散 UNet 初始化生成器和鑑別器,有效克服了訓練成本和效率之間的困境。這種策略使得MobileDiffusion的訓練過程更加穩定,同時確保在極短時間內實現了高品質影像的生成。

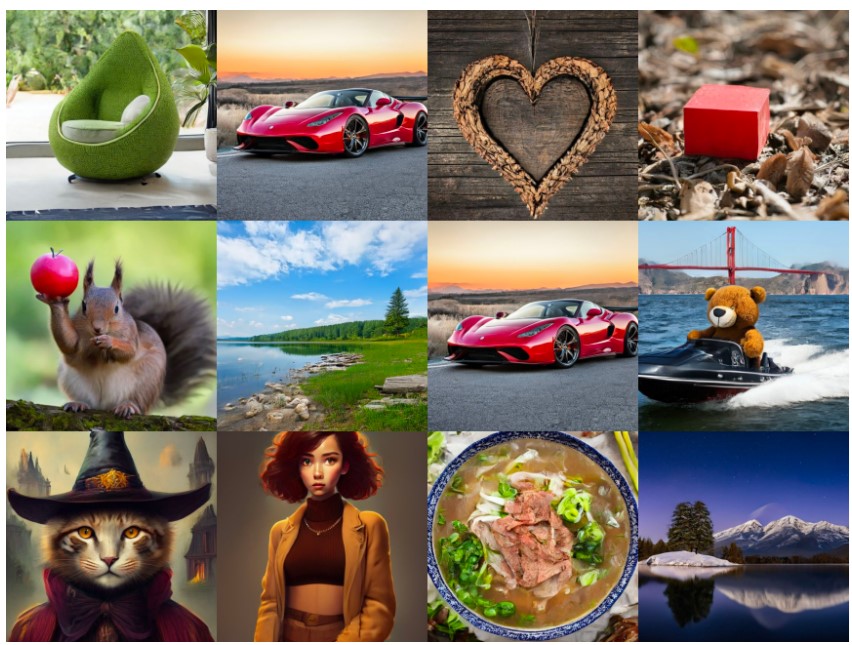

MobileDiffusion一步採樣產生高品質多樣化影像

應用前景:提升用戶體驗和推動AI在行動裝置上的應用

MobileDiffusion的推出將在多個領域中產生重大影響。首先,它將極大地提升了在行動裝置上的用戶體驗,也讓MobileDiffusion 有著廣泛的應用可能性。無論是在社交媒體分享、即時通訊中使用,還是應用於藝術、設計或娛樂領域,MobileDiffusion 都為用戶提供了一個高效、快速且高品質的生成影像的解決方案。其在行動裝置上的高效運行更使得這項技術具有實用性和廣泛應用的潛力。

MobileDiffusion在行動裝置上的延遲測量

註:本文摘要自此技術白皮書:MobileDiffusion: Rapid text-to-image generation on-device,進一步內容可閱讀原文。

(責任編輯:Peter Wang)

- Arm推出SME2技術加速Android裝置AI功能升級 - 2025/07/18

- 耐能智慧以邊緣AI技術驅動精準醫療與高效醫患協作 - 2025/07/18

- 打造智慧邊緣新引擎 ASRock推NVIDIA Jetson AGX Orin AI平台 - 2025/07/17

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!