整理:謝嘉洵

什麼是大模型時代?

在過去,傳統的機器學習算法與神經網路模型通常規模較小,有限的參數限制了他們在處理大規模數據和複雜指令的成效。而隨著科技發展,人工智慧的計算能力也不斷地攀升,大數據的普及以及更高規格模型需求的出現,導致開發人員開始向更大的模型探索,以期人工智慧能夠有更好的表現。

大模型時代是近年來AI發展領域中出現的一個重要趨勢,指的是大規模、高容量的神經網路模型運用在各種不同領域的情況。而這些模型,往往具有數十億到數萬億個參數。這些「大模型」,都擁有強大的學習能力與表現,可以處理更複雜、龐大的數據集。

為什麼大模型時代即將終結?

如今生成式AI的背後技術,稱其為大模型很可能已經不夠貼切,模型中所需要的參數數量已是天文數字,是以稱其為「巨型模型」可能更加準確。OpenAI最早的語言模型GPT-2是於2019年所公佈的,當時就已經涵蓋了15億個參數。此後隨著不斷的擴容、提升與完善,截至目前最新版本的GPT-4 ,雖然OpenAI並沒有公佈其參數數量,但外界普遍認為已經達到了前代(GPT-3)的三十倍以上 — 3.5兆個。

人類網路歷史上的各種高質量語料,早在GPT- 3 以及後續發布的 GPT- 4 的學習中被消耗殆盡,誠然,大型模型的參數仍然可以持續膨脹,但是高質量的數據參數卻是在逐步減少,因此成長參數以「數量」所帶來的效益正逐步降低,就如同摩爾定律。

數據中心(圖片來源)

除了數據與效益不對等之外,GPU以及建設數據中心的物理限制與高昂成本,或許才是這些AI大模型開發公司的切膚之痛。營運巨型數據服務中心的成本高昂,再加上AI大模型訓練的話,不管是電力還是水力,其所花費的成本代價亦是非常可觀的。

AI產業的摩爾定律?

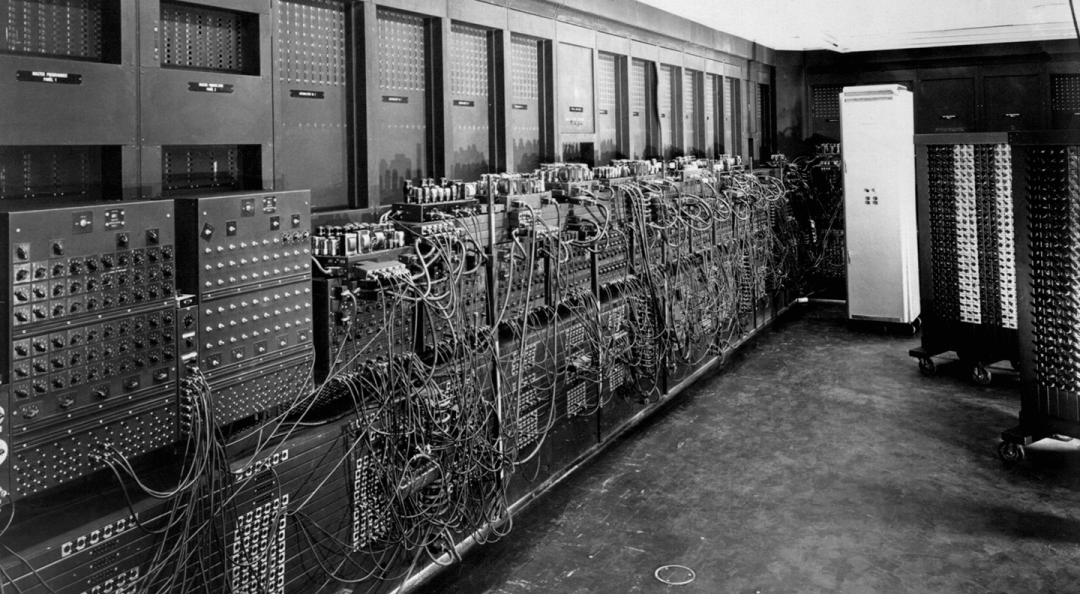

「一味不計成本地堆砌硬體不是未來」已經成為越來越多業內人士的共識。現今的AI發展,近似於網路早期發展的即視感:產業發展中已經出現了「摩爾定律」,訓練大模型的GPU集群,與世上第一台電腦在本質上並沒有太多的區別。很顯然,人工智慧的領域中,欠缺了一場「半導體革命」。在發展中需要探索其他更加高效的模式— 或許是參數的精簡,或許是利用多個小模型疊加利用,又或許是開闢出一條全新的AIGC發展方向。

機房(圖片來源)

未來AI的發展方向是何方?

AI應用的不斷創新,除了為大模型技術探索更多的應用外,也是現有算力之下,不斷地向外求索AI的更多可能。再這樣不斷嘗試與回饋之下,AI也不間斷的向前發展。可以預測的是AI絕不會止步於大模型,即便對現今AIGC技術而言大模型的技術至關重要。

AI 不會永遠依賴大模型的參數提升以及堆砌算力來構建未來。開發更小也更精準的模型,更加具體的應用場景等等,或許正是未來AI發展的重中之重。到時候,隨著大模型時代的結束,或許就會是人工智能時代真正的開始。

- 【從無到有造一艘船】看看全國盃Maker造船大賽的無窮創意! - 2024/08/28

- 改變你的社群網路體驗:Meta AI助理機器人 - 2024/02/19

- 近期熱度正高的AI PC,是在夯什麼? - 2024/01/03

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!