為Edge AI推論應用開發而生的開放源碼工具套件OpenVINO,自2018年由英特爾(Intel)推出迄今,下載次數已經超過300萬次,實現了無數創新成果。2024年伊始,OpenVINO的最新版本2023.3 LTS正式發表,更進一步降低了生成式AI技術的門檻,帶來更簡單的工作流程、更好的PyTorch相容性,並帶來針對大語言模型的最佳化,以及最新Notebook範例。

為了讓廣大開發者對最新版OpenVINO的強化功能有更深入的了解,Intel與MakerPRO在2024年1月底共同舉辦了第三場OpenVINO DevCon線上講座,由Intel平台研發協理王宗業、OpenVINO傳教士武卓博士與AI軟體工程師楊亦誠,詳細介紹OpenVINO又加入了哪些可讓Edge AI開發專案如虎添翼的新功能,接著以生物製藥的應用為案例,展示OpenVINO如何協助打造先進的生命科學CellAI流水線,實現精密細胞分割任務,還有如何利用OpenVINO的Model Serve功能實現LLM服務,以及在邊緣端進行以RTSP為基礎的智慧視訊分析。

讓生成式AI隨手可及

在講座開場,王宗業帶領大家回顧了分別在2023年7月與9月舉辦的前兩場DevCon主題,雖然只有短短數月,OpenVINO除了持續強化對當紅生成式AI等新技術的支援,也一直注意改善平台本身的易用性、擴充參考設計程式碼等資源;來自開放性社群廣大開發者的回饋與貢獻是其中的關鍵力量,而OpenVINO也成為實現Intel「AI無所不在」(AI Everywhere)願景的不可或缺工具。

王宗業表示,為了支援越來越多元化的AI應用,包括可望在2024年起呈現爆炸性成長的AI PC產品以及各種邊緣裝置,Intel在2023年底正式發表了新一代內建NPU的Core Ultra系列CPU (代號Meteor Lake),藉由利用OpenVINO的強大功能,開發者將能盡情揮灑創意、更輕鬆地完成邊緣AI應用的部署。他也樂觀預期,OpenVINO將在今年底就達到超過500萬下載次數的里程碑。

接下來在講座的第一部分,武卓與楊亦誠從前面提到的簡化工作流程、對PyTorch的更好相容性,以及針對大語言模型的最佳化、最新Notebook範例等四個方面,分別介紹2023.3版本OpenVINO的重要更新。在工作流程的部分,新版本透過提供更多元化的安裝方式與更直覺流暢的使用者介面,讓開發者無論是使用那一種作業系統或運算平台的開發者,都能很方便地下載利用OpenVINO進行開發。

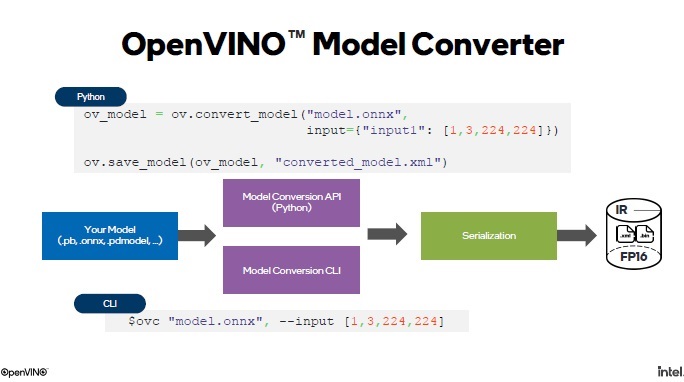

此外,新版OpenVINO的Model Converter工具也讓模型轉換程序更簡便,只需要兩行程式碼就能以Python API或CLI方式完成模型轉換。而藉由該工具,將不同格式的PyTorch模型轉換為OpenVINO的IR格式,也不需要再以轉換ONNX格式做為中介,能一步到位。PyTotch模型使用者還能透過在原生框架中進行簡單的程式碼更改,就能享受到OpenVINO帶來的推論性能提升──武卓舉了一個Stable Diffusion Web UI在後端整合 OpenVINO的案例(資源庫下載連結)。

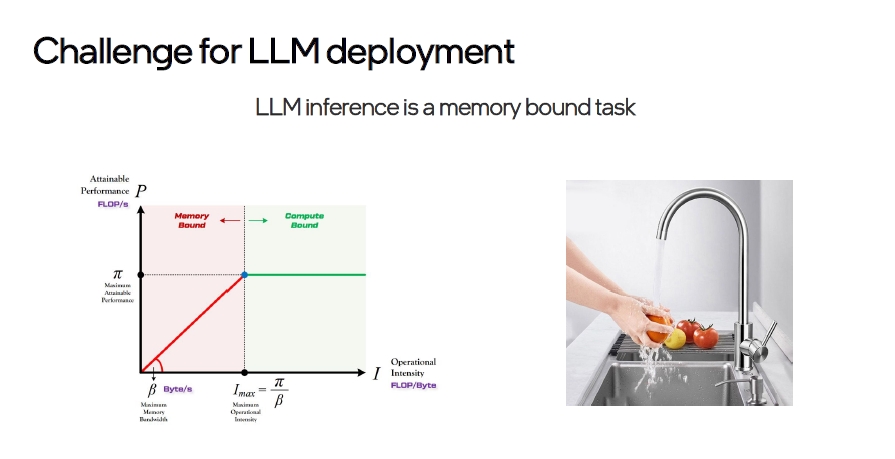

在針對大語言模型(LLM)的最佳化方面,楊亦誠透過講解LLM的架構、在邊緣端應用可發揮的作用、進行LLM壓縮與部署會遭遇到的實際挑戰,還有實際應用案例的展示,說明OpenVINO特別重視對該類模型的支援之理由以及優勢所在;藉由與Huggineg Face的合作──該開源社群為OpenVINO提供了一個名為Optimum的工具資源,為正在面對LLM應用部署任務的開發者帶來莫大助力。

而不只是LLM,針對其他文生圖、音樂生成、文字轉語音等生成式AI模型,與常用的影像分類、物件辨識等等AI模型,提供了有上百種實例分享的Notebook資源庫;針對2023.3版本對更多生成式AI的支援,OpenVINO還推出了為C與C++語言使用者打造的OpenVINO GenAI Pipeline Repo儲存庫,為開發提供最新的程式碼資源。

以Model Server實現創新應用

在讓聽眾對最新版本OpenVINO的強化功能有充分了解之後,講座的第二部分由武卓從一個為生物製藥產業建立的先進生命科學AI流水線案例出發,講解美國業者Beckman Coulter Life Sciences如何運用OpenVINO以及Cellpose AI演算法,實現以名為CellAi的細胞影像分析工具軟體執行細胞影像分割任務的最佳化──透過結合多個深度學習模型以及平行使用CPU與GPU,OpenVINO成功協助該客戶提升了流水線運作效率,在更短的時間(從數十秒加快至數秒)內取得推論結果。

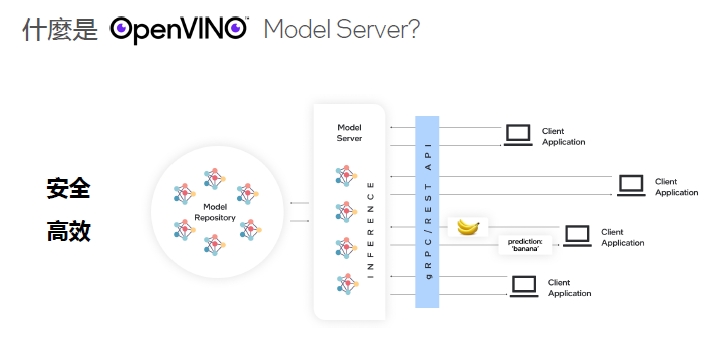

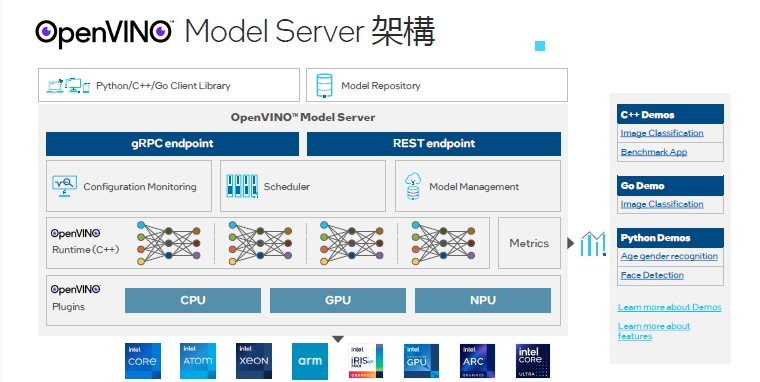

OpenVINO的Model Server工具(OVMS)在上述案例中扮演了關鍵角色;根據楊亦誠的介紹,Model Server的功能有三個基本組成,首先是Model Repository,即是讓使用者在邊緣端儲存、管理自定義模型的儲存庫;第二個部分是讀取儲存庫中模型、執行推論的Model Server本身;第三個部分就是客戶端裝置,也就是接收推論結果的終端應用。

雖然OpenVINO的Model Server並非全新概念,但具備對TensorFlow Serving API和KServe API的相容性,以及支援gRPC、RESTful API,還有對模型增減、多版本管理以及配置熱更新,以及動態尺寸、多模型部署(OpenVINO/ONNX/TensorFlow/Paddle Paddle)、本地及遠端模型檔儲存(GCS/AWS S3/Azure Storage)、Bare Metal/Docker/k8s部署、多種異質運算硬體(CPU/GPU/NPU)的支援等特性,再加上能提供客戶端性能測試範例、快速驗證AI服務性能等優勢,突顯了其獨特的能力。

2023.3版本的Model Server還透過整合Google的MediaPipe,讓該工具的性能有更進一步的提升,包括支援Python程式碼執行(code execution)的新功能,如此能讓使用者以MediaPipe的圖形(Graph)為基礎建構自定義任務,取得更好的服務體驗。楊亦誠實際示範了以Model Server搭建LLM的流程,只需要簡單幾個步驟就能輕鬆上手;此外也介紹了一個在邊緣端進行以即時串流通訊協定(RSTP)為基礎的智慧視訊分析應用案例。同樣Model Server也提供了豐富的儲存庫,有興趣的開發者能點擊此連結取得更多資訊。

在講座最後的問答時間,三位專業講師也與線上聽眾就OpenVINO與Intel各種硬體平台的搭配、可實現的性能,以及針對不同應用適合選擇的平台等等問題進行交流,互動相當熱烈。未來Intel與MakerPRO除了持續提供各位讀者最新的OpenVINO技術教學文章,也將規劃在每一季舉辦不同主題的DevCon線上講座,讓大家一起學習如何更得心應手使用OpenVINO完成創新的Edge AI應用開發,期待很快線上再見!

- 多重因素影響 預估2025年AI伺服器出貨增幅略減 - 2025/07/04

- 2025 AI for Good高峰會:許AI一個造福世界的未來 - 2025/07/02

- 聯發科第二代MR Breeze系列AI語音辨識開源模型問世 - 2025/07/02

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!