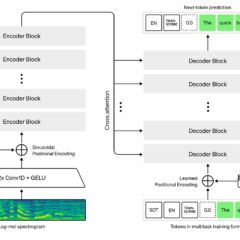

輕鬆使用OpenVINO在本地裝置離線運作Llama3

利用OpenVINO部署Llama3到本地運算資源,例如AI PC,不僅意味著更快的回應速度和更低的運作成本,還能有效地保護資料安全,防止敏感資訊外洩。這對於需要處理高度敏感性資料的應用場景尤其重要,如醫療、金融和個人助理等領域。本文將介紹如何使用OpenVINO對Llama3模型進行最佳化和推論加速,並將其部署在本地裝置上,進行更快、更智慧的AI推論。

用OpenVINO C# API部署YOLOv9目標檢測和實例分割模型

YOLOv9模型是YOLO系列即時目標檢測演算法中的最新版本,代表著該系列在準確性、速度和效率方面的又一次重大飛躍。在本文中,我們將結合OpenVINO C# API使用最新發佈的OpenVINO 2024.0部署YOLOv9目標檢測和實例分割模型。

OpenVINO 2024.0:為開發者提供更高性能、更強大支援

OpenVINO 2024.0來了!我們很高興在這個版本推出一系列強化功能,目標是在快速發展的AI領域賦予開發者更強大的能力;新版本透過動態量化、改善的GPU最佳化以及對混合專家(MoE)模型架構的支援,增強了大語言模型(LLM)的性能。OpenVINO 2024.0讓開發者能有效利用AI加速,這也要感謝來自社群的持續貢獻。

用OpenVINO與NNCF最佳化Whisper語音辨識模型

本文示範如何以OpenVINO與Optimum Intel載入並執行Whisper與Distil-Whisper模型進行音訊轉錄任務,以及如何使用NNCF對這些模型執行INT8訓練後量化;接著在橫跨多種CPU的裝置上以大規模語音轉文字資料集評估這些模型。

如何在Google Colab上運行OpenVINO Open Model Zoo範例

本篇文章會以OMZ 影像分類(Classification) Public Pre-Trained Models為例,說明如何在Colab 上直接運行Intel Open Model Zoo。

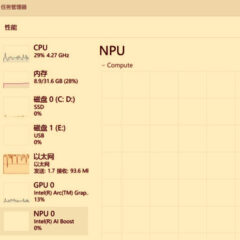

如何在Windows平台呼叫NPU部署深度學習模型

在最新一代的Intel Core Ultra行動終端處理器中已經整合了簡稱為NPU的神經網路加速處理器,以提供低功耗的AI算力,而OpenVINO工具套件也在第一時間對NPU進行了配接。本文將帶領讀者一起看看如何在Intel Core Ultra處理器上搭建基礎環境,並呼叫NPU進行模型推論任務。