Physical AI近了!如何打造「通用又專才」的機器人?

如何透過Physical AI讓機器人結合語言理解、視覺感知、策略推理和動作控制等多模態 AI 能力,最終能像「真人」自主且適性地執行多種任務?NVIDIA嘗試提出開放式基礎模型: GR00T N1,以及眾多配套技術,且看本文的介紹。

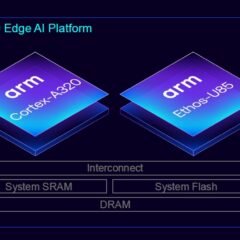

打造健全Edge AI生態系 Arm扮演開發者堅實後盾

不久前,Arm正式發表首個為IoT裝置打造的Armv9架構平台,這是否意味著Edge AI市場終於將進一步擴大版圖,讓全球數量超過百億的IoT裝置都能更容易冠上一個「A」字母,實現真正的AI無所不在?

ROHM新推AI微控制器 強調能「現學現推論」

日本半導體製造商ROHM新推出AI微控制器,可利用在馬達等工業設備,以及其他各種設備的感測資料進行故障檢測和劣化預測,號稱業界首創、無需網路即可進行元件上的學習和推論。

台灣首個手機端3B繁中推論模型與高效評測工具正式推出

企業自主AI解決方案供應商APMIC宣布與繁體中文語言模型研究社群Twinkle AI攜手合作,正式推出台灣首個可於手機端運作的3B參數繁體中文推論模型「Formosa-1」。雙方亦聯手開源高效評測框架「Twinkle Eval」,共同推動台灣AI技術發展與本地化應用。

GTC 2025技術觀察:GR00T N1、Newton、BDX Blue

本篇文章會針對今年GTC 2025推出的幾款新技術:GR00T N1、Newton及BDX Blue進行簡單的介紹。

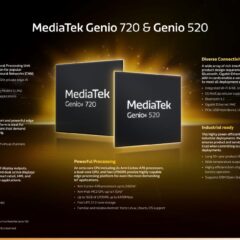

聯發科新一代智慧物聯網平台支援生成式AI模型

聯發科技(Mediatek)發表新一代高性能邊緣 AI 物聯網平台Genio 720和Genio 520,專為智慧家庭、智慧零售、工業及商業使用等物聯網裝置設計,支援最新生成式AI模型、人機介面(HMI)、多媒體以及通訊功能。