【創業小聚】「寫完程式,然後呢?」Zeabur用一鍵部署,解決AI時代開發者的最後一哩路!

Zeabur創辦人兼執行長林沅霖(首圖右)為此開發了「一鍵式部署服務」,讓不熟悉完整開發流程的新時代開發者也能輕鬆自動部署程式,同時提升專業開發者的效率,至今每月服務超過1.6萬名活躍用戶。

AI 部署策略:雲端、地端或混合雲,企業該如何選擇?

隨著人工智慧(AI)技術的快速發展,企業在部署 AI 應用時,面臨雲端(Cloud)、地端(On-Premise)或混合雲(Hybrid Cloud)的選擇。然而,如何在效能、安全性與成本之間取得最佳平衡,成為決策關鍵。

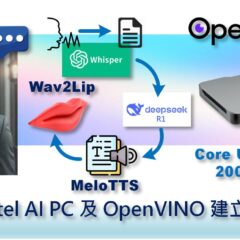

輕鬆用Intel AI PC及OpenVINO建立數位分身

一個完整的數位分身,就像真人一樣,要具有自然語言對話、豐富肢體動作和產生生動表情的能力,其中就需要用到許多生成式AI技術,包括利用語音轉文字(STT)得到問題的文字,交給大語言模型(LLM)進行文字問答,再將文字轉語音(TTS)把答案讀出,最後再配合語音自動對嘴形(Lip Sync)讓人物影像的嘴巴也能和語音同步動起來。

【Arm的AI世界】三步驟輕鬆在Ethos-U85上使用PyTorch與ExecuTorch

Arm透過在Ethos-U85上支援ExecuTorch測試版,為開發人員建構物聯網邊緣端應用提供了更多支援。開發人員可以借助ExecuTorch,高效率地部署原生開發的PyTorch模型,基於Arm平台建構出智慧且回應迅速的IoT解決方案。

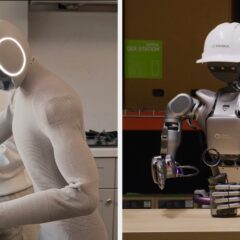

助力人形機器人開發 NVIDIA發表開放式基礎模型

NVIDIA宣布推出一系列助力開發人形機器人的技術組合,包括開放式、可自訂基礎模型NVIDIA Isaac GR00T N1,提供通用人形機器人推理能力和技能。其他技術包括模擬框架與藍圖,例如用於產生合成資料的NVIDIA Isaac GR00T Blueprint,以及與Google DeepMind及Disney Research共同開發中、專門用於開發機器人的開源物理引擎Newton。

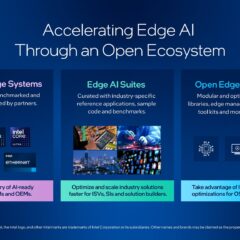

英特爾透過開放生態系加速邊緣AI發展

英特爾發表全新邊緣AI系統(Intel AI Edge Systems)、邊緣AI開發套件(Edge AI Suites)和開放式邊緣平台(Open Edge Platform)產品,透過簡化與既有基礎架構的整合,協助零售、製造、智慧城市、媒體和娛樂產業加速邊緣AI布署與應用。