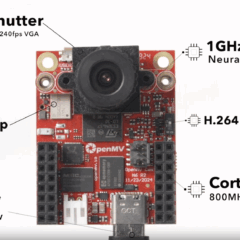

ADI低功耗AI MCU – MAX78000,適用電池供電環境

Analog Devices(ADI)推出的MAX78000,是一款針對Edge AI應用設計的超低功耗微控制器(Microcontroller Unit, MCU),專為在資源有限的邊緣設備上執行神經網路推論而打造。

認識Qualcomm AI 模型優化工具:AIMET

AIMET是 Qualcomm 開發的一套 AI 模型優化工具,它透過壓縮和量化技術來縮小模型,同時保持任務的準確性,有助於提高其在資源受限設備(如手機、邊緣裝置、IoT 設備)上的運行效率。

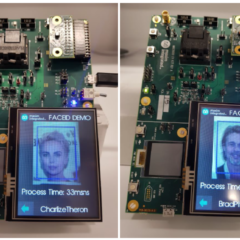

【Arm的AI世界】以TinyML為基礎的高效率嵌入式電腦視覺

本文將透過在配備Ethos-U55 NPU的現代微控制器上執行兩個TinyML應用,來展示NPU的效能優勢。我們將分別在採用和不採用Ethos-U55 NPU的微控制器上運作應用中所使用的 ML模型,以此對推論延遲進行基準測試。

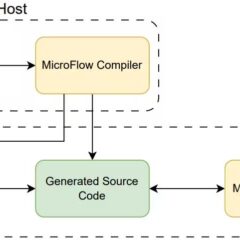

TinyML潛力股!MicroFlow挑戰TensorFlow Lite for Microcontrollers

近期有個MicroFlow試圖挑戰TFLM,包含相同模型條件下的推論速度、記憶體佔量、用電量、最低可執行使用的硬體水準等。本篇文章會針對MicroFlow與TFLM,進行簡單的效能對比。

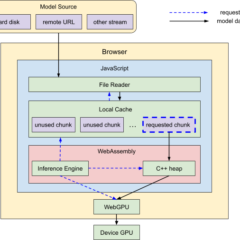

【技術導讀】Google推出Web API技術,用瀏覽器運行LLM沒問題!

Google推出網頁版 LLM 推論API,使在瀏覽器中運行小型大型語言模型(LLMs)成為可能。此一Web API技術的特色通過 WebAssembly 和 WebGPU 效率地利用設備端的 GPU 來加速運算,克服了記憶體限制,甚至可以在瀏覽器中運行更大的模型,例如Gemma 1.1 7B。