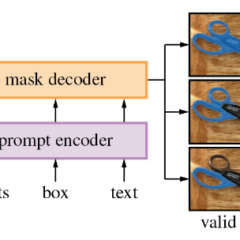

AI分割一切:用OpenVINO加速Meta SAM大模型

最近在電腦視覺領域就出現了專屬的物體分割大模型,由Meta開源的「萬物可分割」(SAM)物體分割模型。這個強大的通用分割模型,當然也能用OpenVINO進行最佳化以及推論的加速,使其能方便快速地在Intel的CPU上部署執行。來跟著我們提供的程式碼與步驟一起來動手試試吧!

【開箱評測】巴掌大的迷你主機也能跑出高效AI推論表現!

為了更進一步了解這類迷你主機在AI推論效能的表現,此次選用東擎(ASRock Industrial) NUC BOX-1260P作為測試機,AI推論部份則選用OpenVINO 2022.3版作為基礎工具。而測試項目則使用OpenVINO Notebooks中最新的物件偵測「Convert and Optimize YOLOv8 with OpenVINO」範例作為實測效能的分析。

以創意+技術實力開拓AI新商機 Intel DevCup得獎團隊分享致勝秘訣

由MakerPRO攜手Intel舉辦的第18次「Edge AI社聚」,邀請到在2022年Intel DevCup競賽實作組獲得前三名的團隊,分享他們是如何成功開發出分別能解決珠寶業、養雞業,以及物業管理/保全業「痛點」,並協助業者降低成本、加速工作效率的商用邊緣人工智慧方案…

【MakerLEARN課程】AMR加速開發與應用 – 工廠自動控制實例

邊緣運算技術不斷的出現在我們生活周遭,那麼如果邊緣運算進入工廠後,又有怎樣的應用呢?本課程會帶大家一同看看。

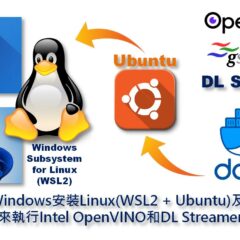

如何在Windows安裝Linux(WSL2+Ubuntu)及Docker來執行OpenVINO和DL Streamer

隨著Win11上市,WSL2也迎來較大幅度的更新,本文將帶著大家從零開始一步一步架設Linux開發環境並且安裝安裝Intel OpenVINO、Docker和DL Streamer進行練習。

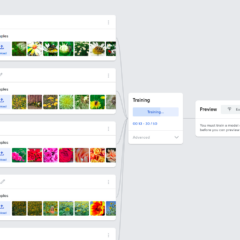

就用OpenVINO 來推論Teachable Machine模型吧!(2022.1 版)

Intel OpenVINO 在今年迎來最大幅度的版本更新,除更便利開發者進行操作外,也對 API 進行優化,那麼該如何利用這個最新版本的OpenVINO 推論 Teachable Machine 模型呢?一起來了解看看吧!