如何在Google Colab上運行OpenVINO Open Model Zoo範例

本篇文章會以OMZ 影像分類(Classification) Public Pre-Trained Models為例,說明如何在Colab 上直接運行Intel Open Model Zoo。

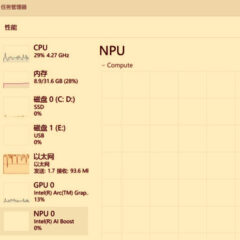

如何在Windows平台呼叫NPU部署深度學習模型

在最新一代的Intel Core Ultra行動終端處理器中已經整合了簡稱為NPU的神經網路加速處理器,以提供低功耗的AI算力,而OpenVINO工具套件也在第一時間對NPU進行了配接。本文將帶領讀者一起看看如何在Intel Core Ultra處理器上搭建基礎環境,並呼叫NPU進行模型推論任務。

新年首發 OpenVINO 2023.3 LTS版本隆重登場!

是時候在生成式人工智慧(AI)領域大放異彩地開啟2024年了,最新的OpenVINO推論工具2023.3 LTS版本隆重登場,導入了額外的框架改變,最佳化了生成式AI模型的特性,並強化了對現有平台的支援,將使您在新的一年中的程式編寫之旅變得異常精彩!本文將帶您了解新版本OpenVINO的一些重要更新。

【活動報導】OpenVINO讓生成式AI隨手可及

2024年伊始,OpenVINO的最新版本2023.3 LTS正式發表,更進一步降低了生成式AI技術的門檻,為了讓廣大開發者對最新版OpenVINO的強化功能有更深入的了解,Intel與MakerPRO在2024年1月底共同舉辦了第三場OpenVINO DevCon線上講座…

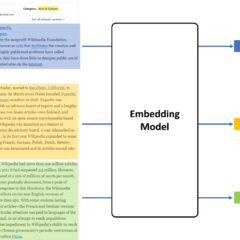

用OpenVINO和LangChain打造你專屬的RAG問答系統

隨著生成式AI的興起,和大語言模型對話聊天的應用變得非常熱門,但這類應用往往只能簡單地和你「聊聊家常」,並不能針對某些特定產業提供非常專業和精準的答案。那有沒有辦法讓你的模型學習到新的知識呢?當然有!在沒有足夠GPU運算資源對模型進行重新訓練的情況下,RAG方式對普通使用者來說更友善。本文就要來探討如何利用OpenVINO以及LangChain工具構建屬於你的RAG問答系統。

輕鬆利用OpenVINO結合LangChain與Llama2打造智慧小助手

LLM大模型存在很多痛點,包括但不限於資料陳舊、無法和外部元件互動等,本文旨在使用 OpenVINO 2023.1新版本的特性加速Llama2模型,為Llama2客製化Prompt,並用LangChain 實現可連網取得最新消息的輔助搜尋功能