小模型力量大:Gemma 3 270M為專業領域而生

過去對生成式 AI 的討論幾乎被「大模型」壟斷。人們談的是百億、千億參數的能力極限,卻往往忽略了「落地應用」的真正需求。Gemma 3 270M 的推出,正好提醒我們:AI 的未來不僅僅在於更大,而在於更適合。

ASRock發表AiUAC驅動工業自動化邁向智慧未來

東擎科技(ASRock Industrial)發表AiUAC開放控制解決方案。基於UAO IEC 61499標準,具備高度擴充性,協助工業自動化邁向以軟體驅動的開放架構。可運行於各廠牌不同類型的邊緣設備…

互動式世界模型的新境界:Genie 3來了!

DeepMind 已經先後推出 Genie 1 與 Genie 2,嘗試讓模型依照指令生成新的環境。與此同時,他們在影片生成領域的 Veo 系列模型 也展現了 AI 對「直覺物理學」的掌握力。但直到 Genie 3,這一切才真正邁入了「互動式世界」的新階段。

來自阿拉伯世界的先進LLM:Falcon系列

Falcon LLM家族不僅展現了尖端技術的突破,更代表了一種面向未來、包容性強且專注倫理的AI開發理念。從Falcon-H1的混合架構到Falcon-E的邊緣計算適配,從全模態的Falcon 3到革命性Mamba 7B,每一個創新都在為生成式AI的普及和深化應用鋪路。

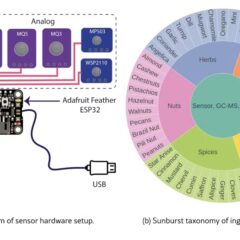

讓機器也能聞味道:MIT開發SmellNet為嗅覺AI模型打地基

現有AI模型多與文字、圖片識別相關,嗅覺識別的發展遠遠不如,現在MIT研究人員試圖把嗅覺視覺化,哪些味道相近相鄰?哪些味道差距很大等,將此建立起來,成為數位資料庫與AI訓練所需的資料集。

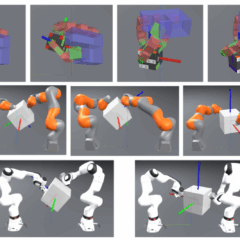

為生成機器人訓練用資料而生的MIT PhysicsGen

近期麻省理工學院(MIT)與機器人與人工智慧研究所(RAI)合作推動名為PhysicsGen的計畫,運用Gen AI來生成實體性、物理性資料,再將資料供AI模型訓練用。