輕薄型筆電OK!利用OpenVINO部署Phi-3.5「全家餐」

近期微軟發佈了最新的Phi-3.5系列SLM模型,是非常適合在AI PC上運作的模型任務。本文將分享如何利用OpenVINO在你的AI PC上部署最新Phi-3.5-mini及Phi-3.5-vision模型。

LangChain框架已正式支援OpenVINO!

透過LangChain,開發者可以輕鬆構建基於RAG或者Agent流水線的複雜應用體系,而目前我們已經可以在LangChain 的關鍵元件LLM、Text Embedding和Reranker中直接呼叫OpenVINO進行模型部署!

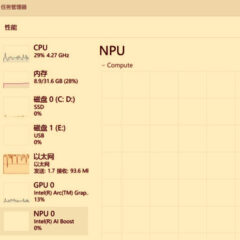

如何在Windows平台呼叫NPU部署深度學習模型

在最新一代的Intel Core Ultra行動終端處理器中已經整合了簡稱為NPU的神經網路加速處理器,以提供低功耗的AI算力,而OpenVINO工具套件也在第一時間對NPU進行了配接。本文將帶領讀者一起看看如何在Intel Core Ultra處理器上搭建基礎環境,並呼叫NPU進行模型推論任務。

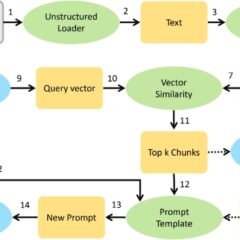

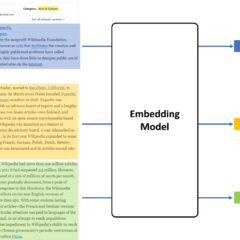

用OpenVINO和LangChain打造你專屬的RAG問答系統

隨著生成式AI的興起,和大語言模型對話聊天的應用變得非常熱門,但這類應用往往只能簡單地和你「聊聊家常」,並不能針對某些特定產業提供非常專業和精準的答案。那有沒有辦法讓你的模型學習到新的知識呢?當然有!在沒有足夠GPU運算資源對模型進行重新訓練的情況下,RAG方式對普通使用者來說更友善。本文就要來探討如何利用OpenVINO以及LangChain工具構建屬於你的RAG問答系統。

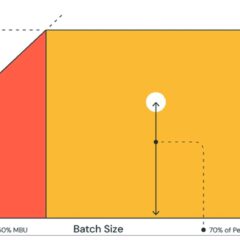

如何利用低位元量化技術進一步提升大模型推論性能

相比運算量的增加,大模型推論速度更容易受到記憶體頻寬的影響,導致算力資源無法得到充分發揮,進而影響性能;低位元量化技術是讓大語言模型(LLM)在部署過程中實現性能需求的最佳方案之一,本文將探討低位元量化技術如何幫助LLM提升性能,以及新版OpenVINO對於低位元量化技術的支援。

免「仲介」 OpenVINO能直接支援PyTorch模型物件!

隨著OpenVINO 2023.0版本的發佈,OpenVINO工具庫中預置了全新的PyTorch前端,為開發者們提供了一條全新的PyTorch模型支援路徑,帶來更友好的用戶體驗—— OpenVINO的mo工具可以直接將PyTorch模型物件轉化為OpenVINO的模型物件,開發者可以不需要將ONNX模型作為中間過渡。