作者:武卓,英特爾AI軟體傳教士

在多種裝置上高效率運作AI模型本該如此簡單!

OpenVINO是英特爾(Intel)推出的開源工具套件,專為開發者打造,讓AI模型能夠在CPU、GPU與NPU上實現極致最佳化與快速部署。全新 OpenVINO 2025.3 版本,為你帶來更快的上手體驗和更強大的性能。此次升級重點聚焦生成式AI,新增對多種尖端模型的支援,並推出全新GenAI流水線,全面擴展了OpenVINO Model Server的能力。

無論你想打造智慧聊天機器人、領先的電腦視覺應用,還是突破性的生成式AI解決方案,OpenVINO 2025.3都能為你提供簡潔高效的工具,加速從靈感到落地的全過程,助力你的 AI 創意照進現實。

新增模型支援

在本次新版本中,我們新增了對更多生成式AI模型的支援,從大語言模型(LLM)到多模態視覺語言模型(VLM),包括 Phi-4-mini-reasoning、AFM-4.5B、Gemma-3-1B、Gemma-3-4B和 Gemma-3-12B。你可以在GitHub的LLM Chatbot Notebook中體驗Phi-4-mini-reasoning,這是一款針對高級數學推論能力進行微調的羽量級模型。同時,你還可以在OpenVINO Notebooks GitHub快速上手更多模型,涵蓋從多模態到音訊、再到電腦視覺等廣泛應用場景。

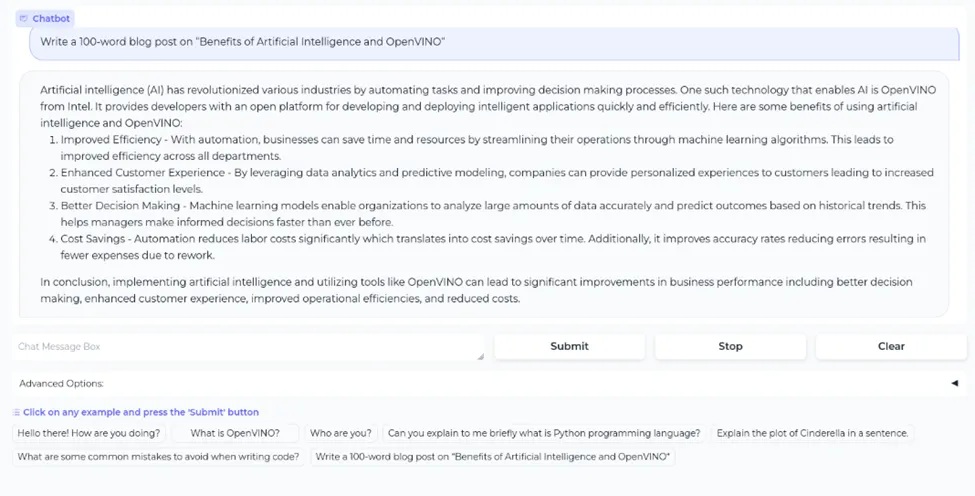

使用OpenVINO創建基於LLM的聊天機器人

NPU支援在不斷發展和擴展,為生產級工作負載提供低功耗的AI加速能力。本次版本中新增了對Qwen3-1.7B、Qwen3-4B和Qwen3-8B等模型在NPU上的支援。NPU能夠持續因應生成式AI模型的高運算強度,同時具備更高的能效,使得AI部署更加容易,且具備更高的性價比。為了幫助你更快在NPU上啟動應用,我們在OpenVINO Hugging Face新增了一系列預轉換和壓縮後的LLM模型,可直接下載使用。

隨著檢索增強生成(RAG)在AI應用開發中持續發揮重要作用,我們正在透過TextRerankPipeline強化OpenVINO GenAI的RAG能力。在已有文字嵌入(text embedding)流水線支持的基礎上,我們新增了文字重排序(text rerank)流水線,用於提升檢索相關性並強化RAG流水線的準確性。現在,在你的RAG流水線中,經過文字嵌入檢索之後,可以利用文字重排序流水線,根據查詢內容的相關性對文字結果進行重新排序。

以下是TextRerankPipeline在Python中的使用範例:

import openvino_genai

pipeline = openvino_genai.TextRerankPipeline(model_dir, "CPU")

rerank_result = pipeline.rerank(query, texts)

對於生成式AI,我們也導入了對結構化輸出(Structured Output)的支援。這對那些希望將AI從對話式工具轉變為可程式設計軟體應用的開發者來說至關重要。軟體需要可預測且可解析的資料格式,以便用於觸發自動化操作、輸入到其他 AI 系統,或支援更多高級應用場景。

現在,OpenVINO GenAI支援以結構化格式生成輸出,例如JSON、規則運算式(regex),或符合 EBNF (Extended Backus–Naur form)語法的結果。

下面的範例展示了如何使用OpenVINO GenAI為單一類型物件(如Person)生成結構化的JSON輸出。該範例使用Pydantic schema來定義生成結果的結構與約束條件。

import json

from openvino_genai import LLMPipeline, GenerationConfig, StructuredOutputConfig

from pydantic import BaseModel, Field

# Define the schema for a person

class Person(BaseModel):

name: str = Field(pattern=r"^[A-Z][a-z]{1,20}$")

surname: str = Field(pattern=r"^[A-Z][a-z]{1,20}$")

age: int

city: str

pipe = LLMPipeline(models_path, "CPU")

config = GenerationConfig()

config.max_new_tokens = 100

# If backend is not specified, it will use the default backend, which is "xgrammar" for the moment.

config.structured_output_config = StructuredOutputConfig(json_schema=json.dumps(Person.model_json_schema()), backend="xgrammar")

# Generate structured output

result = pipe.generate("Generate a JSON for a person.", config)

print(json.loads(result))

這將生成一個符合Person架構的JSON物件,例如:

{

"name": "John",

"surname": "Doe",

"age": 30,

"city": "Dublin"

}

要了解更多關於這些全新OpenVINO GenAI功能及其他內容,請參考以下連結:https://openvinotoolkit.github.io/openvino.genai/

OpenVINO Model Server

我們同樣為OpenVINO Model Server (OVMS) 帶來了強化功能,這些改進也將惠及生成式AI。

支援GGUF的Hugging Face模型現已提供預覽支援,覆蓋了多種主流大語言模型架構,例如 DeepSeek Distill、Qwen2、Qwen2.5和Llama 3。所謂GGUF模型,是指已轉換並最佳化為GGUF檔案格式的模型,該格式能夠在保持原有模型能力的同時,大幅降低記憶體佔用。這使得模型能夠更高效率地在CPU和低功耗設備上運作。

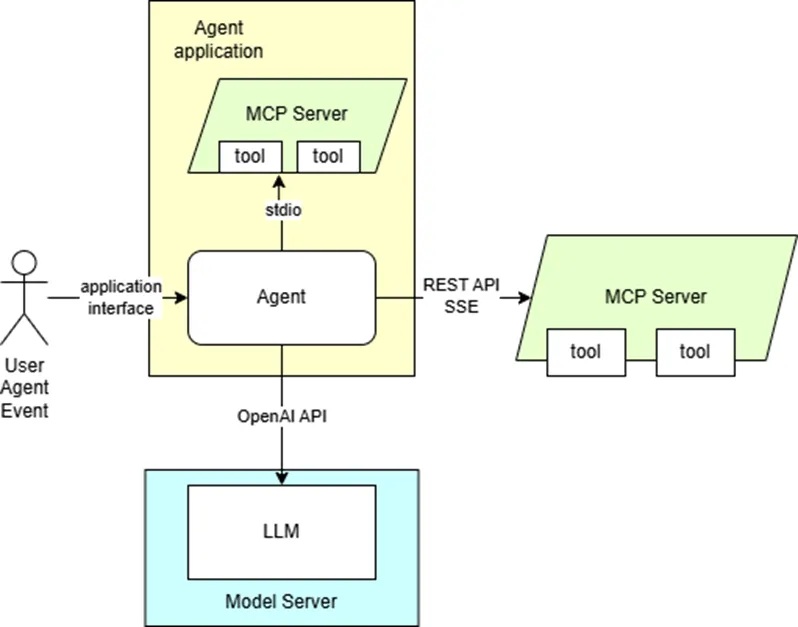

隨著越來越多開發者轉向構建能夠規劃、執行任務和做出決策的AI系統,而不僅僅是對提示做出回應,Agentic AI的熱度正在迅速攀升。Agentic AI的關鍵功能之一就是工具呼叫(tool calling),它使模型能夠連接外部工具和API,從而取得超出原始訓練資料範圍的資訊與能力。現在,OVMS已可用於為AI Agent提供語言模型服務。它支援在內容生成場景中的工具呼叫,例如圖片生成、RAG以及聊天輔助,並且能夠與MCP服務及AI Agent框架整合。

立即參考以下範例開始體驗:使用OpenVINO Model Server實現Agentic AI應用。

Agentic AI範例示意圖

準備好讓你的 AI模型運作得更快了嗎?立即下載OpenVINO 2025.3吧!

- OpenVINO 2025.3: 更多生成式AI,釋放無限可能 - 2025/09/26

- 用OpenVINO GenAI解鎖LoRA微調模型推論 - 2025/08/29

- 用OpenVINO GenAI解鎖LLM極速推論:推測式解碼讓AI爆發潛能 - 2025/04/23

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!