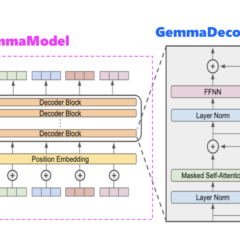

為什麼Gemma採取Decoder-Only Transformer架構呢?

本篇文章會說明Gemma為何會採取Decoder-Only Transformer架構,並針對Decoder-Only Transformer架構進行介紹。

如何從0訓練企業自用Gemma模型

Gemma模型是Text到Text的大型語言模型,非常適合各種文本生成任務。其有多種使用途徑,包括使用新資料來微調Gemma模型、拿Gemma開源程式碼,而從頭開始訓練它,本文將介紹如何從0訓練企業自用Gemma模型。

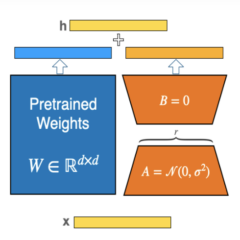

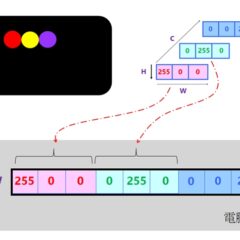

運用BF16與NHWC技術實現進階版LLM微調訓練最佳化

本文要來介紹如何利用BF16半精度浮點數以及將影像資料設為NHWC格式兩項技術,來最佳化大型AI模型的訓練速度與記憶體節省,並延續以

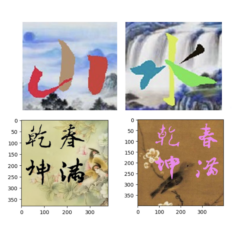

拿大模型程式碼來訓練自用小模型:以AI寫(畫)書法為例

本文會拿Diffusion來學習及創作書法字體,也就是俗稱的:寫書法。雖然Diffusion也能學習依循標準筆順,來逐筆寫出字形。為了從簡單範例出發,本文先讓Diffusion來學習程生成整個字形,而不是逐一生成各筆劃。

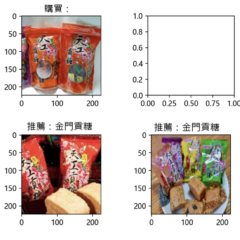

從CLIP應用領會潛藏空間(Latent space)的魅力

本文將從商店櫃檯的產品推薦應用來說明:我們可以拿CLIP的原始程式碼,搭配商家自有產品圖像(Image)和圖像敘述文句(Text),來訓練出企業自用的CLIP小模型,同時也領會其幕後潛藏空間(Latent space)的運作及其效果。