作者:陳邵亨,飆機器人(Play Robot)

隨著機器人硬體發展成熟,開發者越來越容易取得便宜穩定的機器人,也因此,以任務為導向驅動機器人的軟體成為2025年業界討論的主軸。

2025年初,NV開源了GR00T架構。GR00T是一個VLA(視覺-語言-動作)模型,揭示了接下來數年甚至十數年的人形,或者說仿生型機器人AI的可能發展方向。

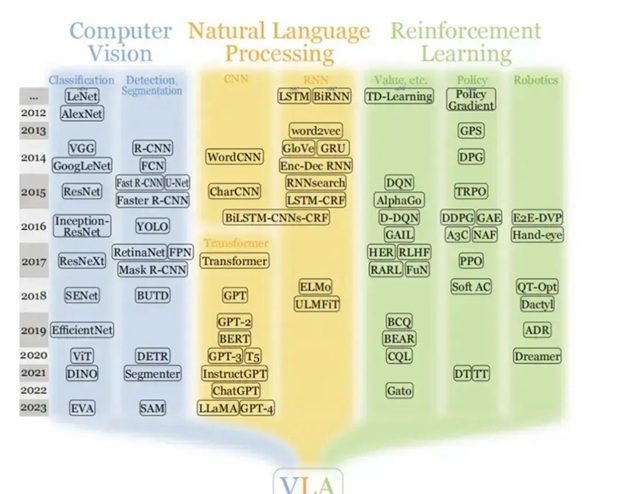

圖1:VLA模型的演進史

然而,要訓練好一個VLA並不容易。即使NV提供了諸如COSMOS等模擬環境來生成大量物理數據,其本身的訓練難易度依然偏高,訓練和執行需要的算力要求也相較傳統AI嚴苛許多。此時,我們將目光放回一個跟GR00T相比比較老一點(但也就只有一點)的技術:AI Agent。

AI Agent賦予機器人更高智慧

AI Agent(中文通常稱AI代理,後文將簡稱代理)是一種對LLM的封裝,透過巧妙的設計讓人類方只需要一次命令,代理就會自行跟LLM多次詢問並規劃出可以調用其他程式工具達成命令目標的流程並執行。可以簡單想像,原本若自行使用LLM類的產品--比方說寫一個複雜的程式。這時候操作者會需要多次跟LLM進行反覆確認和修正,直到完成目標程式為止。而代理的功能就是幫我們完成這些往復確認和拆解任務的動作。

而代理可以拆解為三個關鍵部分:感知,決策以及行為:

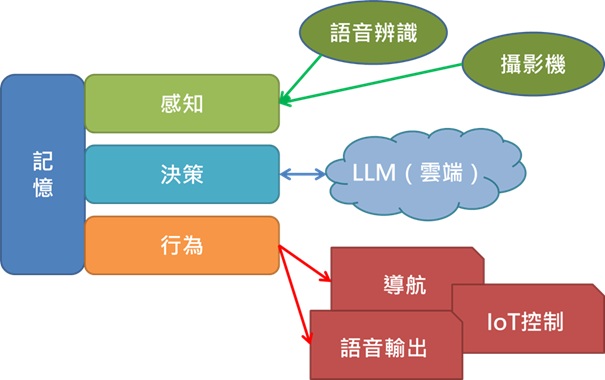

圖2:代理的簡單執行架構

感知部分負責讓機器人認知人類的命令和周遭的環境。鍵盤輸入和語音辨識是常見的文字輸入方式,以機器人來說通常採用語音,屬於非常成熟的邊緣AI;視覺部分可能使用VLM將圖像變成跟文字相等的向量扔給LLM做為輸入,都屬於當前的邊緣端足以支撐運算的技術。

在代理架構中,算力需求最大的無疑是反覆進行決策的LLM。代理會先將使用者的輸入交由LLM分析,生成可以達成目標的逐步步驟,過程中若有呼叫行為執行特定動作,則會將行為執行後的回傳再交回LLM推估下一步。因此在這個過程中LLM將反覆進行非常多次的生成,產生大量算力需求。雖說NPU發展和GPU的小型化使得邊緣端的常備算力越來越高,但目前穩定執行代理所需要的LLM至少需20B的模型,這個量級放在邊緣端跑還是有一點吃力的。

因此LLM使用雲端(或者區域網路內的伺服端)來運算是實務上常見的方案,也已有支援雲端架構的邊緣教育套件:

圖3:邊緣AI代理教育套件實際部署於機械狗,攝於2025 MAI展場

該套件是完整的OpenVINO教學套件,同時也可以直接部署於機器人進行邊緣AI運算。支援邊緣端與雲端兩類LLM,可因應場景條件選擇其中一種方式執行代理--若是網路不方便的環境則採用邊緣端量化,允許的場合則使用線上LLM進行。

此例中,可供呼叫的MCP工具可以包含機器人的移動導航、發送對周圍IoT裝置的控制命令、將感知到的資訊和用戶命令結合生成有效回應等。而這類工具都是行之有年的成熟技術,僅需要依據格式製成工具便可以讓代理呼叫--這也是為何代理架構更容易落地的原因:有效結合已經成熟的舊有技術,在這之上加上LLM帶來的靈活性。

以AI Agent實現仿生機器人應用案例

在撰稿當下的2025年Q4,市場慢慢從純粹導航功能的機器人轉向成需要代理技術才比較容易達成目標用途的機器人。這類機器人有幾個共同特色:需要和人互動、任務場景較複雜以及使用的機器人形式不固定。這邊所指的形式不固定是指機器人開始擺脫原本單純的輪型+上面的加裝機構,轉而開始出現狗形、人形等需求形式。

圖4:台灣代理商導入的仿生人形與狗形系列

仿生機器人由於型態各異,採用VLA架構將會需要一定的調整時間,不利於應用快速落地。此時使用代理架構,不僅運動部分僅需要依照各機體原生的SDK進行串接,也可導入各專業廠商成熟的軟體產品,作為代理可呼叫的行為工具,直接達成商用等級的機器人應用。

隨著AI發展成熟,使用AI代理技術的例子也越來越多。我們按照前面介紹的順序,先從可以完全在邊緣端執行的低參數量LLM看起。第一個案例是2025年初的OpenVINO邊緣代理範例,採用的是ReAct的範例:

此範例屬於代理架構較早期的方案,可調整部分較多也較複雜。近期比較常見的作法會將ReAct部分整合成固定架構,僅留下定義工具的部分,也就是前面提過的MCP。

我們在之後也基於OpenVINO的MCP範例改製了一份更精簡的案例,這個範例和第一個例子完全相同。工具端加入了VLM,並在輸入輸出端同樣加上語音辨識及生成。最終達成語音辨識輸入代理→代理判斷執行步驟→呼叫工具→代理整理結論後語音輸出的相同結果。此範例也會在12月2日舉辦的Intel 邊緣AI研討會參與展出。

MCP的成熟化很好的將機器人的語音、文字和影像整合在同一個任務流程中,並僅在需要的時候以工具的形式呼叫以達成AI任務。在邊緣端,每一分算力都影響著機器人的續航時間,這種形式無疑是較為理想的邊緣實現方案。且對於非專業人員來說,不需要展開ReAct的複雜架構心理壓力也較小一點。

前兩個範例我們使用OpenVINO的邊緣端代理範例,在執行動作的代理上已經有相當不錯的表現,且執行資源需求較低。但如果需要面對的是更複雜的場景,就需要更大一點的LLM才能保證跟用戶互動的穩定性。

在2025年的自動化展,運用MCP架構,將LLM更替為台灣廠商訓練的雲端LLM,並把和其他機械狗的通訊新增為MCP工具。人型機器人負責接收現場參訪者的對話、回應現場各種語音需求。做為代理的中樞也負責規劃行為流程,包含自身的控制命令以及送出命令給另外兩隻狗型機器人。當代理判斷客戶需要做表演或介紹,便會呼朋引伴和機械狗一起對參訪者介紹自己。

圖5:自動化展多機器人迎賓

從以上範例可以看到,邊緣AI和LLM搭配的代理架構在部署應用上確實有著極大的彈性和便利性。對於邊緣算力的要求也相對較小,讓他非常適合用在對大小、散熱、功耗都有所限制的機器人上。

而在工業巡檢領域,隨著任務和場域漸趨複雜,傳統方法的導航機器人慢慢難以應對。此時導入MCP結合VLM與導航(或有稱之為語意地圖),以及原先的成熟邊緣AI辨識方案後,使用者將能以自然語言口頭交代這些複雜的巡檢任務,透過LLM的推論讓機器自主完成複雜的檢查工作。

圖6:機械狗於廠區巡檢示意

結語

未來,邊緣硬體可能發展到足以讓VLA可以執行,也可能軟體端的模型最佳化已經強大到可以讓VLA在極低算力下執行。但無論如何,傳統的邊緣AI依舊具有反應速度、維護難易度和技術成熟度這幾個優勢,繼續在各種邊緣裝置及機器人中以零組件的方式佔據一席之地。

- AI Agent時代來臨:看邊緣AI如何成為驅動智慧機器人的關鍵 - 2025/11/28

- OpenVINO×ExecuTorch:解鎖英特爾架構AI PC模型推論效能新境界 - 2025/11/21

- 讓生成式AI應用在Intel架構系統本地端高效率運作的訣竅 - 2025/10/16

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!