作者:Felix Lin

台灣Maker圈對於瑞薩電子(Renesas)這家日系半導體龍頭可能稍微比較陌生,但實際上,瑞薩在微控制器(MCU)領域的市佔率排名一直以來都是名列前茅,尤其是在講求高可靠度的車用電子與醫療電子領域,都佔有相當份量的一席之地。對Maker與玩家來說近期比較關聯的事件,則可以追溯到去(2024)年中Arduino發表了經典開發板的第四代UNO R4 Wi-Fi與UNO R4 Minima,就是使用了瑞薩RA系列的微控制器RA4M1。

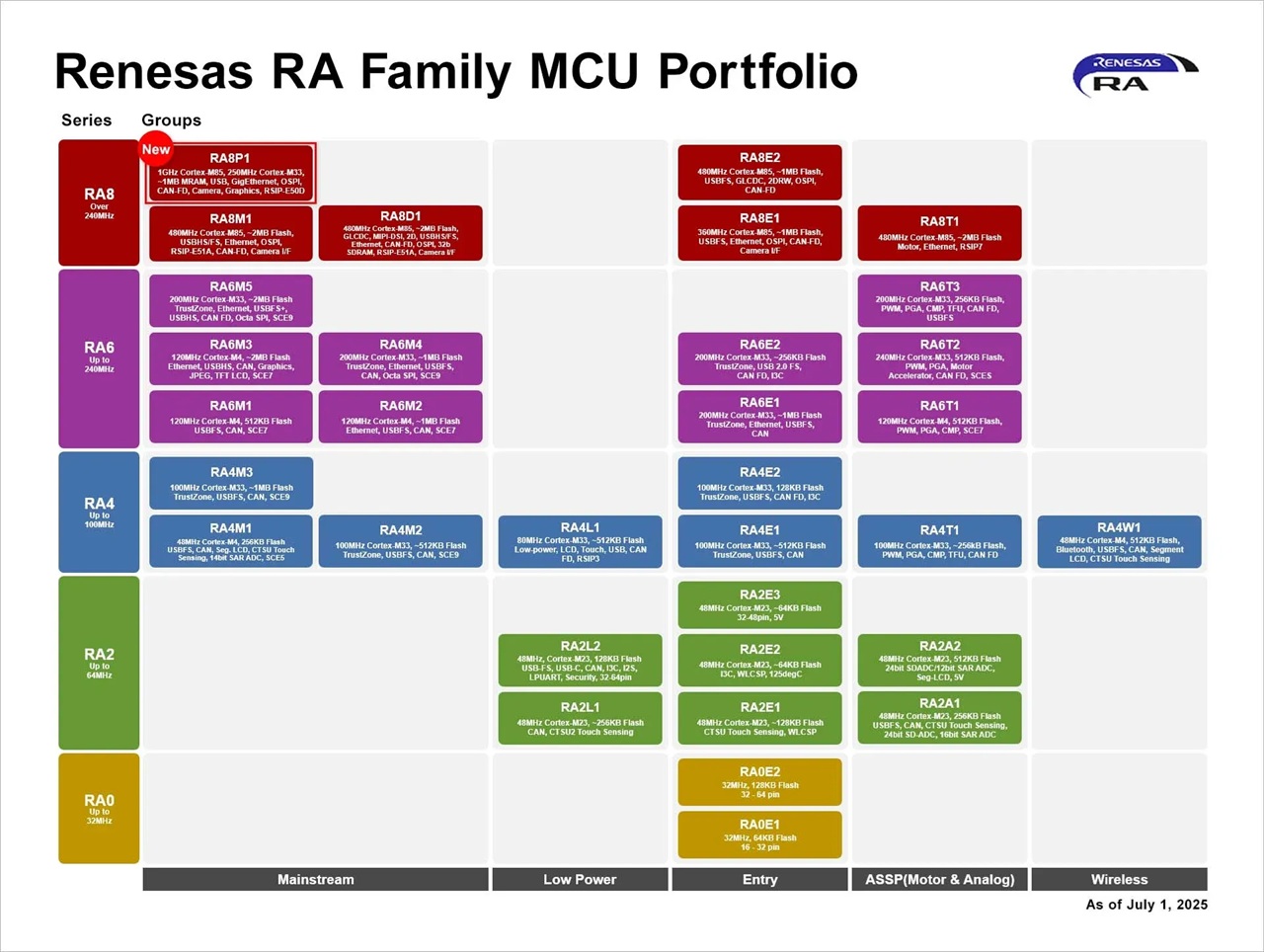

RA系列屬於瑞薩Arm Cortex架構的MCU,如下圖所示,縱向依照運算架構能力可以分為RA0 (M23低時脈)、RA2 (M23高時脈)、RA4 (M33, M4低時脈)、RA6 (M33, M4高時脈),以及性能最強的RA8 (M85) 。橫向則依據周邊搭配與應用屬性,分為主流(Mainstream)、入門(Entry)、低功耗(Low Power)、與馬達控制(Motor & Analog)等應用需求做區別,如UNO R4的處理器RA4M1,就代表其定位在M4低時脈主流產品線的位階。

瑞薩RA系列MCU一覽表(圖片來源: Renesas)

RA8P1 MCU甫於今年七月初問世,有別以往瑞薩MCU命名規則,首次使用了 「P」(Performance)作為型號命名,強調其為首款具備AI/ML推論應用的MCU。RA8P1核心為時脈1GHz Coretx-M85搭配250MHz Cortex-M33 的異質雙核心架構,CoreMarks效能分數超過7300。AI推論採用Helium MVE與Ethos-U55 NPU,提供 256 GOPS算力,同時也宣告著日後在MCU邊緣裝置上進行視覺AI推論搭配工業控制應用或HMI顯示介面也非難事。本文筆者將使用Renesas RA8P1的開發板EK-RA8P1實際來進行測試評估。

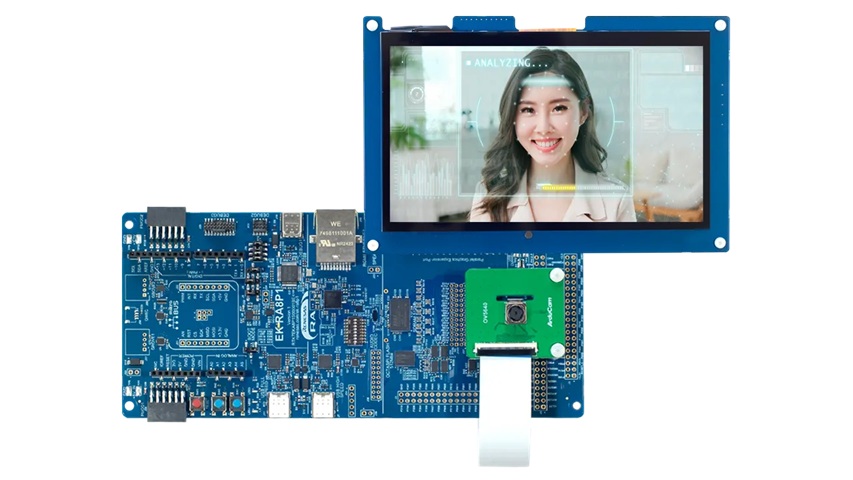

EK-RA8P1評估套件

EK-RA8P1 evaluation kit內部包含了三塊電路板,分別是RA8P1晶片開發板、7” LCD 1024×600顯示擴充板,與OV5640五百萬像素攝影鏡頭擴充板,組裝後如下圖。相較於其他MCU的開發板,RA8P1晶片開發板顯得相當巨大,不外乎是為了289 pin BGA 封裝的MCU所有接腳引出之外,常用的連接器介面如RJ45乙太網路(RGMII)、USB High/Full Speed、Audio Codec、MEMS麥克風、Octo-SPI Flash、SDRAM、Arduino Shield介面、Grove、Qwiic、mikroBUS、Pmod,以及on board SEGGER J-Link等,一應俱全。

EK-RA8P1開發套件。(圖片來源:Renesas)

如此高效能的MCU還能夠兼具低耗電的特性嗎? RA8P1採用使用台積電(TSMC) 22nm 超低漏電(Ultra-Low Leakage,ULL)製程技術,在相同的運作頻率下,電晶體的功耗更低、速度更快,物理的先天優勢就有低待機漏電流體質。再加上三個異質核心M85、M33、U55各司其職,只負責自己最擅長的事:

- Cortex-M85@1 GHz高效能應用核心。執行主要應用程式與複雜運算,搭配Helium (MVE)處理DSP或ML前後處理任務。

- Cortex-M33@250 MHz即時與安全核心。執行常態即時性與管理性任務,必要時再把M85大核喚醒,並且包含TrustZone安全隔離區。

- Ethos-U55@500 MHz AI加速器。NPU可把CNN/RNN推論的能耗大幅壓低,AI推論效能可達256 GOPS等級,獨立於前兩者MCU運作。

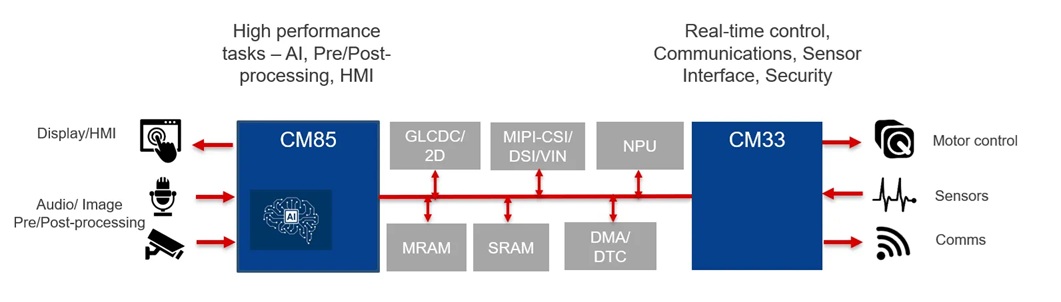

如同下圖所示,RA8P1內部的Cortex-M85與Coretx-M33之間有共用的資料匯流排,同時還有彼此溝通的FIFO與Semaphore實現硬體的處理器間通訊。外部則由M85處理高效能運算如影像與顯示介面等,M33處理即時性運算如馬達控制與感測器等。

RA8P1內部Cortex-M85與Coretex-M33。(圖片來源:Renesas)

安裝FSP with e2Studio

開發MCU通常都會用上整合式開發環境(Integrated Development Environment,IDE),瑞薩針對不同的MCU家族提供各自對應的IDE ,以RA系列來說則是使用e2studio搭配Flexible Software Package (FSP)進行開發。e2studio是以著名的開源IDE Eclipse為基礎修改而來的,功能相當強大且外掛資源豐富,若是有使用Eclipse IDE應能快速適應。

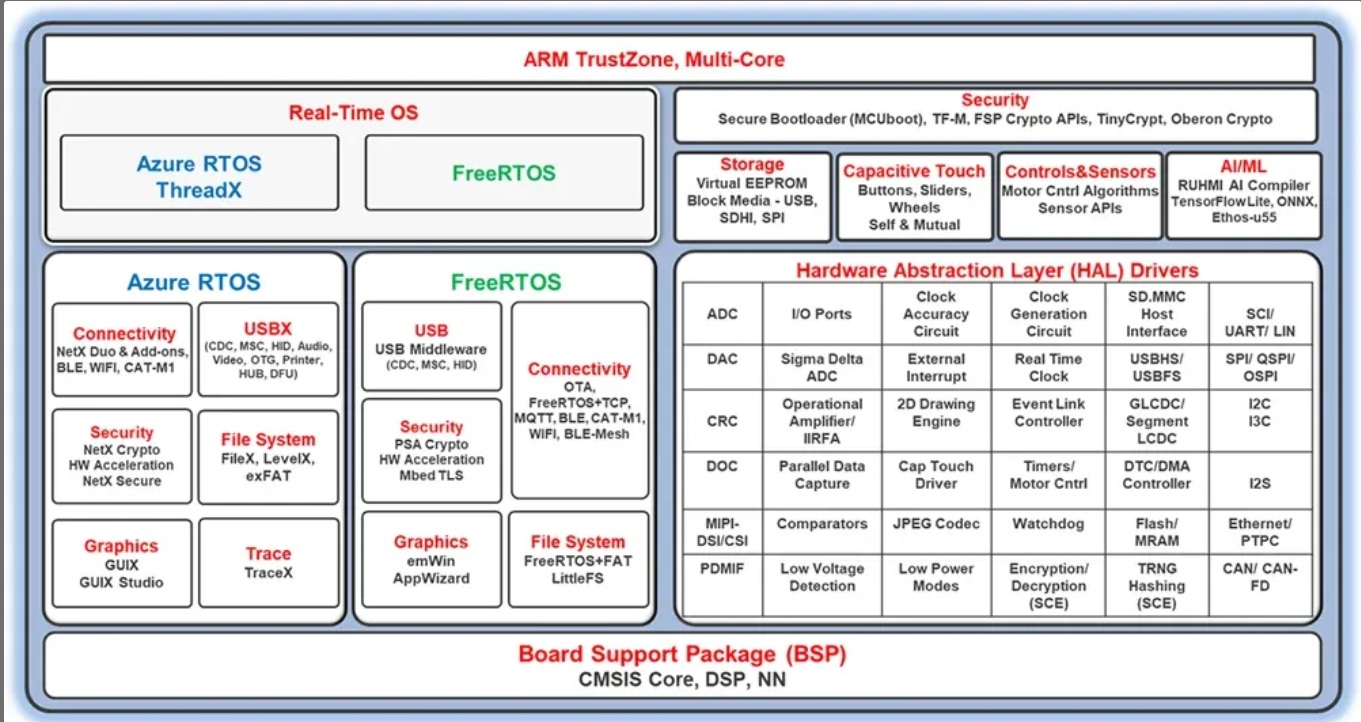

而FSP可以理解為 BSP (Board Support Package,開發板支援套件)、 HAL (Hardware Abstraction Layer,硬體抽象層)、Middleware (中介軟體)、RTOS (即時作業系統)等軟體的整合套件(如下圖所示),對於RA家族所需要的軟體開發資源都整合於此,且同時開源在github上。

Flexible Software Package (FSP) 內容示意圖。(圖片來源:Renesas)

筆者將以建議安裝的FSP + e2studio的搭配組合說明,如果是已經習慣使用Keil MDK或是IAR的開發者,瑞薩同時也提供了對應此兩套第三方IDE的FSP安裝套件,不論是習慣哪一種開發環境,都可以使用相同的函式庫與HAL API進行開發。

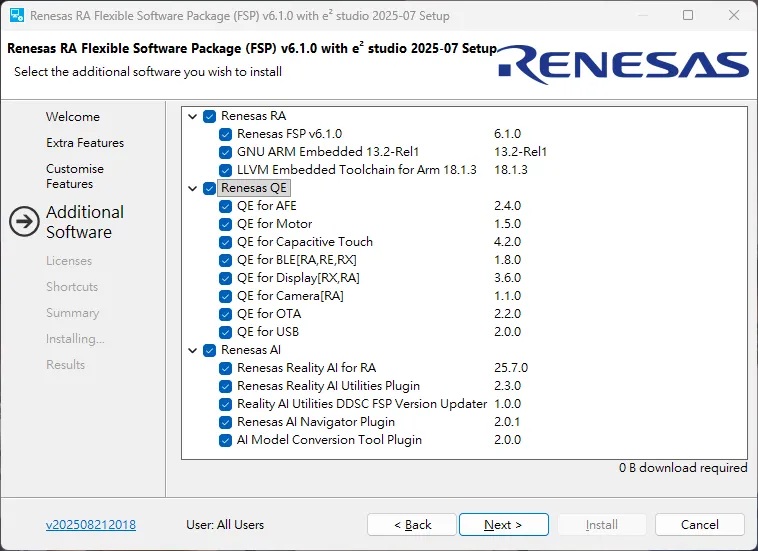

而雖然e2studio與FSP為兩套不同的軟體,但彼此之間可能會有版本搭配性問題,因此瑞薩提供了最簡易的安裝方式,可以一次安裝所需要的套件,並且支援Windows、Linux與MAC多平台。筆者的作業系統為Windows,在撰文當下最新版本為V6.1.0 ,因此下載FSP Windows Platform Installer V6.1.0 (setup_fsp_v6_1_0_e2s_v2025-07.exe) 進行安裝。

執行後提供 “Quick Install” 與 “Custom Install” 兩種安裝選項,筆者建議可以選擇後者 “Custom Install” 客製化安裝,並且在安裝流程的 “Customise Features” 與 “Additional Software” 兩個步驟需要選擇欲安裝的軟體元件,把所有能安裝的都給裝上。即便軟體或外掛都可以後面選擇性追加安裝,但開發過程最怕要用時缺東缺西,增加額外的時間成本。最後就是依循著安裝步驟的指引,等待所有軟體都安裝完畢即可!

筆者建議可以將能裝的軟體元件一次性安裝,避免後續開發的困擾

RUHMI

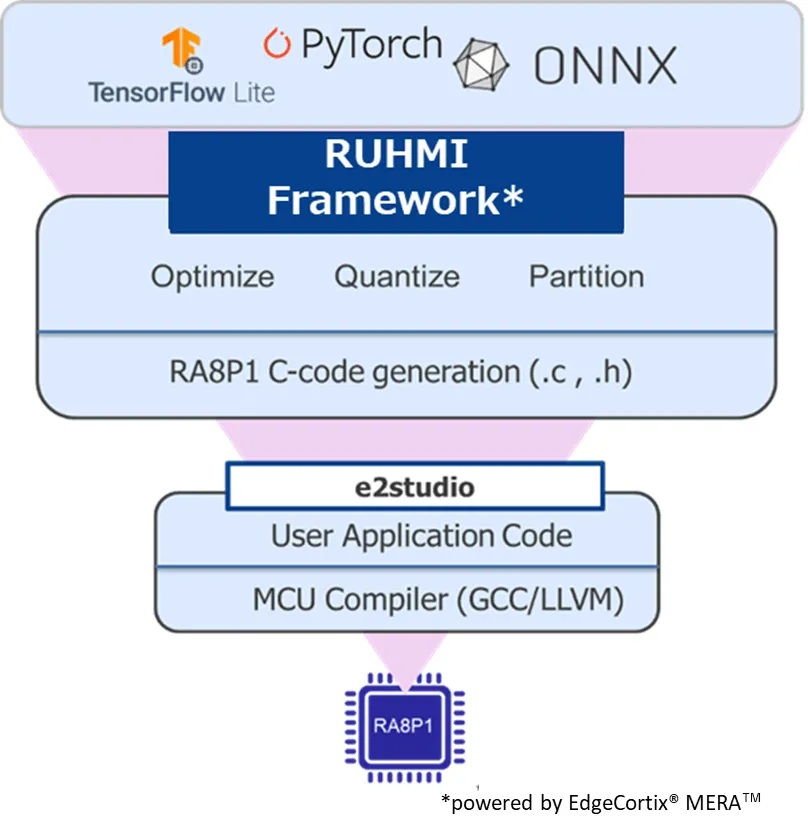

Renesas RUHMI (Robust Unified Heterogenous Model Integration)是一套提供給RA8P1的AI模型編譯器與部署框架(如下圖),可把TensorFlow Lite、ONNX等模型經過最佳化、量化與切割後,自動轉成MCU可編譯的C程式碼,並且選擇單獨運作於CPU或是搭配Ethos-U55 NPU實現高效能推論。而這套程式碼可以適應FSP框架在e2 Studio中和使用者應用程式做整合,打包成AI邊緣運算應用。

RUHMI 框架示意 (圖片來源:Renesas)

要在 Windows 上安裝 RUHMI 也僅需幾個簡單步驟,首先須安裝微軟 VC++ 可轉散發套件與Python 3.10。完成後在windows power shell下建立虛擬環境,這邊須留意虛擬環境的路徑必須為.ven,因為e2studio必須認此虛擬環境目錄,若是使用其他目錄後續在e2studio可能會執行失敗。

cd e2_studio

py -3.10 -m venv .venv

接著將當前目錄設定為 CONVERSION_TOOL_E2STUDIO_PLUGIN_PYTHON_VENV_LOC 環境變數,方便給e2studio查找。並且設定允許執行網路來源的腳本:

[Environment]::SetEnvironmentVariable('CONVERSION_TOOL_E2STUDIO_PLUGIN_PYTHON_VENV_LOC', "$(Get-Location)", 'User')

Set-ExecutionPolicy -ExecutionPolicy RemoteSigned -Scope Process

啟用虛擬環境:

.venv\Scripts\Activate.ps1

從github下載最新版本RUHMI,由於筆者撰文時RUHMI最新Release版本為2025-07-04,因FSP 6.1.0是8月28日釋出的,RUHMI 應下載其後的版本才能有較好的匹配:

git clone https://github.com/renesas/ruhmi-framework-mcu.git

安裝所需python模組:

cd .\ruhmi-framework-mcu\install\

python -m pip install .\mera-2.4.0+pkg.179-cp310-cp310-win_amd64.whl

python -m pip install onnx==1.17.0 tflite==2.18.0

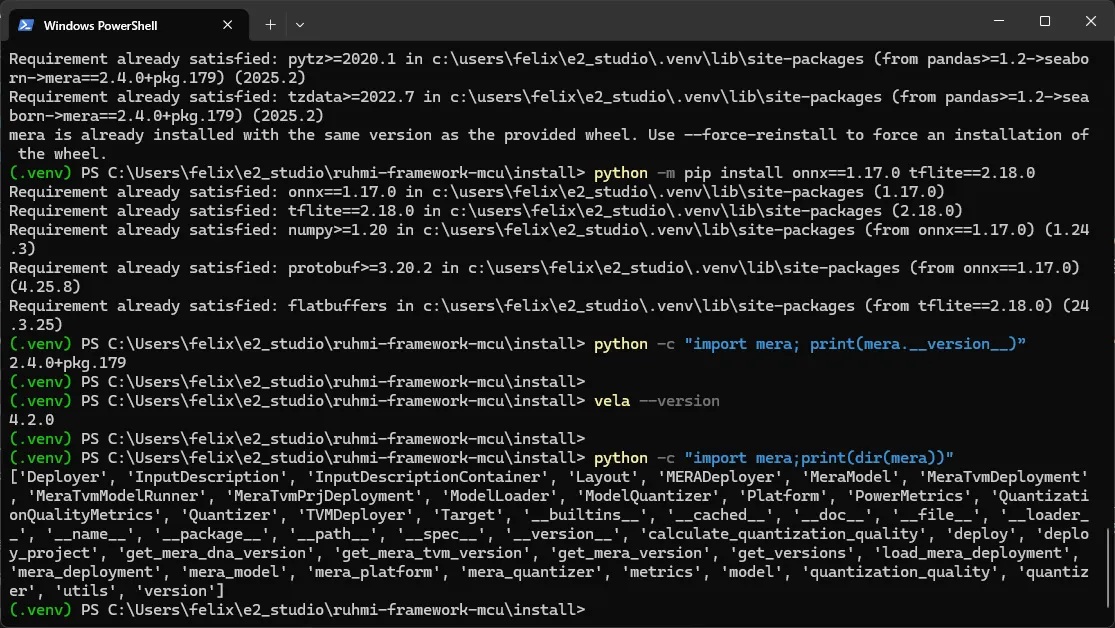

完成後輸入以下指令,確認是否有順利安裝成功:

python -c "import mera; print(mera.__version__)”

vela --version

python -c "import mera;print(dir(mera))"

若出現如下圖所示的2.4.0+pkg.179、4.2.0等則代表已安裝成功,稍後即可以進行AI模型轉換了!

安裝python模組後驗證安裝版本與正確性

燒錄範例程式

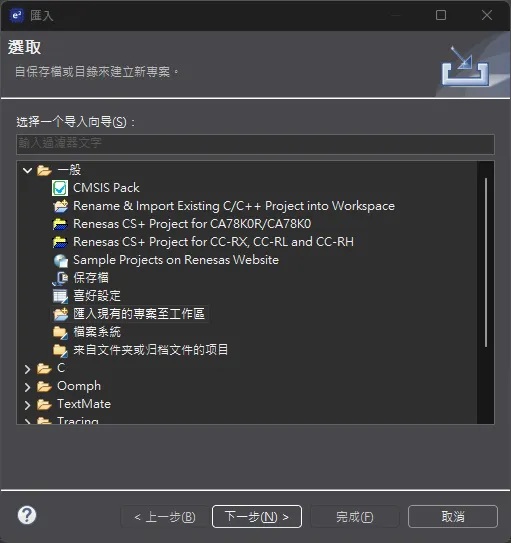

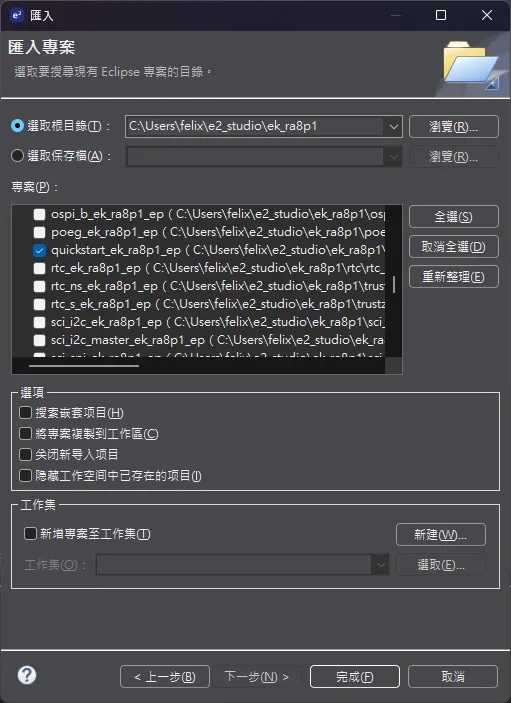

瑞薩官方的EK-RA8P1 Example Project Bundle裡面包含各種類型的範例程式提供RA8P1的開發者參考與使用,本段落將實際使用e2Studio匯入專案,並且在編譯後對EA-RA8P1進行燒錄與除錯。開啟e2studio後,從功能列選擇「檔案」 → 「匯入」,並在對話框中選擇「匯入現有的專案至工作區」,然後點選「下一步」。

匯入專案

將EK-RA8P1 Example Project Bundle解壓縮後會有一個ek_ra8p1的資料夾,在對話框中的「選取根目錄」指定到該資料夾,下方專案列表會出現所有此資料夾內的專案。找到 quickstart_ek_ra8p1_ep專案,勾選後點選下方「完成」進行匯入到 IDE 的動作。

勾選quickstart_ek_ra8p1_ep

匯入專案後可以直接點選e2Studio IDE 左上角的鐵鎚圖示進行「build」開始進行編譯,若在tool chain都正常安裝的情況下,最終會出現類似以下訊息表示編譯成功:

Extracting support files...

23:58:28 **** 项目quickstart_ek_ra8p1_ep配置Debug的建置 ****

make -r -j16 all

arm-none-eabi-size --format=berkeley "quickstart_ek_ra8p1_ep.elf"

text data bss dec hex filename

5736252 15080 18142169 23893501 16c95fd quickstart_ek_ra8p1_ep.elf

23:58:32 Build Finished. 0 errors, 0 warnings. (took 4s.403ms)

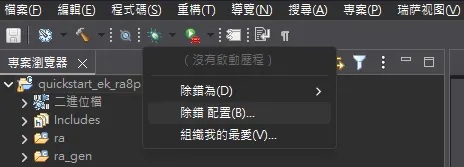

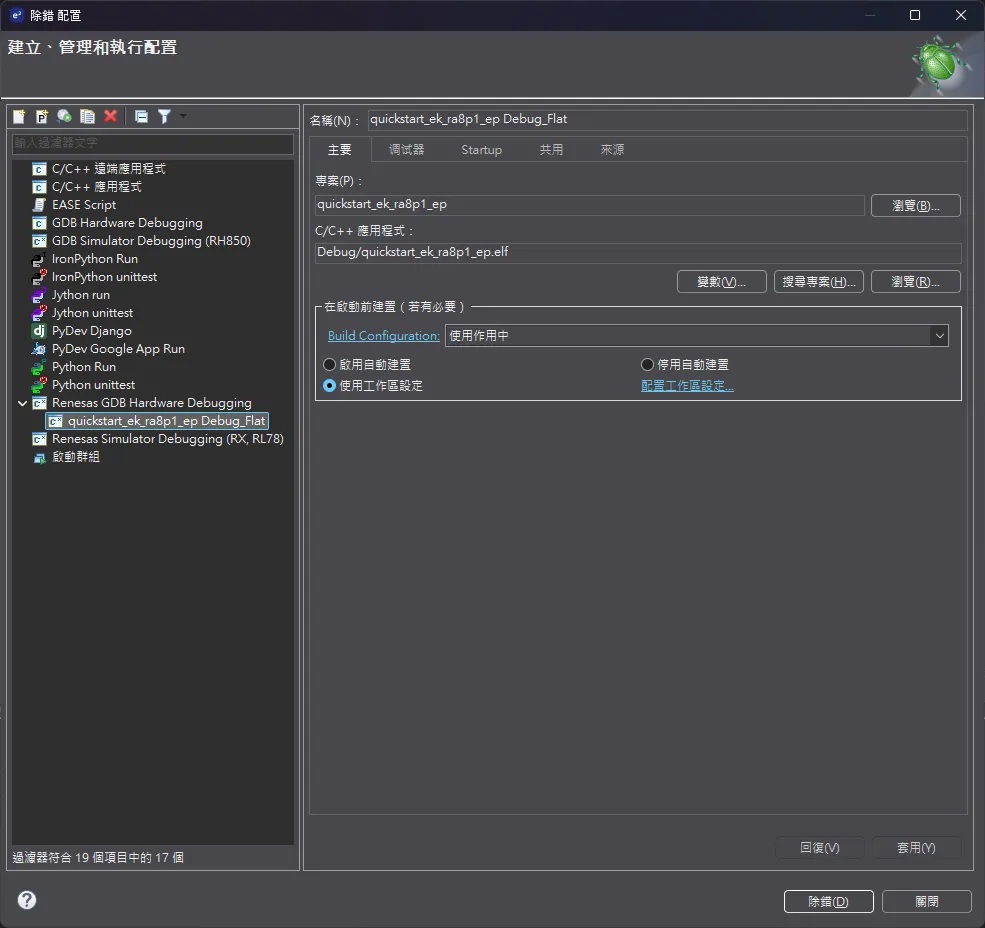

接著準備一條USB-A to USB-C傳輸線連接電腦到EK-RA8P1 的 J10 USB-C 介面上,評估版上電源指示燈會點亮。回到e2Studio IDE中,點選蟲子圖示旁的箭頭,選擇「除錯配置」。

debug按鈕及其選項

在開啟的對話框中左側欄位選擇到目前的quickstart_ek_ra8p1_ep專案,右側的頁籤「調試器」可以確認一下是否將Debug Hardware選為「J-Link ARM」,完成後點選下方「除錯」按鈕。 e2Studio會先將程式燒錄進評估版中,然後啟動GDB Server將處理器拉回 reset 處開始進行Debug程序,此時 e2Studio 的視窗也會切換為 Debug 的視窗配置,可點選左上角的播放箭頭圖示讓處理器開始運作。

Debug設定

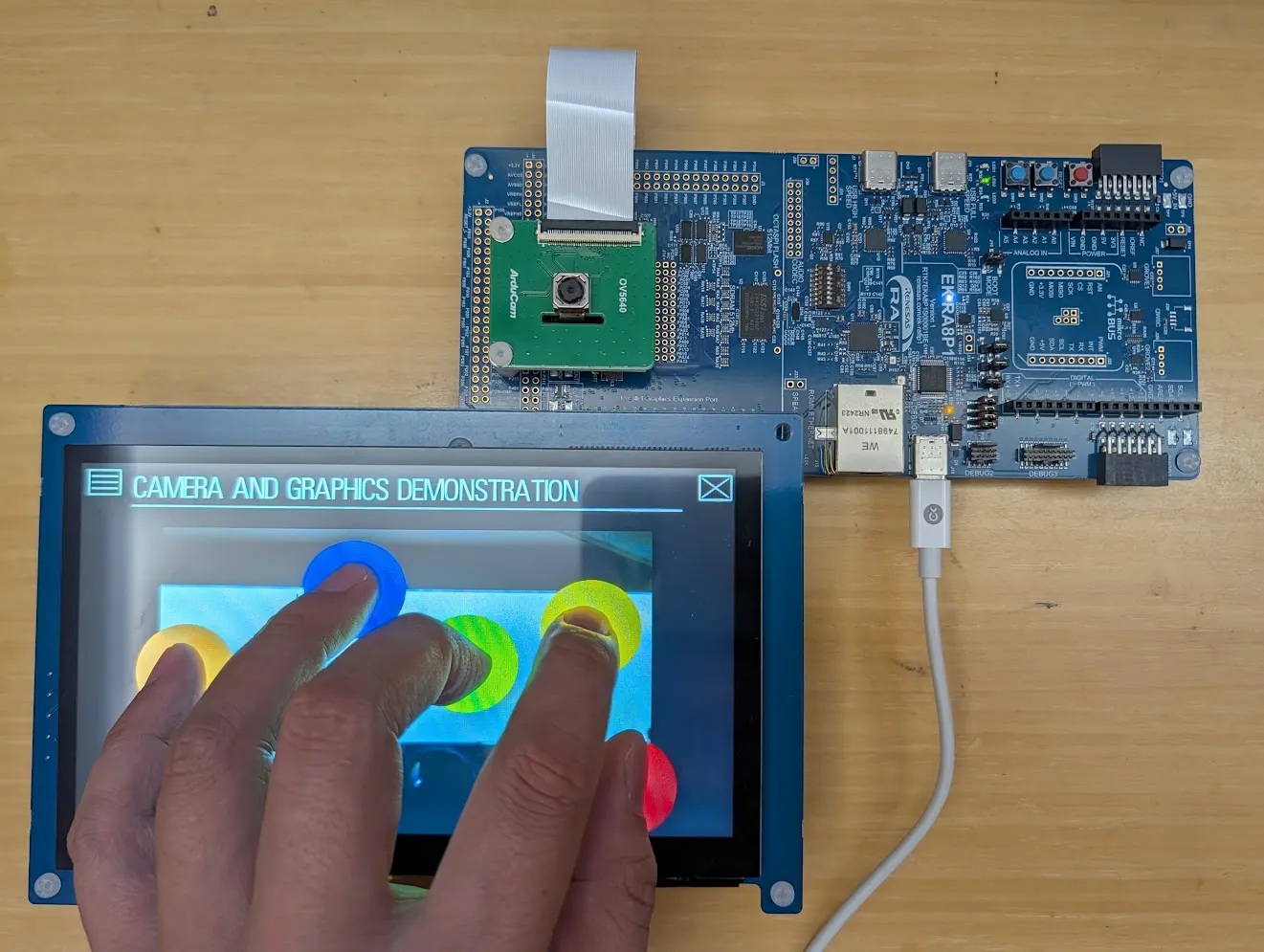

等待系統初始化完成後,EK-RA8P1的觸控螢幕將顯示「GETTING STARTED」說明資訊,點選左上角的「Application Menu」圖示會跳出五個選項,包含Kit Information、Getting Started、User LED Control、Display、Next Steps等,開發者可以逐一進行把玩測試,同時也可以開啟終端機軟體使用buadrate 115200, 8, N, 1進行通訊控制。比較有趣的是 ,Display展示項目中可以即時顯示OV5640 Camera模組的影像串流,並且可以測試觸控螢幕的多點觸控功能。

quick start範例中camera串流與多點觸控展示

MCU實現視覺模型推論

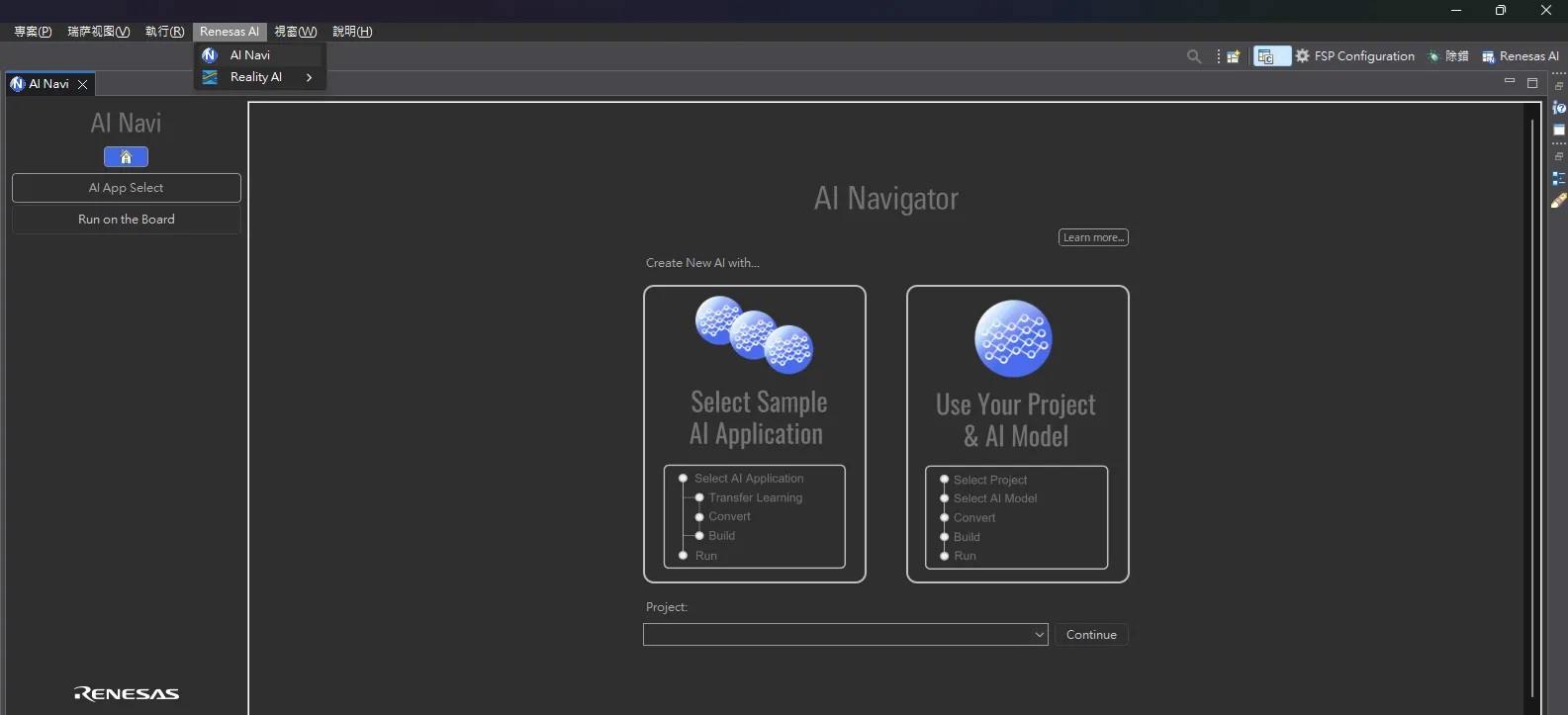

前段的「Hello World」範例若是正常運作,就可以進入到RA8P1的主場--MCU Edge AI推論了!在e2Studio功能列上找到「Renesas AI」→ 點選「AI Navi」開啟AI Navigator視窗,點選「Select Sample AI Application」選擇要導入的AI應用範例。

整合在e2Studio中的AI Navigator

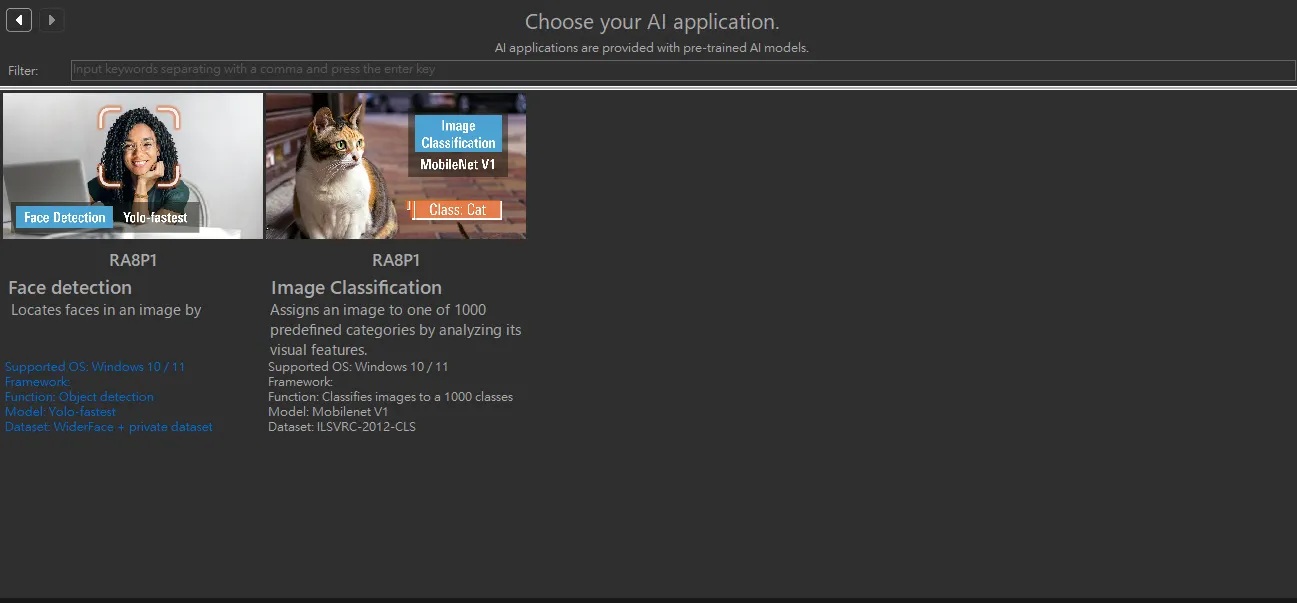

目前僅有「Smart City」可供選擇,另一個「Notice」則是提醒請務必搭配FSP 6.1.0一起服用。點選「Smart City」後出現兩個範例分別為「Face Detection」(人臉偵測)與「Image Classification」(影像分類),本篇將以 Image Classification進行說明。

目前RA8P1提供人臉偵測與影像分類範例

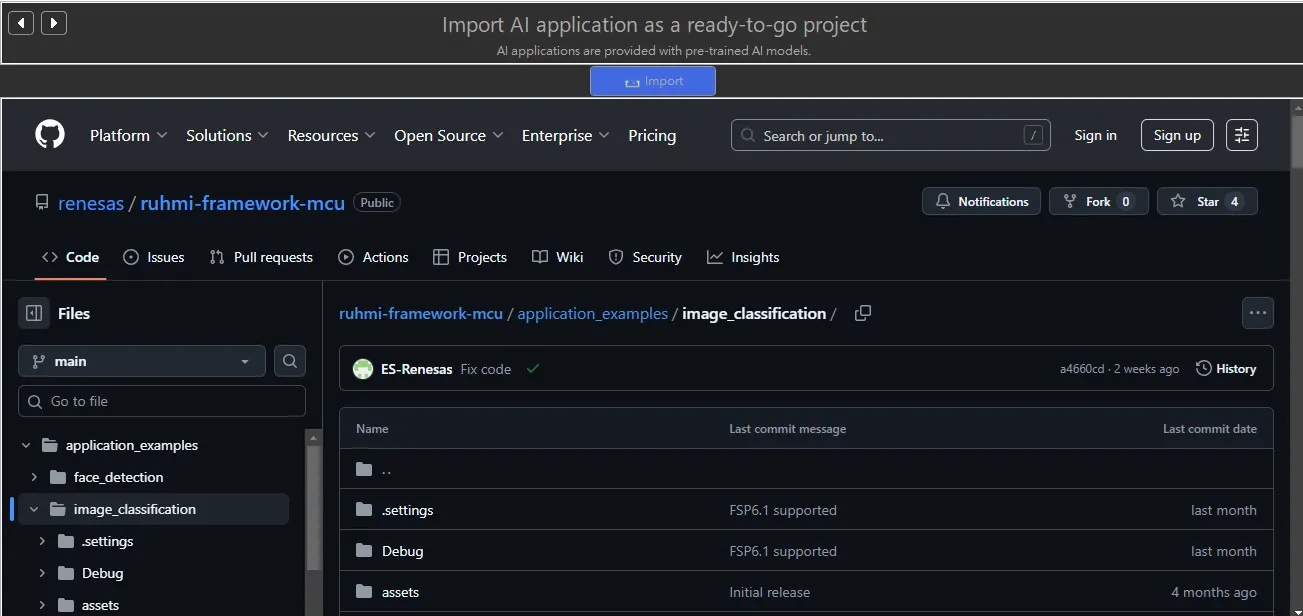

選擇後會開啟ruhmi-framework-mcu的github repo網頁,點選上方的「Import」按鈕進行匯入。AI Navi會從repo下載專案到開發工作目錄中。

連接到GitHub進行匯入

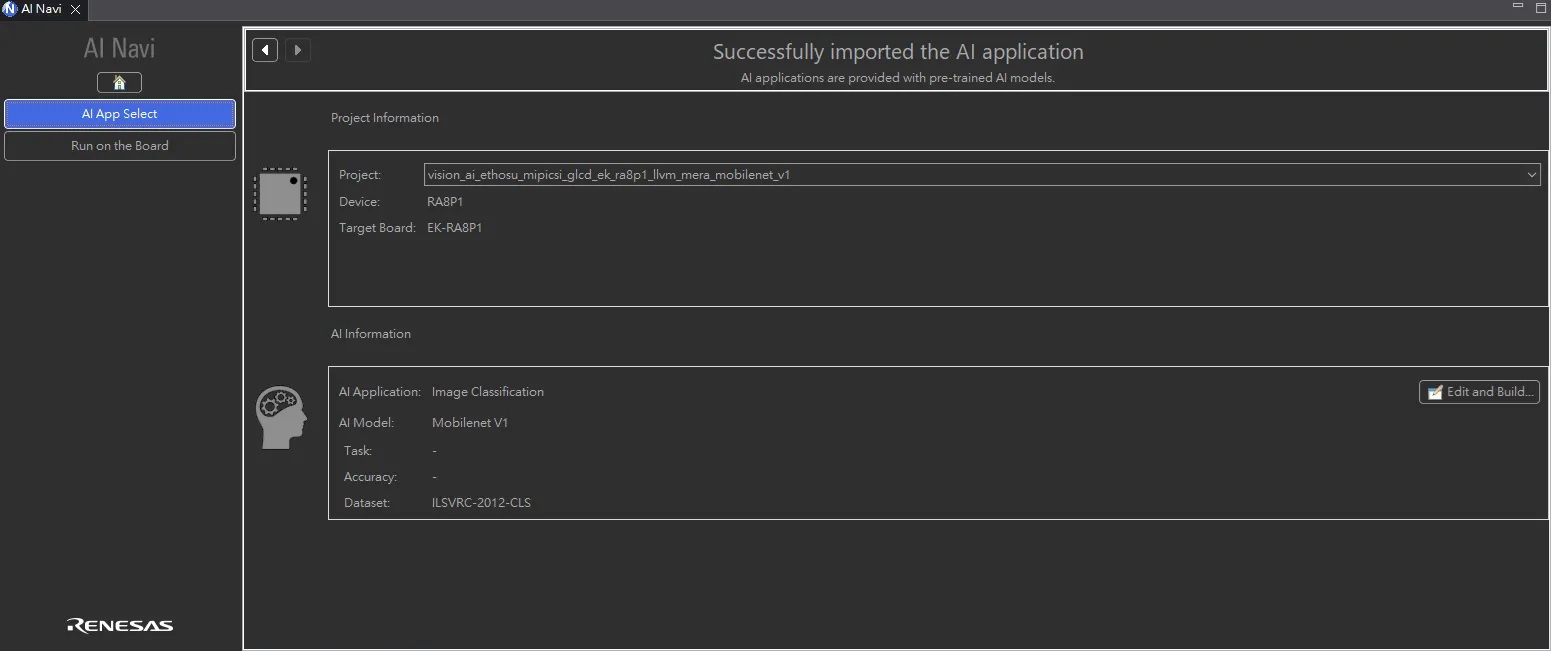

完成匯入後顯示目前專案與AI模型的相關資訊,右側有「Edit and Build」的按鈕可以修改專案程式碼,或是開啟AI模型轉換工具更換模型。

匯入完成後的專案資訊

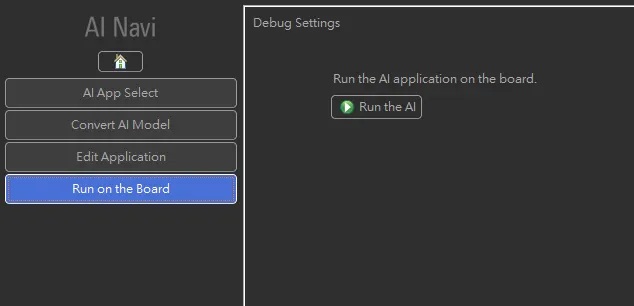

筆者建議這裡可以直接點選左側「Run on the Board」按鈕,再點選「Run the AI]進行編譯並且燒錄到開發板中,實際執行範例程式。

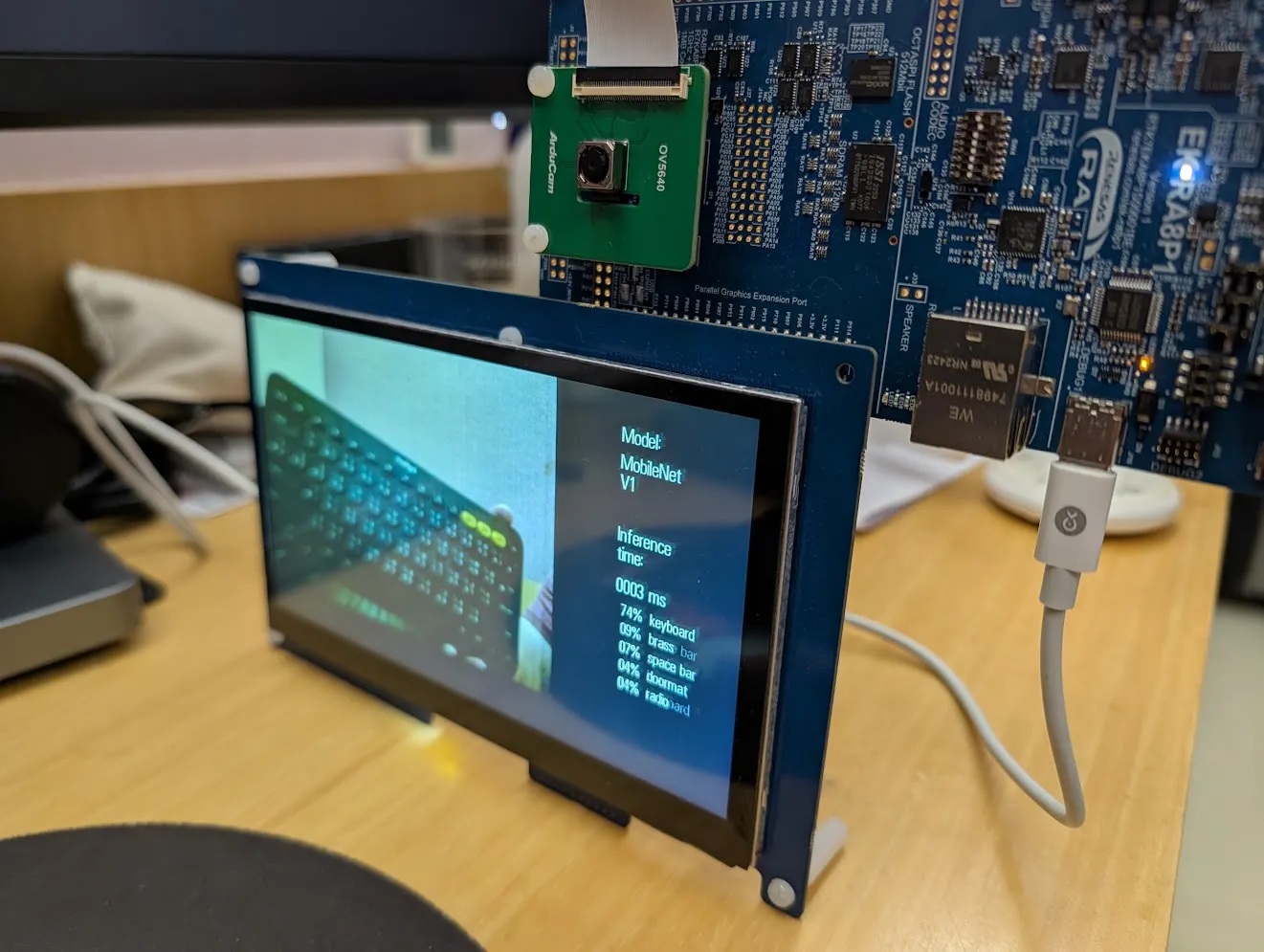

範例程式使用的模型是MobileNet V1 (alpha=0.25) 執行影像分類推論,模型大小相當精簡,但辨識精確度卻也不含糊。如下圖可以看到順利辨識鍵盤影像,並且推論時間僅花費3ms。

MobileNet V1推論僅花費3ms

自定義模型轉換

若要將前段所使用的範例程式內的模型更換成自己的模型,在e2Studio已整合的AI Navigator工具內執行也相當容易,只要簡單幾個步驟就可以無痛進行轉換。

STEP 1:準備模型。基本上只要是TensorFlow Lite都可以進行轉換,筆者為方便說明,使用在前面段落中下載的RUHMI有的MobileNet模型作為範例。首先需啟動虛擬環境,並移動到工作目錄:

cd e2_studio

.\.venv\Scripts\Activate.ps1

cd .\ruhmi-framework-mcu\application_examples\

執行下方指令,完成後會產出alpha為0.25的MobileNet V1的預訓練模型,檔案名稱為mobilenet_v1.tflite。

python generate_IC_model_tflite.py

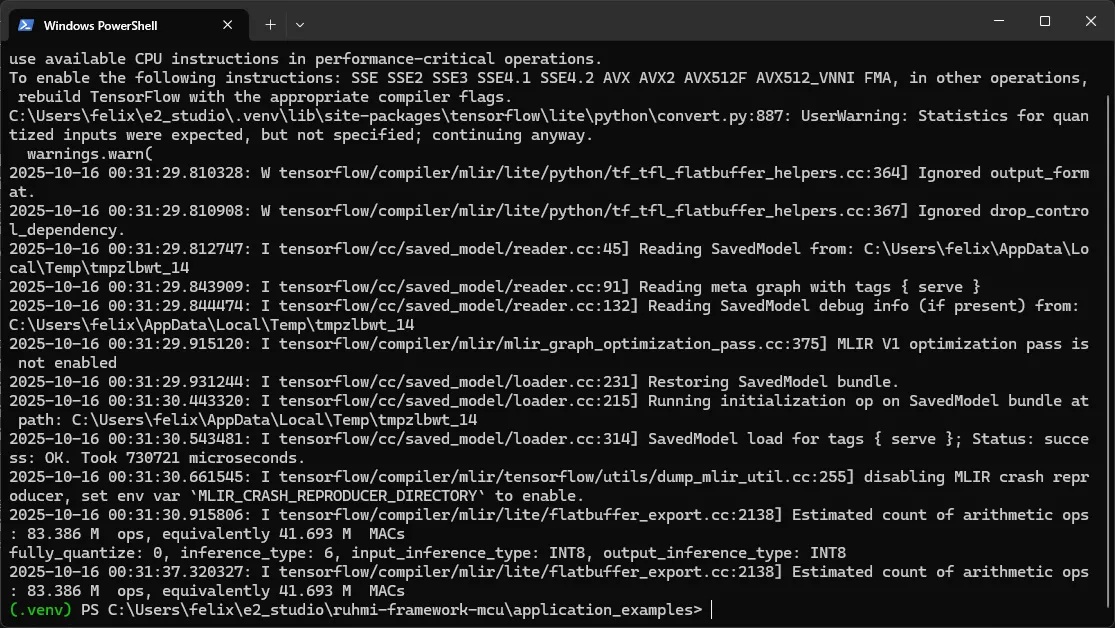

參考log如下圖所示:

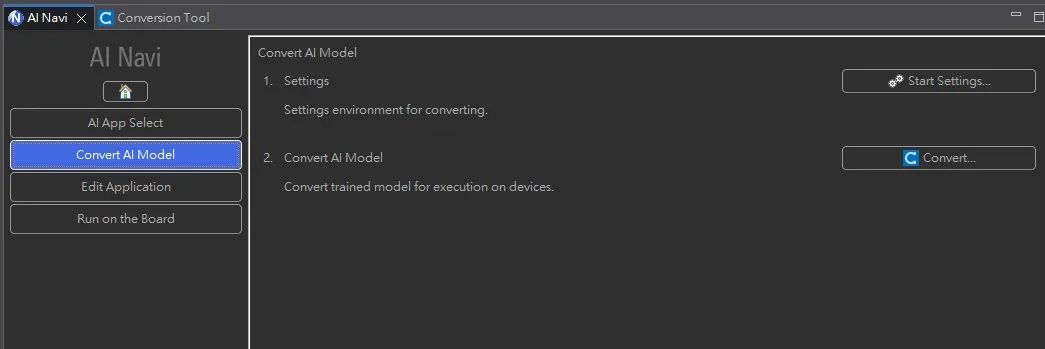

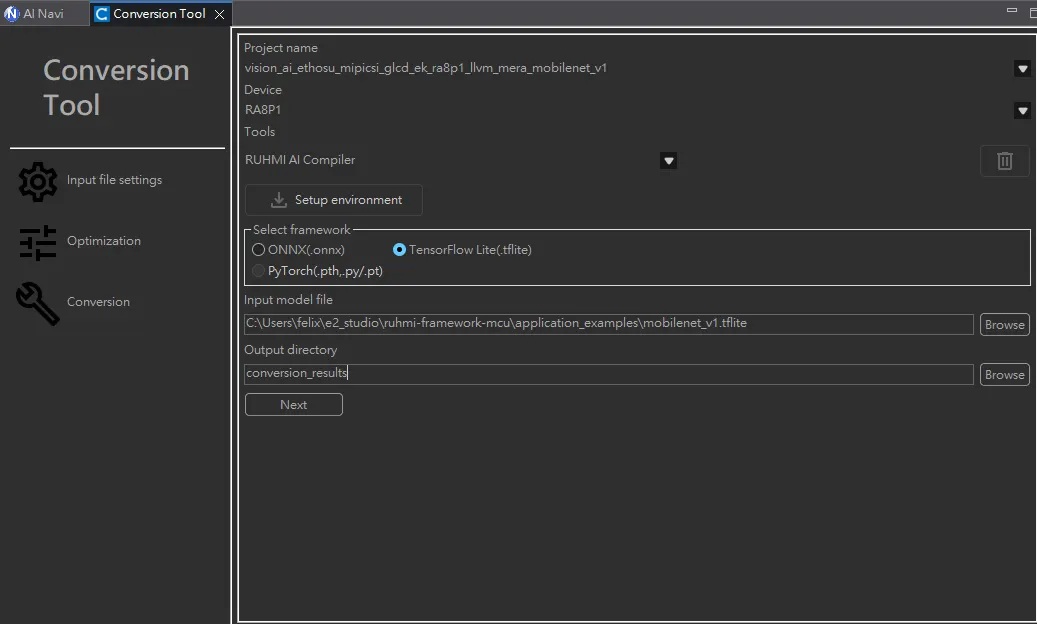

STEP 2:開啟模型轉換工具。回到e2Studio中的AI Navigator,選擇專案後點選「Edit and Build」,左側會出現「Convert AI Model」,選擇後再點選右方「Covert…」按鈕開啟轉換工具。

STEP 3:設定匯入模型。在轉換工具頁簽中,左側有三個欄位,分別為「Input file settings」選擇匯入檔案、「Optimization」模型最佳化、「Conversion」模型轉換。第一步就是選擇模型,在右側上方選擇對應的project name、Device與Tools,中間選擇Tensorflow Lite模型,下方model檔案找到剛剛所產生的mobilenet_v1.tflite模型檔,完成後點選「Next」按鈕。

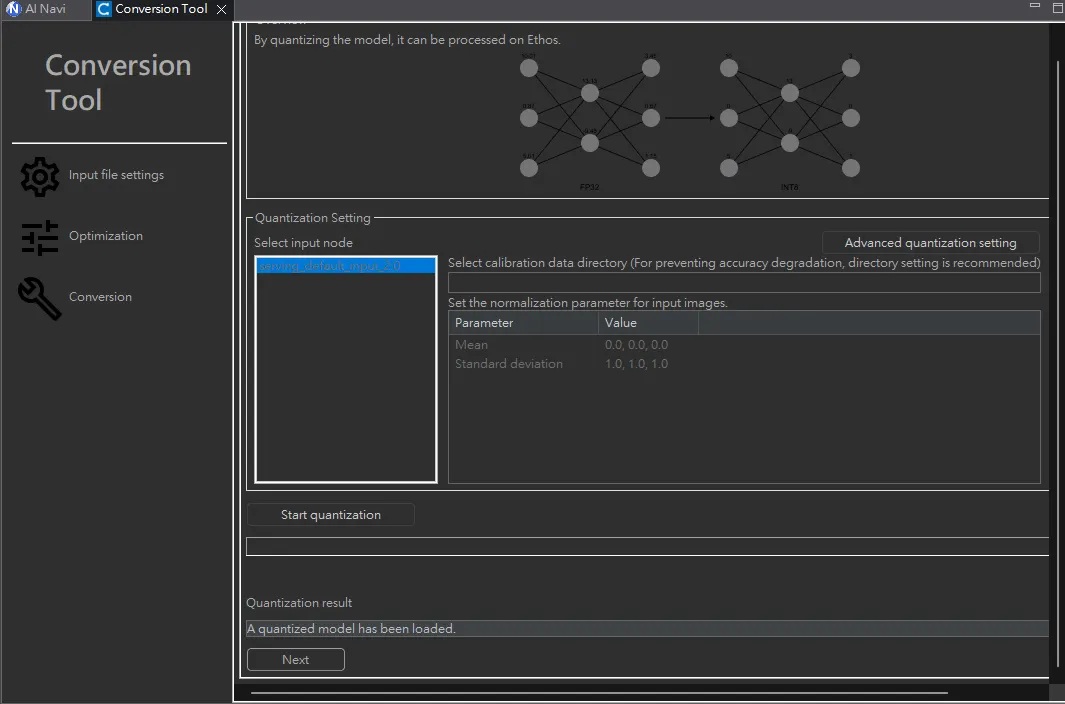

STEP 4:設定最佳化模型。此步驟主要在做模型的量化「quantization」,但由於筆者在步驟一所產出的模型是INT8格式,在此就不需要重複執行,可以點選「Next」進入下一步。

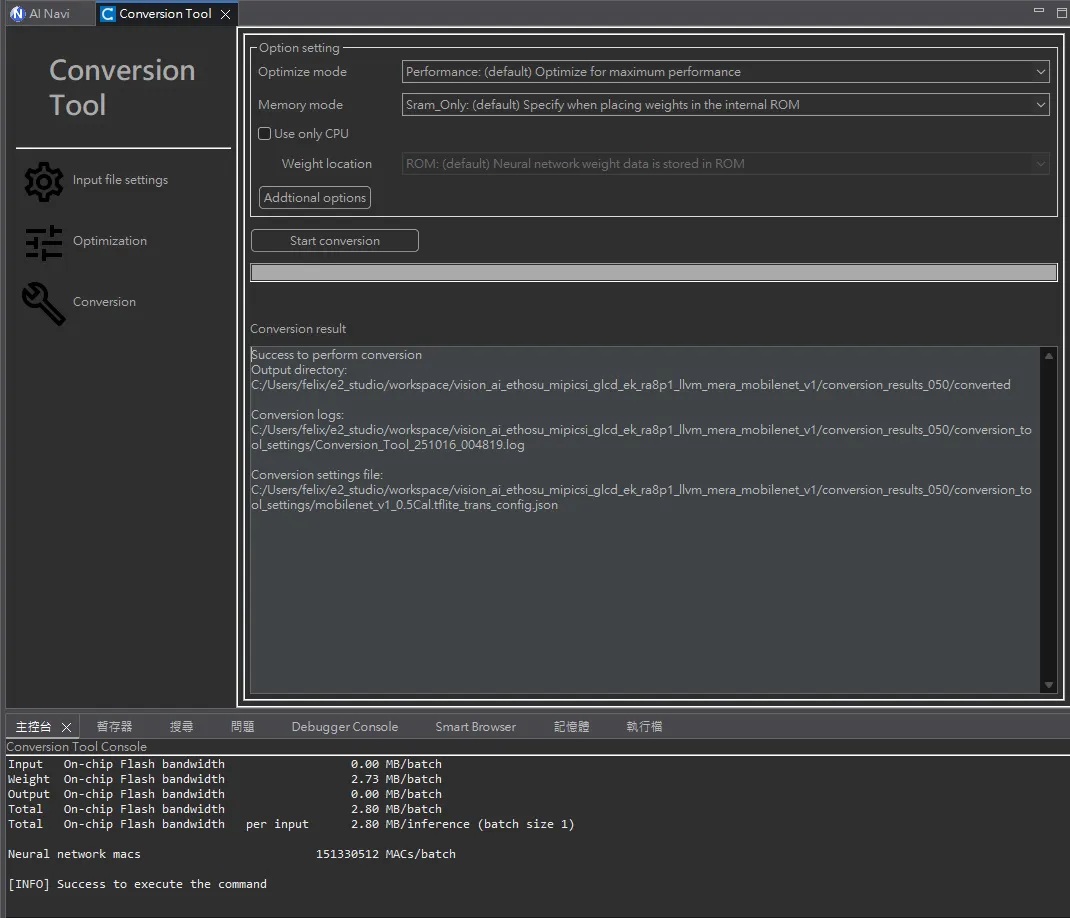

STEP 5:轉換模型生成 C code。在轉換選項中可以設定最佳化模式以及記憶體配置,筆者暫時將其保持預設狀態。點選「Start conversion」按鈕後,就會自動生成C程式碼到指定的目錄中。

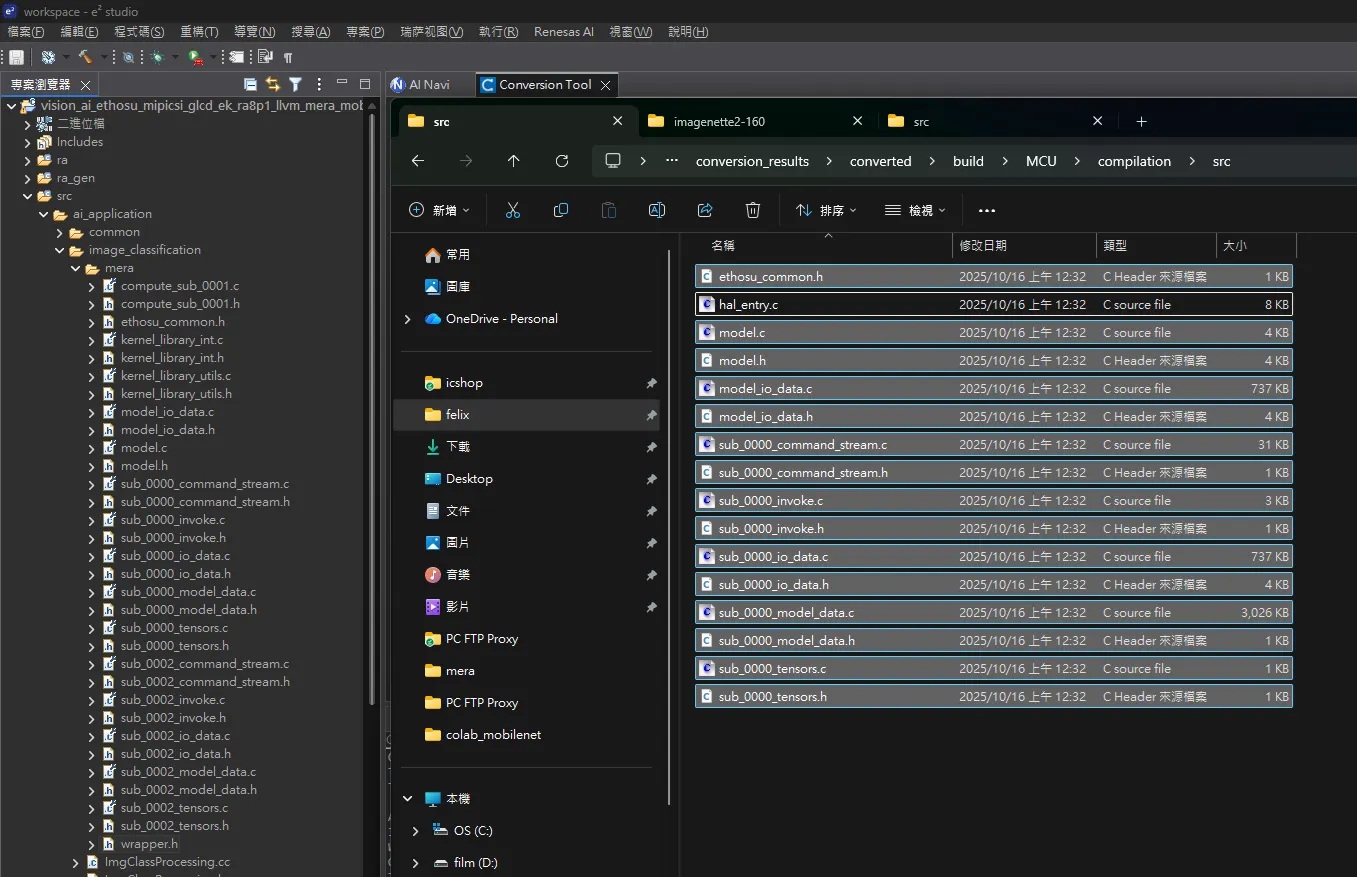

STEP 6:複製檔案到mera目錄下。找到生成程式碼的資料夾,以筆者前述設定為例,可在專案資料夾中的 conversion_results\converted\build\MCU\compilation\src 找到。選取 hal_entry.c 以外的所有檔案,複製到專案目錄下的 src\ai_application\image_classification\mera 進行覆蓋。

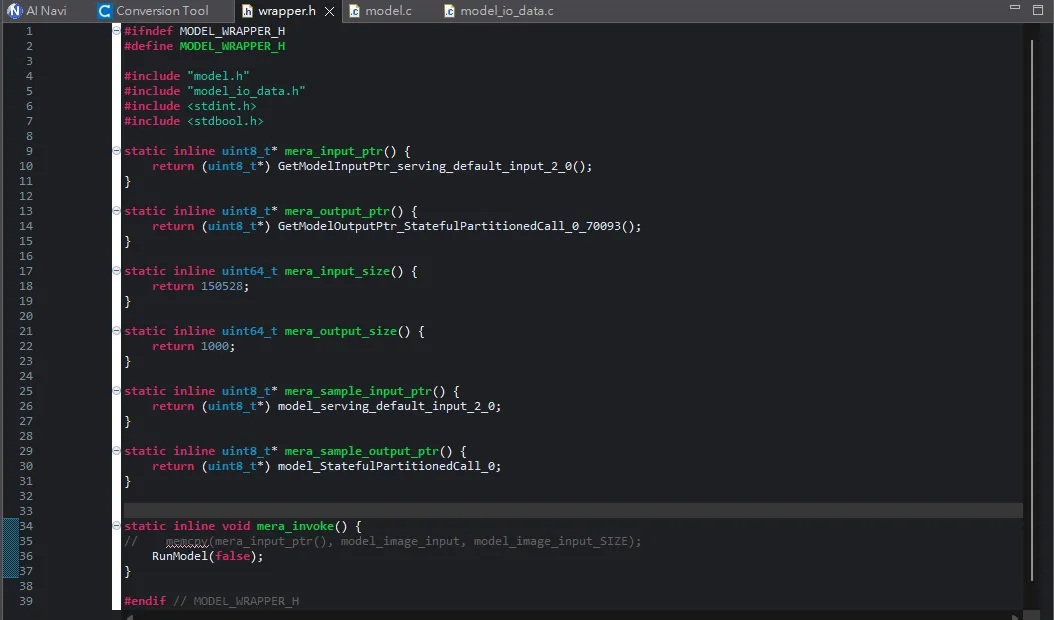

STEP 7:手動修改 wrapper.h。由於模型架構可能和範例程式不同,需要手動開啟 wrapper.h 標頭檔進行修改。需要將 mera_input_ptr 與 mera_output_ptr 的返回值改為 model.c 檔案中的 Model input pointers 與 Model output pointers。以及將 mera_sample_input_ptr 與 mera_sample_output_ptr 修改為 model_io.data.c 中的 Input tensor 與 Output tensor 這兩個長陣列的名稱。

STEP 8:編譯、燒錄。依循前述步驟執行完成後,最後在e2Studio中進行編譯與燒錄就大功告成了!

AI應用案例

除了Example Project Bundle範例程式之外,瑞薩官網上也提供了數種AI應用案例供開發者作為應用參考,以下摘錄兩項第三方的應用進行說明。

駕駛監視系統DMS

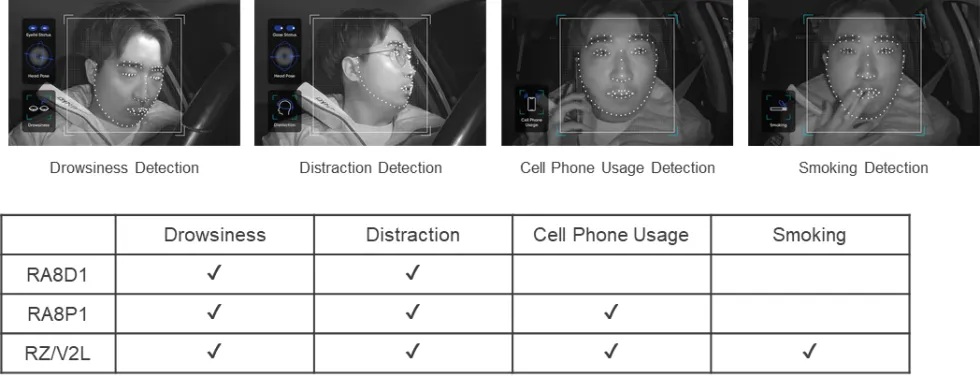

先進駕駛輔助系統(Advanced Driver Assistance Systems,ADAS)在各種車款中日益普及,對於車輛與外在環境之間的危險性可有效降低。但若是車內駕駛可能因為短暫的分心所可能造成的危害,就必須由駕駛監視系統(Driver Monitoring System,DMS)來做判斷。歐盟新車安全評鑑協會(Euro NCAP)也明確定義,配有DMS的車輛能獲得更高的安全星級;這意味著日後想要在全球市場銷售新車的車廠來說,DMS需要納入為標準配備。

Nota AI 的DMS可以偵測多種駕駛不良狀態(圖片來源:Renesas)

Nota AI提出基於Renesas RA8D1、RA8P1、RZ/V2L的DMS解決方案,可以藉由車內的紅外線攝影機判讀駕駛者是否有疲勞、注意力不集中、使用手機、抽菸等駕駛不良狀態。使用RA8P1內部Ethos-U55進行推論僅花費11.1ms時間 ,加上前後處理的時間效能約可達 43FPS (23ms),可以說是相當游刃有餘!

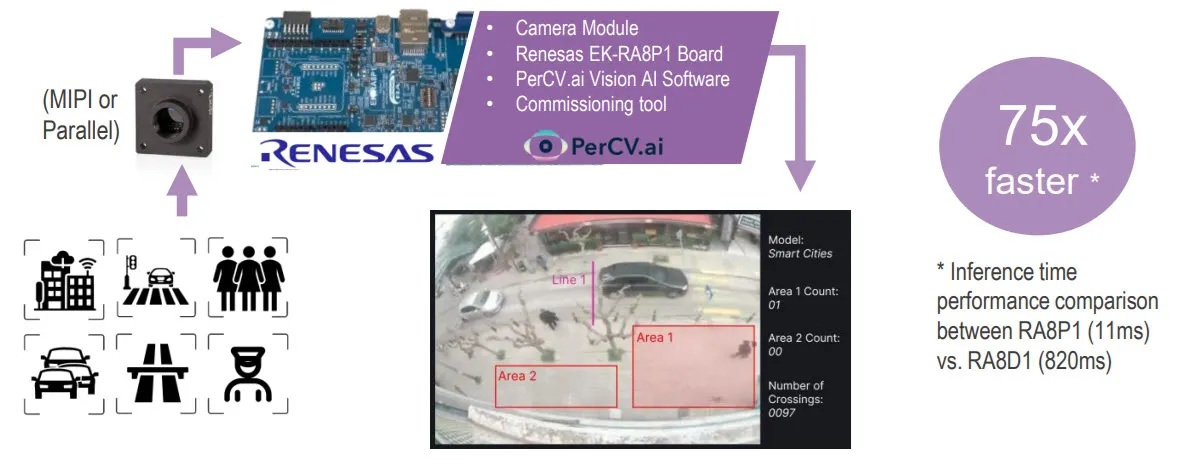

智慧城市視覺感知系統

台灣近年來有增設許多智慧交通的建設,譬如違停科技執法與智慧停車格等,但對於人本交通的改善仍有限,且系統各自為政過於破碎。Irida Labs基於RA8P1所建置的智慧城市視覺感知系統,則是一種全面性的針對一個區域或路口,偵測車流、停車位、行人多寡、甚至是人行道是否被占用等城市街區的真實感知。

Irida Labs 提出的智慧城市解決方案。(圖片來源:Renesas)

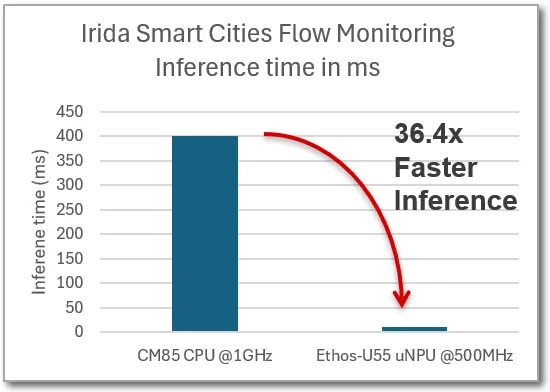

從效能上來看,在RA8P1的Cortex-M85處理器推論約需花費400ms,轉至Ethos-U55 NPU後僅需花費11ms,實現超過36倍的效能提升,若是對比舊款RA8D1 (Cortex-M85 480MHz),則是有將近75倍的效能差異。除此之外,在RA8P1這樣的MCU等級進行邊緣運算,可以有更節省能耗、更低價的成本、更隱私的資訊等多項優勢。

相同模型在U55上的效能對比CM85有36倍的提升。(圖片來源:Renesas)

小結:揭開 MCU 的新篇章

Renesas RA8P1的問世開啟了 MCU 發展史的新篇章,擁有強大的異質運算能力、高性能與低功耗兼具、泛用且便利的模型轉換工具等,使得開發者能夠在成本和功耗敏感的終端裝置上,實現以往只有在雲端或高階處理器上才能完成的複雜智慧功能!更令筆者感到驚豔的是,整合AI軟體開發工具到IDE的流暢度,是硬體業界少數做得如此完整的,即便目前釋出的範例模型較少,但若持續整合開發增加更多應用範例,再加上Tensorflow Lite與ONNX模型的廣泛支援,在MCU實現視覺 AI 推論絕對大有可為!

第二屆 MAI 開發者年會 即將盛大登場!今年主題聚焦 「打造 Edge AI 落地實戰力」,邀請全台最具影響力的 Edge AI 開發者社群齊聚一堂,從實戰技術、應用案例到開發工具,帶領你掌握下一波 AI 轉折的關鍵能量。

上午主論壇邀請到來自成大、高通、Arm、瑞薩及Intel的五位產學界重量級講者聯袂登場;下午時段將同步開放邊緣智慧實作坊、企業AI落地進修課、前瞻技術講座及實務開發講座四條主題Track,無論你是新手開發者、AI 研究者、企業應用導向團隊或硬體設計工程師,都能找到最適合你的場次,千萬別錯過了!想了解更多,請點擊此處。

- 以MCU開啟Edge AI新境界:Renesas RA8P1實測 - 2025/10/22

- Windows on Snapdragon部署GenAI策略指南 - 2025/09/23

- 運用Qualcomm AI Hub結合WoS打造低功耗高效能推論平台 - 2025/08/01

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!