作者:陳紀翰,僑光科大資工系副教授、英特爾軟體創新大使

緒論:從多模態到產業導入的轉變

什麼是VLM與MLLM?為何在2024年之後受到關注?

隨著大型語言模型(Large Language Models,LLM)在自然語言處理上取得突破性成果,將其延伸至視覺領域的需求應運而生,催生了視覺–語言模型(Vision–Language Models,VLM)的興起。VLM能夠同時處理圖像與文字兩種模態,並透過語意對齊、跨模態推論與回應生成等能力,實現更具認知層次的AI任務。

而MLLM(Multimodal Large Language Model)則是具備更完整語言能力的大型多模態模型,結合了LLM的語言生成能力與視覺理解模組,形成「讀圖 + 說理 + 回答」的一體式模型。這類模型在 2024 年後快速受到關注,主因包括:

- GPT-4V、Gemini、Claude 3 等模型的公開展示,顯示AI能從圖像推論科學與邏輯知識;

- 各大開源社群推出相對輕量版本,如LLaVA、MiniGPT、Phi-3 Vision,提供更可實作的框架;

- 在產業端興起將LLM 與IoT、邊緣裝置整合的需求,強化了多模態AI 落地的可能性。

多模態模型的演進:從CLIP到BLIP,再到Phi-3 Vision

我們將多模態模型的演進可以從核心任務的擴展來理解,將其發展歷程大致可分為三個技術轉捩點:

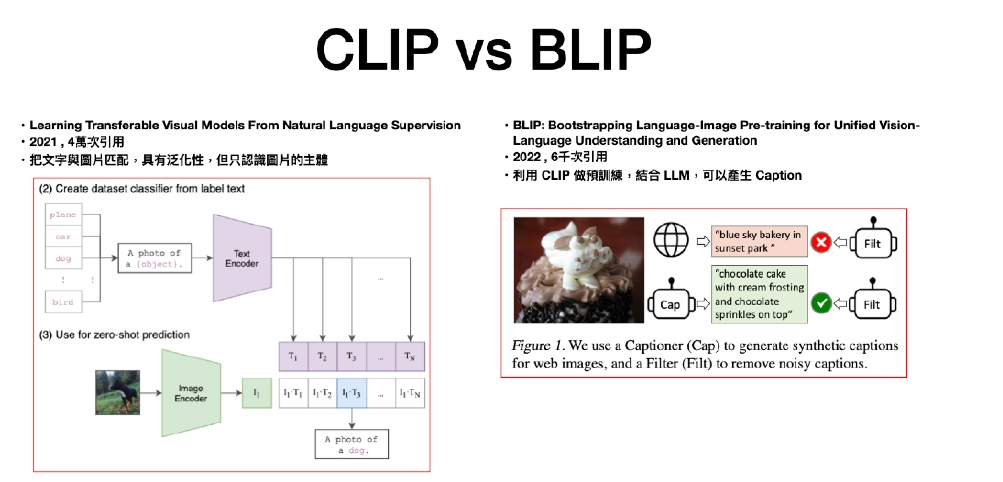

- 第一階段:圖文對齊(CLIP, 2021) — —OpenAI 提出的 CLIP 模型將圖像與文字映射至共同語意空間,具備零樣本圖像分類能力,為多模態語意對齊奠定基礎。

- 第二階段:圖像描述與問答(BLIP, 2022) — —結合預訓練視覺模型(如 CLIP)的encoder與具生成能力的LLM decoder,並導入可學習查詢(如 Q-Former),能進行圖像問答與caption生成任務。

- 第三階段:輕量化與可部署推論。

這三個發展階段分別反映出從「語意對齊」到「語言生成」再到「高效落地」的技術路徑,也預示未來多模態模型將更加注重結構彈性與應用場景的匹配能力,本文將以微軟(Microsoft)發表之輕量 MLLM,配合OpenVINO的框架與官方資源展示blocksparse attention、長上下文記憶(LongRope)與ViT encoder結合後的推論潛力,並支援多圖、OCR與區域推論。

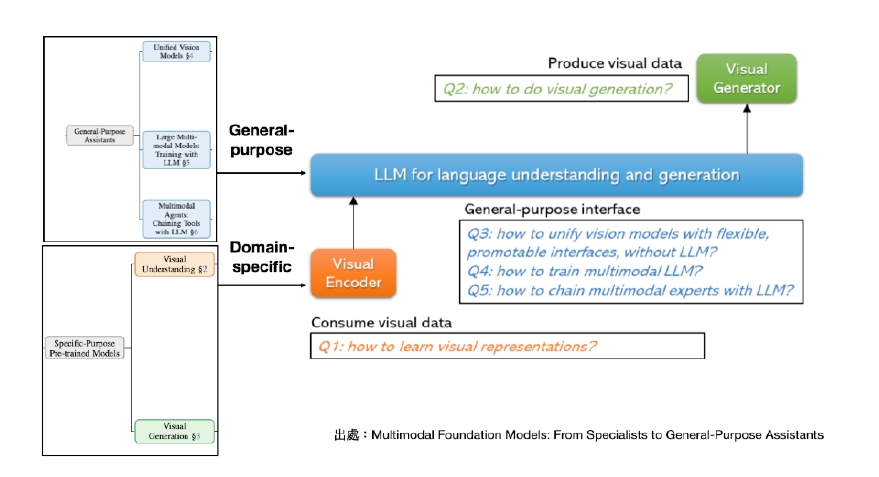

圖1:展示了多模態大型語言模型(MLLM)的基礎架構,其核心為將視覺編碼器(Visual Encoder)與大型語言模型(LLM)進行結合。模型能夠理解與生成視覺資料,支援視覺理解與生成任務,並透過統一介面整合通用與特化模組,實現跨任務的多模態推理與應用。圖中強調目前MLLM的核心挑戰包括:如何學習視覺表徵、如何進行視覺生成,以及如何無縫整合多模態專家模型與LLM。

導入產業的挑戰與機會:模型大小、速度、資料保護、可解釋性

圖2:展示Intel OpenVINO 2025.1在大型語言模型(LLM)推論效能上的顯著提升,於Intel Core Ultra 200H系列處理器上,第二token吞吐量提升最高達1.4倍。同時,OpenVINO Model Hub支援的模型數量亦大幅擴增,涵蓋多種主流LLM 與多模態語言模型(MLLM),強化生成式 AI 在終端裝置上的應用部署能力。

儘管多模態模型展現出強大的語意理解與推論能力,但其實際導入產業應用仍面臨多重挑戰。例如,模型大小往往需數十GB記憶體,使其難以部署於資源有限的邊緣裝置;推論過程可能產生延遲,無法滿足即時工業應用對低延遲反應的需求;同時,企業所涉及的圖像與資料需受到資料治理與保護規範的約束,無法隨意外送模型推論;此外,產業場域對可解釋性的要求極高,黑箱式AI難以取得現場人員與管理決策者的信任。

然而,機會也不容忽視。MLLM帶來對非結構化資料的語意分析能力提升,使企業能更深入理解圖像與文字背後的意涵;模型架構具備彈性與可模組化設計,可依任務需求進行裁剪或搭配使用,而不需全端執行;並且在如魚屍辨識、煙霧偵測等特化任務中,MLLM可結合語言與視覺訊息,彌補純影像模型在語意推論上的限制,展現產業落地的真實潛力。

OpenVINO的定位與優勢:可部署性、邊緣運算、與現有架構整合

OpenVINO(Open Visual Inference and Neural Network Optimization)為Intel所開發之 AI 模型最佳化與推論工具套件,針對邊緣運算與跨平台推論場景提供高度效能支援。

其主要優勢包括:

- 可部署性:支援從 ONNX、PyTorch、TensorFlow 等多種框架轉換為 IR 格式,可在 CPU、iGPU、NPU 等平台運作

- 最佳化推論效能:內建量化(INT8/FP16)、層融合、batch 管理等機制,實測在低規硬體可運行 LLM/MLLM

- 與產業現有工具鏈整合性高:可搭配 YOLOv8、HuggingFace 模型、OpenCV pipeline 等整合使用

在這樣的設計下,OpenVINO 為多模態模型導入產業應用提供了一條穩定可行的落地路徑,尤其是在影像分析、異常監測、圖文報告生成等任務中展現潛力。

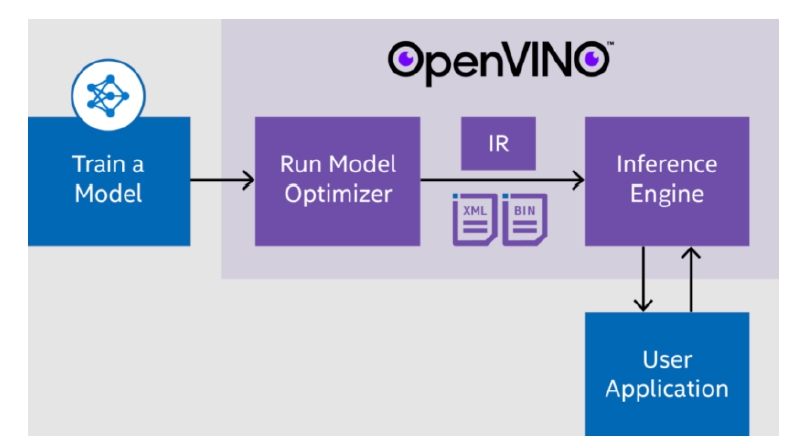

圖3 : 說明Intel OpenVINO提供一條標準化的模型部署流程:從模型訓練開始,經由Model Optimizer將模型轉換為中介表示格式(IR,含 .xml 與 .bin 檔),再透過Inference Engine進行高效推論,最終整合至使用者應用中,實現端到端的 AI 加速部署。

Phi-3 Vision模型簡介與技術亮點

微軟於2024年推出的Phi-3模型家族,主打高效率、高擴展性與高相容性,涵蓋mini、medium到MoE架構版本。其中,Phi-3 Vision是具備視覺理解能力的多模態架構,整合圖像輸入與語言生成能力,支援端側運作,並附有完整技術報告,具備高度工程再現性。

Phi-3 Vision採用blocksparse attention,突破dense attention限制,僅針對必要token區域進行注意力運算,顯著減少記憶體使用與延遲。其KV-cache亦最佳化為支援paged attention,降低暫存空間並提升吞吐效率。

在處理長文本上,Phi-3採用LongRope技術,將Rotary Positional Embedding延伸至128K tokens,並透過混合視窗訓練法,讓模型能應對各種上下文長度,如文件分析與圖文對話。

部分版本採用MoE架構,每次僅激活2/16專家以降低運算成本,並結合SparseMixer分散式稀疏訓練策略,兼顧模型容量與推論效能。

相容性方面,Phi-3與Llama2工具鏈高度兼容,支援Hugging Face、vLLM、llama.cpp等主流框架,視覺編碼器亦支援ViT-L/14、EVA-CLIP等,實現模組靈活替換。

量化後的Phi-3 Vision僅約1.8GB,能在iPhone 14上達到超過12 tokens/s的推論速度,具備真實「可隨身部署」的潛力,可望推動多模態語言模型落地至邊緣設備與行動場景。

更多詳細內容可參考:Phi-3 Technical Report: A Highly Capable Language Model Locally on Your Phone

落地MLLM的三大策略與架構選擇

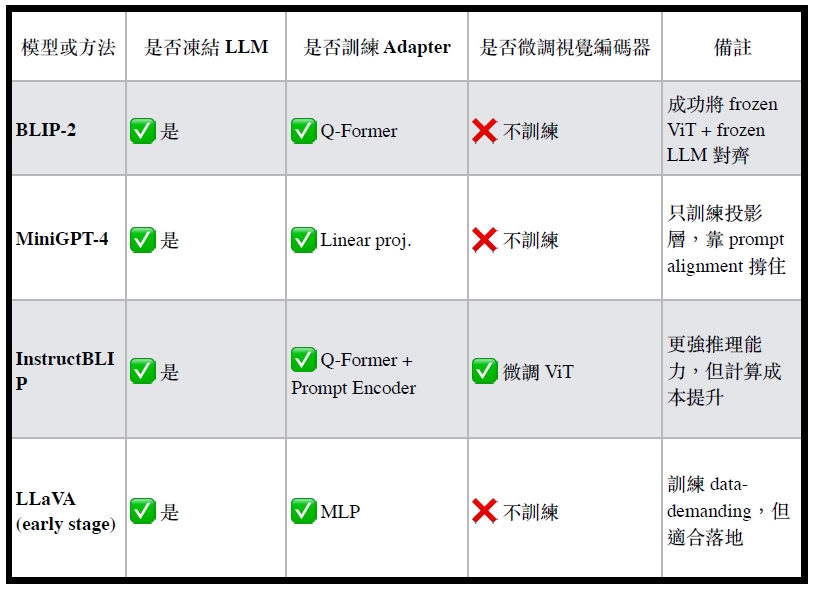

在實際導入多模態語言模型(MLLM)時,研究界與產業界普遍採用三大主流策略,依據視覺模組的整合方式、是否凍結預訓練模型、以及語言模組與影像特徵的連結方式進行不同設計選擇。這些策略各具優劣,選擇何種架構組合,往往決定了整體系統的落地成本與應用可擴展性。

(一)策略一:CLIP 類 encoder + 投影轉接器 + 凍結 LLM

此策略可視為最普遍、實作成本最低的落地架構。其主要作法是:將已預訓練好的CLIP/EVA-CLIP/SigLIP 等視覺編碼器凍結,搭配一層輕量的MLP或Linear Projection模組,將圖像特徵轉換為類似語言token的embedding,輸入至凍結的LLM模型進行指令生成。

優點為架構簡潔、訓練資料需求低、對於零樣本任務仍有不錯表現,且可沿用原有的LLM工具鏈;缺點則是視覺與語言模態的融合較為鬆散,對多圖、多尺度、高解析度任務支持不佳。

代表模型包括:LLaVA系列、MiniCPM-V、MiniGPT 系列等。

(二)策略二:壓縮查詢模組串接法(如Q-Former/Cross-Attn)

本策略透過插入學習型查詢模組來增強視覺資訊的選擇性提取與語言模組對齊能力。典型設計包括使用Q-Former、Perceiver Resampler或cross-attention機制,將ViT的patch特徵壓縮成少量語意token,再交由LLM處理。

此法優點為支援高解析度圖像、能處理多張圖、且特徵重構能力較佳;缺點則是模型結構稍微複雜、需要額外訓練查詢層或cross-attn block。

代表模型包括:BLIP-2、Flamingo、Phi-3.5 Vision 等。

(三)策略三:端對端的多模態Transformer或Encoder–Decoder架構

此策略是目前最具整合性但也最昂貴的路線,將影像與文字同時輸入至共同架構中進行訓練,如單一多模態Transformer架構,或採ViT encoder + LLM decoder 的 encoder–decoder 設計。

其優勢為視覺與語言模態高度融合,能進行高階推論與多步邏輯回答,且長期可塑性高;但同時也對資料量與算力有極高要求,不利於落地快速複製與維運。

代表模型包括:PaLI系列、GPT-4V、GIT 等。

(表 1:MLLM 三種策略示意圖,右圖為本策略架構)

表1:主流落地方法比較表

綜上所述,MLLM的設計與落地策略並無單一最佳解,而需根據實際應用場景、推論平台限制與成本預算進行調整。對於目標清晰、資料量有限的任務而言,策略一與策略二能快速建立原型;而對於需求複雜、需深層理解的任務,策略三則展現長期潛力。

特化領域CLIP模型的發展與應用

雖然CLIP於2021年由OpenAI所提出的原始版本在自然影像上展現出極強的零樣本能力,但其訓練資料主要來自大規模網路圖文對(如LAION-400M),在專業領域的泛化表現明顯受限。因此,近年來各領域逐漸出現將CLIP方法論「特化」至領域內的延伸模型,透過語意補足與資料重訓,提升CLIP在農業、醫療、遙測、工業等場景的適應性。

進一步地,若將CLIP架構與BLIP所提出的Captioner與語言生成流程結合,便可構建出具備視覺理解與語言生成能力的MLLM,實現從圖像理解到語意敘述的跨模態推論。這樣的架構特別適合特化領域應用,透過導入領域專屬的CLIP模型(如MedCLIP、RemoteCLIP、AnomalyCLIP 等)與高品質圖文資料,即可發展出具備專業敘述能力的MLLM系統。因此,我們可以依據應用場景,尋找合適的特化CLIP模型作為基礎,進行MLLM模型的設計與落地部署。

圖4:這張圖對比了CLIP與BLIP的模型設計差異,說明視覺–語言模型從CLIP的「影像主體辨識」逐步演進至BLIP的「影像語意描述」能力。CLIP透過對齊圖像與文字嵌入向量,具備零樣本分類能力,但僅能辨識主體物件;BLIP則進一步結合Captioner與LLM,生成完整圖像描述,實現更細緻的內容理解與語言生成,是從辨識走向敘述的關鍵轉變。

以下提供幾種知名的特化型CLIP :

1. AgriCLIP:農業與畜牧場景的CLIP適應

AgriCLIP專為農業與畜牧領域設計,其核心想法為將 CLIP 預訓練架構套用於作物分類、植物病害識別、動物監測等任務。該模型多半使用衛星影像或高解析度田野影像作為訓練基礎,並藉由精選的文字標籤描述(如植物種類、生長狀態等)進行語意對齊。

相較於通用CLIP,AgriCLIP更能處理植被疊層、背景雜訊、季節變化等特殊問題,在智慧農業的數據平台中具落地潛力。

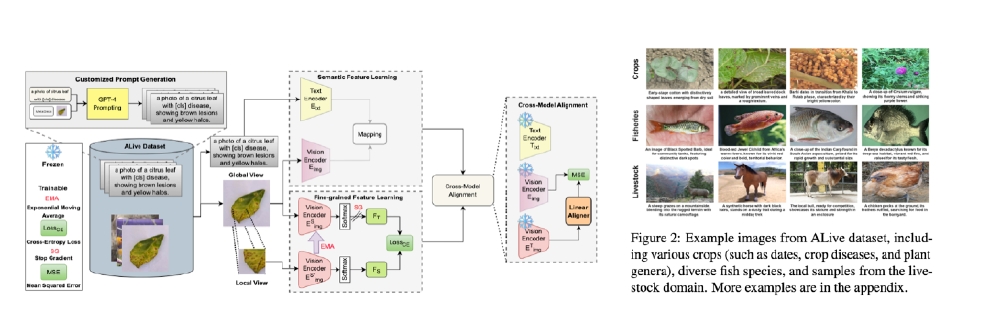

圖4-1 : AgriCLIP展示了一個針對農業、漁業與畜牧領域設計的多模態語言模型訓練架構,使用ALiVE資料集與GPT-4所生成的客製化圖文描述進行跨模態對齊學習。整體模型包含語意特徵學習、細粒度特徵提取與跨模型對齊三大模組,並透過MSE、Cross-Entropy、Stop Gradient等技術提升圖文一致性與視覺辨識能力。右側則展示了ALiVE資料集中涵蓋的作物、魚類與牲畜等多樣化影像範例。

2. RemoteCLIP:針對遙測地物語意對齊的特化模型

RemoteCLIP是一款針對衛星影像與航空影像進行語意對齊訓練的多模態模型,常應用於地表覆蓋分類、土地利用分析與災害監測等任務。該模型面對的挑戰包括尺度變化劇烈、類別重疊性高、無主體中心等情形,因此在prompt設計與標註對齊上進行特化與最佳化。

RemoteCLIP在語意結構與prompt組合上相對精緻,支援單圖多地物、多語言prompt,提升了多標籤預測任務的準確性。

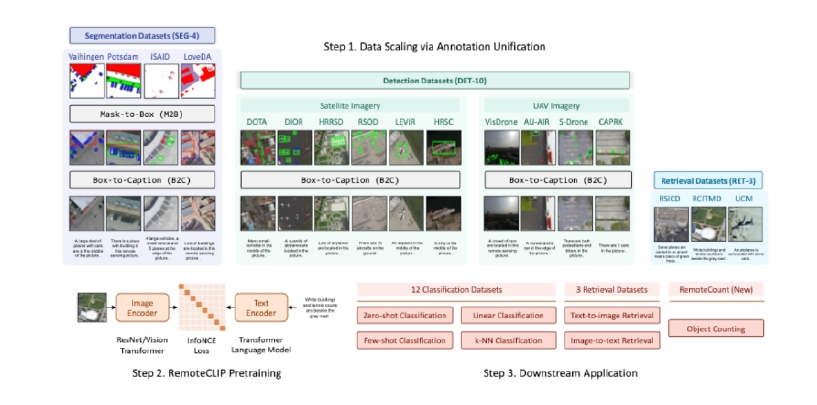

圖4-2 : 說明RemoteCLIP 的訓練與應用流程,共分為三個步驟: Step 1透過註解統一將各類遙測任務資料(如語意分割、物件偵測、檢索)轉換為圖文對,包含Mask-to-Box與Box-to-Caption的處理流程; Step 2使用統一資料進行 RemoteCLIP 的跨模態預訓練,透過圖像與文字編碼器對齊學習語意表示; Step 3支援多樣化下游任務,包括分類(如零樣本與少樣本分類)、圖文檢索、以及物件計數等遙測應用。整體流程展現RemoteCLIP在遙測領域的資料擴展能力與多任務適應性。

3. MedCLIP:醫學影像與診斷文本之跨模態對齊

MedCLIP所面對的資料多為X-ray、CT、MRI等醫療影像,以及來自醫師報告或電子病歷的文字資訊。其目標是建立「異質、非配對」資料間的語意橋接,強化模型對病灶結構、診斷術語的理解與推論。

該模型在設計上強化了圖文相似度計算與病理特徵抽取能力,適合用於自動標註、報告生成與診斷輔助系統中,並已出現具臨床潛力的應用案例。

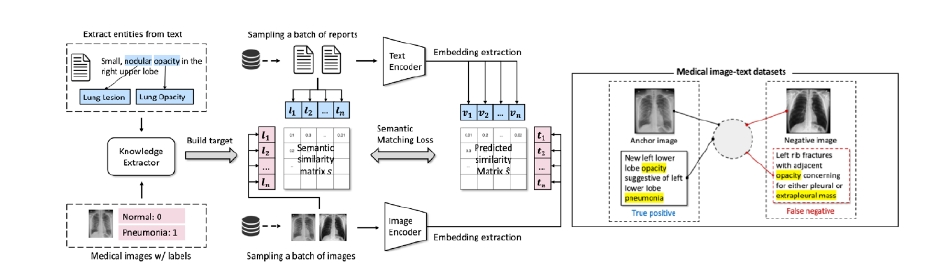

圖4-3 : MedCLIP展示了一種用於醫療影像–文本對齊的語意匹配訓練流程。左側透過知識擷取器從醫療報告中抽取疾病實體,並搭配有標記的影像建立訓練目標。中央將報告與影像分別透過編碼器轉換為語意向量,再計算語意相似度矩陣,透過語意匹配損失進行優化。右側舉例說明語意匹配的關鍵性:即便出現相同詞彙(如 opacity),僅有與影像疾病對應的文本才應視為正樣本,有助於提升模型對醫療語意的理解與對齊能力。

4. AnomalyCLIP:跨領域瑕疵與異常偵測應用

AnomalyCLIP主要針對工業製程中缺陷檢測、產品瑕疵分類與異常行為辨識等任務進行設計。該模型的特點為可「零樣本」地對瑕疵進行分類或定位,並利用prompt工程控制出現條件與目標類別。

其設計中導入Object-agnostic Prompt Learning,使模型不需依賴精確框選物件,即可進行語意層級的異常預測,特別適用於缺乏標準樣本的早期異常警示系統。

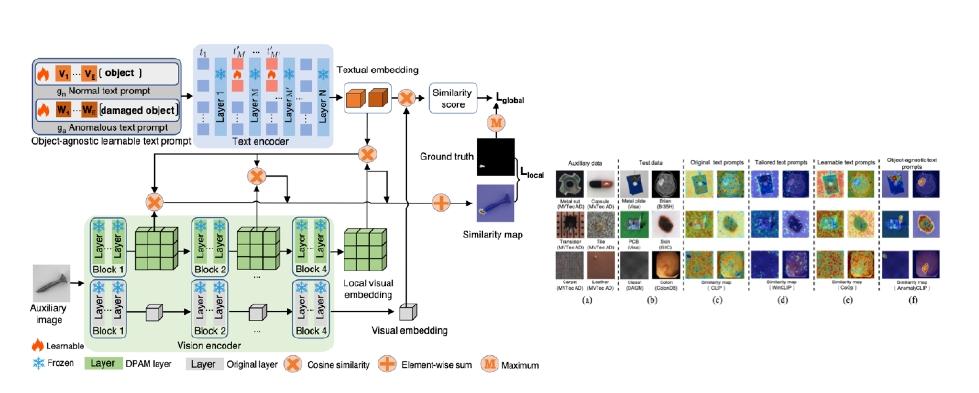

圖4-4 : Anomaly展示一個以多層次語意對齊為核心的異常偵測架構,融合可學習文字提示(text prompt)與區域相似度比對機制。左側模型設計中,輸入影像與對應的文字提示(正常/異常)分別通過視覺與文字編碼器,進行全域與區域語意對齊。系統透過相似度圖(similarity map)進行異常定位,並以 ground truth mask 計算損失。右側展示不同提示策略下的異常熱圖輸出,顯示所提出的object-agnostic learnable prompt能產生更準確的異常區域標示,提升跨資料集泛化能力。

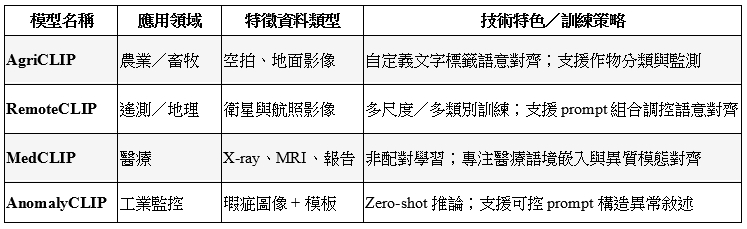

表4-1:特化領域CLIP模型比較表

透過這些專業化設計的CLIP模型,不僅拓展了CLIP在實務領域的應用邊界,也為MLLM模型的特化訓練提供良好視覺編碼基底,使之在多模態推論任務中具備更高的準確性與語意對接能力。

Phi-3 Vision 的能力展示與推論分析

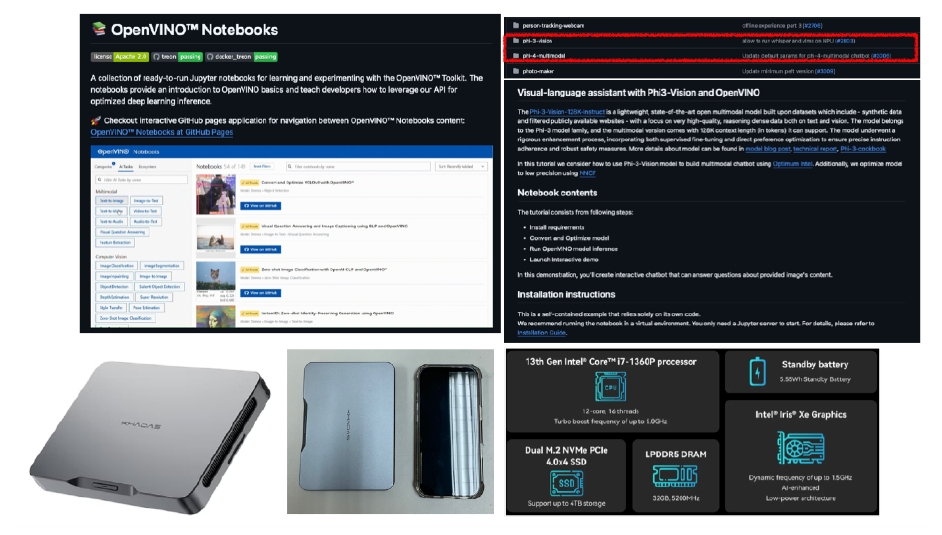

圖5展示了如何透過OpenVINO Notebooks執行Phi-3 Vision模型進行多模態推論。左上為OpenVINO官方提供的Jupyter Notebook範例,可快速測試CLIP、BLIP與Phi-3 Vision等模型應用;右上則顯示Phi-3 Vision在OpenVINO平台中的應用教學,包括模型轉換、推論與互動 chatbot 實作流程。下方則是搭配運作平台Khadas Mind,搭載第13代Intel i7處理器與Iris Xe GPU,支援OpenVINO在輕量裝置上執行高效能多模態模型,適合開發與部署邊緣AI應用。

此外,Phi-3 Vision不僅在架構與部署層面展現高效率與可擴展性,在實際推論任務中也展現出多樣化的視覺理解與推論能力,涵蓋視覺知識鑑別、語言生成、以及語意驗證等關鍵應用。本章將從三個面向說明Phi-3 Vision的實測能力與推論行為。

圖5 :展示了如何透過Intel OpenVINO Notebooks執行Phi-3 Vision模型進行多模態推論。左上為OpenVINO官方提供的Jupyter Notebook範例,可快速測試CLIP、BLIP與Phi-3 Vision等模型應用;右上則顯示Phi-3-Vision在OpenVINO平台中的應用教學,包括模型轉換、推論與互動chatbot實作流程。下方則是搭配運作平台Khadas Mind,搭載第13代Intel i7處理器與Iris Xe GPU,支援OpenVINO在輕量裝置上執行高效能多模態模型,適合開發與部署邊緣 AI 應用。

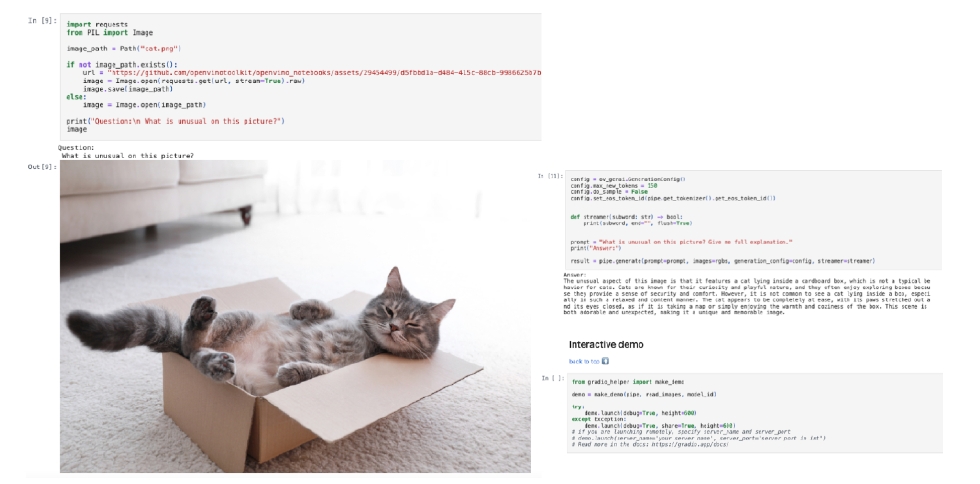

圖6 : 展示使用OpenVINO和Phi-3 Vision模型進行多模態推論的範例。透過Python程式碼將圖像(貓咪躺在紙箱中)作為輸入,並輸入自然語言問題 “What is unusual on this picture?”,模型成功生成合理語意的回應。右側的輸出解釋指出這是一個不尋常卻可愛的畫面,因為貓以放鬆姿態仰躺在箱中,這種輸出展示了圖文結合模型的敘述能力與場景理解效果,並支援Gradio互動式部署。

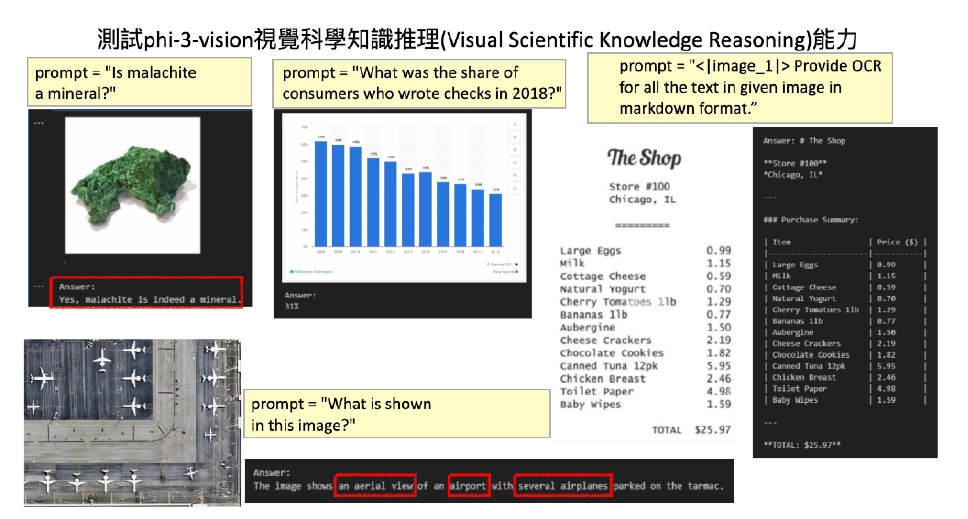

1. 視覺知識推論能力(Visual Scientific Knowledge Reasoning)

Phi-3 Vision在圖像知識判讀方面展現出基本的分類推論能力。舉例來說,在礦物圖像鑑定中,給定prompt為 “Is malachite a mineral?” 並搭配圖片,Phi-3能結合視覺線索與內部語言知識正確回答 Yes,並指出其特徵屬性。

同樣地,在統計推論任務中,例如展示一張顯示支票付款比例的圖表,Phi-3可成功解析圖像中的文字與比例,並推論出 “In 2018, around 10% of consumers used checks.” 類似描述,展現出跨圖像與語言的整合能力。

OCR 任務中,Phi-3 亦可執行類似 “<|image_1|> Provide OCR for all the text in given image in markdown format.” 的指令,並能以段落或標題方式結構化文字資訊。此能力對於工業票據分析、圖像表單理解等應用具備直接效益。

圖7 : 展示Phi-3 Vision在視覺科學知識推理(Visual Scientific Knowledge Reasoning)方面的能力,透過不同prompt進行多樣化任務測試。範例包括:礦物辨識(確認孔雀石為礦物)、圖表資料理解(正確讀取2018年支票使用率)、文字OCR並轉為Markdown格式,以及從航拍圖中推論出「機場與多架飛機」等語意資訊,顯示其在圖像識別、結構理解、知識檢索與語言生成任務中的綜合推理能力。

2. 敘述生成能力(Captioning & Logical Inference)

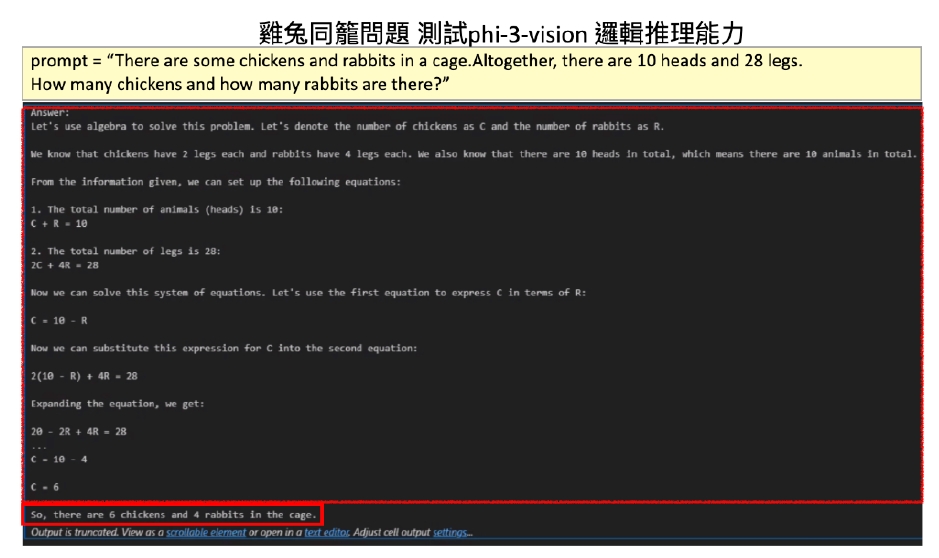

Phi-3在生成任務上具有基本的邏輯推論與語意理解能力。在「雞兔同籠」問題中,給予圖像與文字敘述:“There are some chickens and rabbits in a cage. Altogether, there are 10 heads and 28 legs. How many chickens and how many rabbits are there?”

Phi-3成功產生回答: “There are 6 rabbits and 4 chickens.” 並附上基本解題邏輯推導。

此結果顯示Phi-3可根據圖像語境輔以數理推論能力,應用於教育教具、自動解題教學與互動學習平台。

在一般圖像生成描述任務中,Phi-3可根據輸入圖片產出合理語句,如 “A group of children playing soccer in a grassy field on a sunny afternoon.” 並可隨 prompt 設計加入情境或語氣控制。

圖 8 : 展示Phi-3 Vision在處理數學語意問題上的邏輯推論能力。面對經典的「雞兔同籠」問題,模型能夠理解語意敘述、建立代數方程,並逐步推導解答過程,最終正確計算出雞與兔的數量。此範例說明Phi-3 Vision不僅具備語言理解能力,也能執行具邏輯性的數學推理任務,展現其在結構化問題解題上的潛力。

3. 物件存在性檢測(Visual Presence Verification)

在圖像語意驗證任務中,Phi-3展現出中等程度的辨識與信心控制能力。以「魚屍偵測」任務為例,Prompt 為 “Is there dead fish in this image?”

在一些清楚顯示魚屍體的圖像中,Phi-3 正確回答 “Yes, there are dead fish visible in the image.” 並可指出主要區域與特徵。

然而,當圖像中魚體模糊、半遮蔽或未呈現典型特徵時,Phi-3易作出 “No dead fish are visible” 的回答,導致錯失判斷。

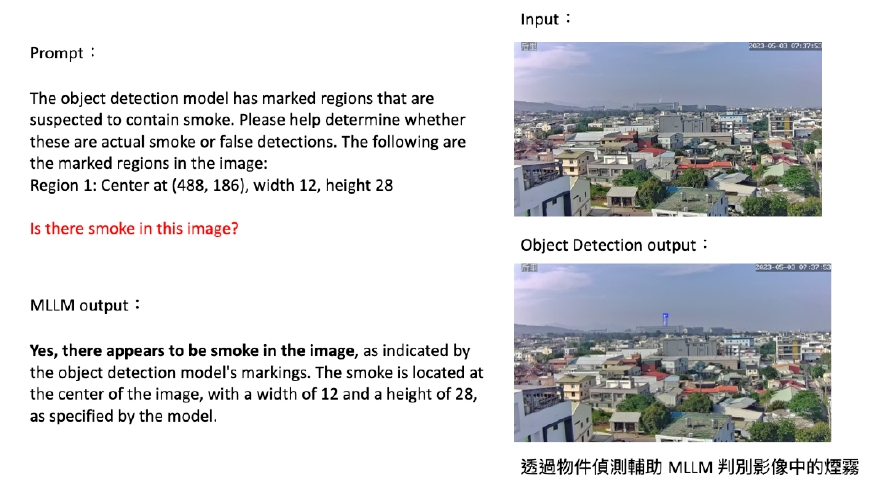

同樣的情況也出現在煙霧判斷任務中,若僅給定模糊圖片,Phi-3難以斷定是否有 smoke 存在;但若結合object detection的標註提示(例如以 bounding box 指出疑似區域),Phi-3 的正確率明顯提升。

這顯示出Phi-3在absence認知上傾向保守,視覺表徵對邊界與遮蔽資訊仍有盲點,其信心機制與prompt引導方式在應用中仍需設計補強。

圖9 :展示Phi-3 Vision模型在魚屍與煙霧辨識任務中的表現。對於明顯可見的魚屍圖像,模型能準確判斷;但在魚體不清或畫面反光的情況下,容易出現誤判,例如將已死亡的魚誤認為活魚,或完全未偵測到模糊的魚體。同樣地,在煙霧場景中,即便畫面實際存在煙霧,模型也可能因對比不足而誤判為「無煙霧」。此實驗凸顯多模態模型在模糊、不確定視覺條件下的推論侷限性,強調物件明顯度對推論結果的關鍵影響。

總結來說,Phi-3 Vision在不同層次任務上具備良好推論起點,尤其在與指令搭配、結構化回答與知識輔助場景中表現優異。然而,其在模糊視覺辨識、負樣本判定(negative verification)與置信調整等方面仍具進步空間,這也為 MLLM 的應用場景設計與系統整合提供了實務依據。

物件偵測與 VLM 整合實作

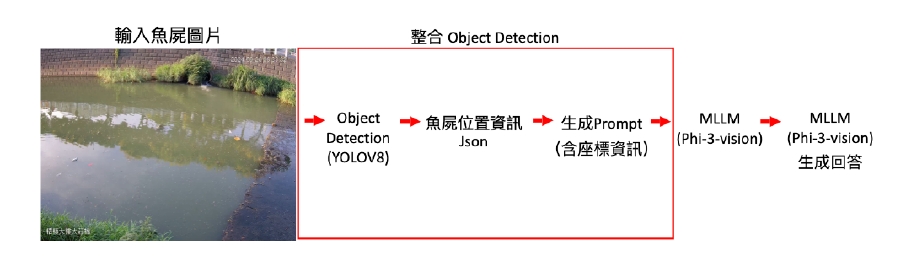

為了補足單一 MLLM模型在目標模糊或細節隱藏情境下的辨識盲點,本章說明如何將物件偵測(Object Detection,OD)與VLM(以Phi-3 Vision為例)進行整合,形成具備區域引導推論的應用流程。

1. 架構設計與資料流程說明

整合架構主要由三個模組組成:

a. YOLOv8:進行圖像中的初步物件偵測(例如:魚屍或煙霧位置標註)。

b. Prompt 生成器:將 YOLO 輸出的位置資訊(中心點、寬高)轉換為語言格式的prompt。

c. Phi-3 Vision:接收原始圖像 + prompt 結構,進行視覺–語言推論與區域驗證。

這樣的設計讓LLM不需從整張圖像中自行推斷所有可能性,而是依據OD標註進行「區域引導式語意驗證」,特別適用於需進行二階段確認或具高錯誤代價的任務。

圖10 : 展示一個結合YOLOv8物件偵測與 Phi-3 Vision MLLM的應用流程。系統首先輸入一張魚屍影像,透過YOLOv8擷取魚屍的定位資訊並轉為 JSON,再自動生成包含座標的prompt,交由Phi-3 Vision處理圖文輸入,最終產生具解釋性的回答。此流程實現從低階偵測到高階語意理解的完整自動化分析架構,適用於環境監測等落地應用。

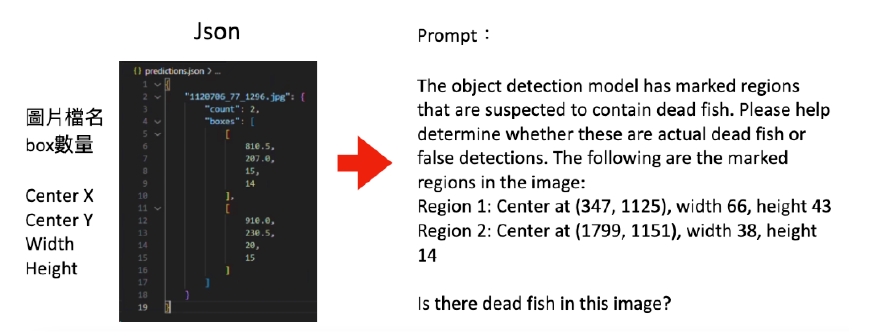

2. 實作範例:魚屍辨識工作流程

此任務目標為偵測河川浮屍(魚屍)影像中是否存在異常物體,流程如下:

使用 YOLOv8 偵測魚屍位置,輸出為 JSON 格式:

[

{“center_x”: 347, “center_y”: 1125, “width”: 66, “height”: 43},

{“center_x”: 1799, “center_y”: 1151, “width”: 38, “height”: 14}

]

將上述資訊轉為自然語言prompt,範例如下:

The object detection model has marked regions that are suspected to contain dead fish. Please help determine whether these are actual dead fish or false detections. The following are the marked regions in the image:

Region 1: Center at (347, 1125), width 66, height 43

Region 2: Center at (1799, 1151), width 38, height 14

將圖像與prompt輸入至Phi-3 Vision,等待其輸出結果。

圖11 : 說明如何將YOLOv8偵測出的魚屍框位資訊(以 JSON 格式表示)轉換為適用於多模態模型(如 Phi-3 Vision)的prompt。左側為標註框資訊,包括中心座標與寬高;右側則是將這些資訊轉換為自然語言格式,要求模型判斷各區域是否真為魚屍。此流程可結合物件偵測與視覺語意推論,提高MLLM對關鍵目標的辨識精度與解釋力。

3. 解釋力與多回合推論設計

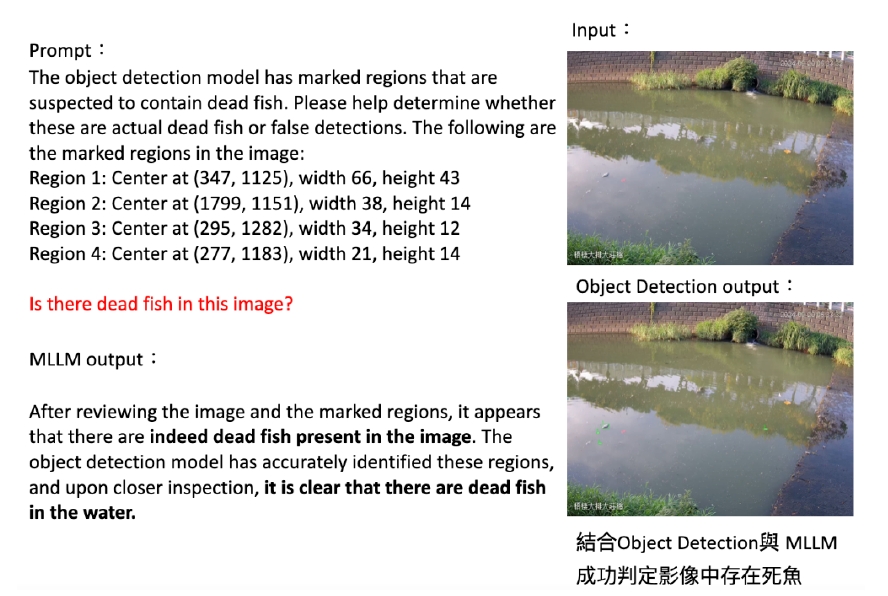

透過OD引導,Phi-3的回答將更具針對性。例如:

MLLM output:

After reviewing the image and the marked regions, it appears that there are indeed dead fish present in the image. The object detection model has accurately identified these regions, and upon closer inspection, it is clear that there are dead fish in the water.

若需進一步提升可信度,可搭配逐區域追問,如:

What do you see in Region 1? Please describe it.

如此設計具備高解釋性與交互彈性,特別適合應用於警示性系統、人機輔助審查、與專業註解任務。

4. 單純MLLM vs 結合OD的比較分析

實驗顯示,在無OD協助下,Phi-3對於視覺不明顯或低對比度目標(如半沉魚屍、邊界模糊煙霧)常出現「No object visible」的誤判。但當給予明確提示區域後,其辨識準確度顯著提升。

例如在一張圖片中,無prompt時回答為 “No dead fish visible.”,加入提示後改為 “Yes, Region 1 and Region 2 both contain dead fish.”

這證明語言提示不僅是觸發生成,更是推論關注(attention control)的有效手段。

5. 延伸案例:煙霧偵測與火災前兆監控

在另一案例中,任務為判斷影像中是否存在煙霧。由於煙霧邊界模糊、透明度變化大,僅以 MLLM 處理常會忽略微弱煙霧。

透過YOLOv8先偵測疑似煙霧區域,再由prompt呈現如下:

The object detection model has marked regions that are suspected to contain smoke. Please help determine whether these are actual smoke or false detections. The following are the marked regions:

Region 1: Center at (488, 186), width 12, height 28

Phi-3 回答:

Yes, there appears to be smoke in the image, as indicated by the object detection model’s markings. The smoke is located at the center of the image.

此流程大幅降低誤判率,並強化回應可解釋性,在智慧城控與環境監測系統中具應用潛力。

圖 12 : 展示結合YOLOv8物件偵測與Phi-3 Vision MLLM進行魚屍辨識的實例流程。系統先由偵測模型標記可疑區域並生成Prompt,再由MLLM 進行視覺語意推理。最終模型正確判斷圖像中確實存在魚屍,顯示此整合流程能有效提升目標辨識的準確性與語意解釋力,實現自動化環境監測任務。

圖13 :展示結合物件偵測與MLLM進行煙霧判斷的應用流程。透過偵測模型標記可疑煙霧區域後,將座標資訊轉換為語意化提示輸入MLLM。模型成功辨識影像中確實存在煙霧,並能結合座標資訊提供定位說明。此結果顯示MLLM在偵測輔助下具備判斷細微視覺目標(如煙霧)之能力,適用於空品監控與智慧城市場景。

結語

本文從技術原理出發,結合理論與實測,展示了如何以Phi-3 Vision為核心模型,配合OpenVINO部署最佳化與YOLOv8偵測模組,建構可實際落地的多模態語言模型應用架構。從視覺知識推論、語言生成到物件存在驗證,Phi-3 Vision在指令驅動與結構化應答上的表現令人印象深刻,而與OD系統整合後所提升的推論精度與解釋能力,也為實務應用開啟了更多可能。

對於初學者而言,建議從「凍結視覺編碼器 + 輕量投影器 + 指令引導 LLM」這類入門級架構著手。可選擇如MiniGPT或LLaVA初版,先熟悉CLIP的encoder概念與prompt工程,再逐步導入cross-attention或查詢模組,如BLIP-2架構。整體上,Phi-3 Vision作為一款開源、結構清晰、支援量化的模型,十分適合進行教學演示與原型開發,亦可作為後續多模態研究與應用的實驗平台。

同時,本次整合示範亦凸顯了社群共享資源與實務交流的重要性。透過開源模型(如 Hugging Face 上的 Phi-3)、工具鏈(如 OpenVINO Toolkit)、與實例程式碼,學習者能在不需強大硬體的條件下實踐先進技術;社群回饋與案例分享亦能幫助大家持續最佳化prompt設計、部署邏輯與應用場景。

未來多模態模型的推進不僅依賴模型本體的演化,更需落地技術、生態建構與教育推廣三方協力。而這正是我們從教學者、開發者與應用者三重身份出發,持續投入的重要原因。

- 【實作案例】以OpenVINO實現VLM、MLLM導入產業應用 - 2025/08/07

- 【開箱評測】探索未來:結合迷你PC與生成式AI的個人多媒體助理 - 2024/09/24

- 以AI進行無人機巡檢河川地貌分析 - 2023/09/15

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!