在無人機技術的演進史中,我們正處於一個從「遠端遙控」轉向「自主意識」的關鍵轉折點。

過往,無人機若要進行複雜的影像辨識,往往需要將高解析度畫面回傳至雲端或地面站,然而延遲、斷訊與頻寬限制始終是難以逾越的障礙。隨著神經網路處理器(NPU)的微縮化,一場嵌入NPU的「Edge AI 視覺模組(Edge AI Vision Sensor)」革命正在發生。

這類裝置將感測、運算與推論封裝在指甲大小的晶片中,讓無人機具備了真正的本地端即時反應能力。本文將深入探討五款Edge AI視覺模組的技術內核,解析鏡頭、處理器與模型壓縮之間的協作邏輯,揭開邊緣智慧的神秘面紗。

當鏡頭成為大腦:全整合架構的技術躍遷

傳統的視覺方案中,相機僅負責「看」,而「想」的工作則交由外部處理器。但在小型無人機有限的載重(Payload)與功耗預算下,這種分體式架構顯得過於笨重。Edge AI 視覺模組的出現,標誌著影像傳感器(Sensor)與人工智慧(AI)的深度融合。

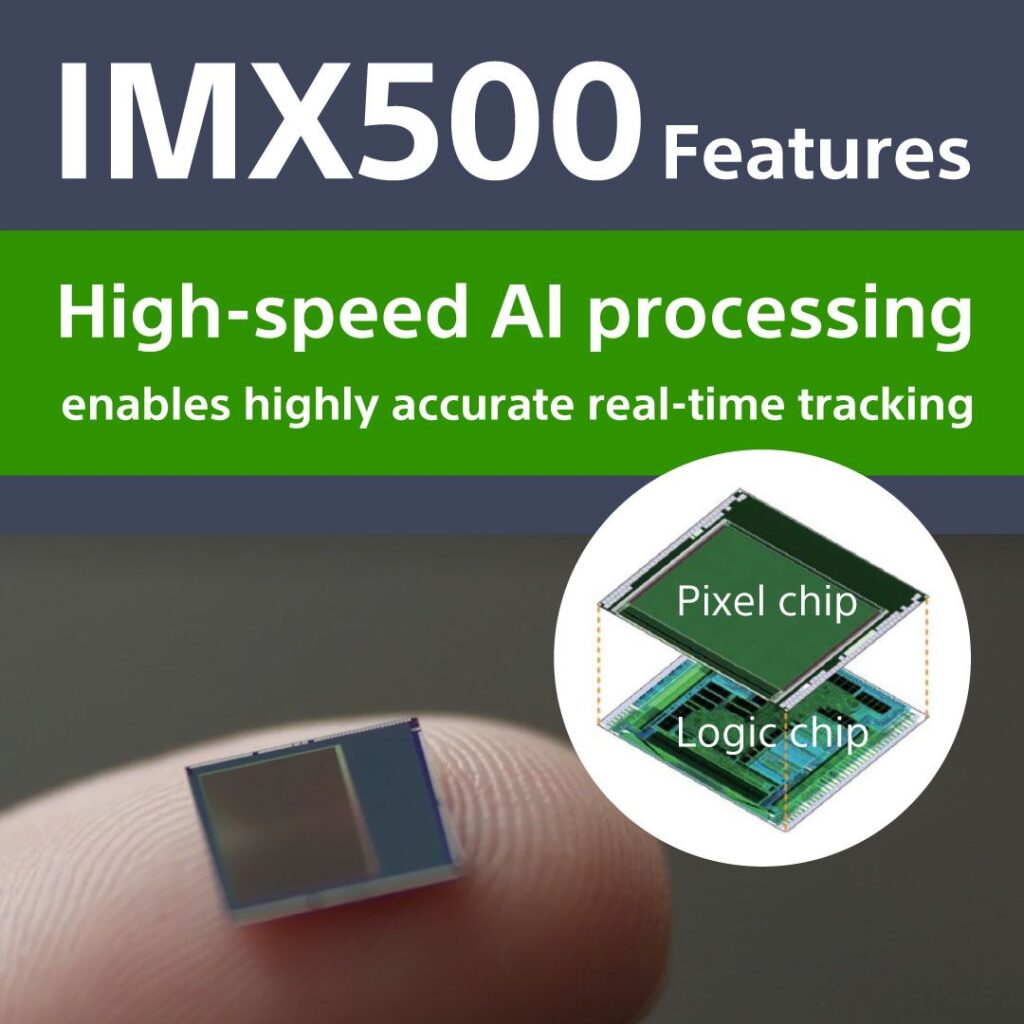

以 Sony 的 IMX500 晶片為例,這款感測器採用了堆疊式 CMOS 結構,將邏輯運算層直接焊接在像素層下方。這意味著影像資料在產生的那一刻,就已經在感測器內部完成了初步的特徵提取與張量運算。

Sony 的 IMX500 晶片 (source)

這種「感測即運算」的邏輯,徹底消除了 MIPI 或 USB 介面傳輸大流量影像時產生的功耗與延遲。對於每小時飛行時速達 80 公里的無人機而言,50 毫秒的延遲可能就意味著避障失敗。Edge AI 視覺模組透過將推論過程提前,確保了飛行控制系統能在第一時間獲取目標物體的 Metadata(元數據),而非沈重的原始像素圖。

在現今市場中,針對嵌入式視覺的解決方案已呈現百家爭鳴之勢。以下我們彙整了當前具代表性的五款Edge AI視覺模組,並針對其技術核心進行橫向對比:

| 產品名稱 | 核心處理單元 | 關鍵感測技術 | 無人機應用優勢 |

|---|---|---|---|

| Luxonis OAK-D Pro | Intel Myriad X VPU | 雙目全域快門 (Global Shutter) | 空間 AI 測距、快速移動避障 |

| RPi AI Camera | Sony IMX500 (Integrated) | 感測器內建 AI 邏輯層 | 極致輕量化、低功耗巡檢 |

| Luxonis OAK-D 4D | Qualcomm QRB5165 NPU | 高動態範圍 (HDR) 鏡頭 | 支援 Transformer 模型、高算力 |

| LUCID Helios2+ | Sony DepthSense ISP | Time of Flight (ToF) | 毫米級室內導航與精準降落 |

| Sony AITRIOS | Embedded AI DSP | 隱私導向 Metadata 輸出 | 群體行為分析、大規模智慧城市 |

解析關鍵組件:從鏡頭到矽片的精密協作

在這些智慧裝置內部,有三個核心環節決定了 AI 分析的品質:鏡頭特性、處理器架構以及模型壓縮演算法。

首先是鏡頭與感測器。對於無人機而言,最大的敵人是震動。大多數Edge AI視覺模組,如 OAK-D 系列,選擇了「全域快門(Global Shutter)」而非主流手機採用的滾動快門(Rolling Shutter)。全域快門能在同一瞬間捕捉整幅畫面,避免了高速旋轉的槳葉或機身抖動造成的歪斜扭曲。這對於需要進行「立體匹配(Stereo Matching)」的雙目視覺相機尤為重要,因為微小的幾何誤差都會導致深度計算出現數公尺的偏差。

Luxonis OAK-D Pro (source)

其次是處理器(VPU/NPU)。Luxonis OAK-D Pro所採用的 Myriad X ,即是一款極具代表性的視覺處理單元(VPU),其核心優勢在於擁有 16 個向量處理器(SHAVE 核心),專門針對圖像過濾與矩陣運算設計。

而隨著生成式 AI 興起,新款處理器(如 Qualcomm 方案)開始內建專門為 Transformer 架構優化的 NPU,這讓無人機能夠在本地端理解更複雜的語義場景,而不僅僅是辨識「這是一個人」或「那是一輛車」。Luxonis OAK-D 4D的核心即內嵌了Qualcomm的QRB5165 NPU,能支援高動態範圍 (HDR) 鏡頭,並支援 Transformer 模型、擁有極高算力。

最後,也是最常被忽視的「模型壓縮技術」。一個訓練良好的 YOLOv8 模型可能高達數百 MB,若直接放入嵌入式系統,會導致記憶體容量不足。因此,開發者必須使用量化(Quantization)技術,將權重從 FP32 轉換為 INT8。這雖然會犧牲極小(通常小於 1%)的辨識精度,卻能帶來 3 到 5 倍的速度提升。同時,透過剪枝(Pruning)技術剔除無效的神經元連接,可以讓模型更精簡地運行在相機內建的靜態隨機存取記憶體(SRAM)中。

實戰中的挑戰:散熱、供電與數據整合

儘管Edge AI視覺模組大幅縮小了體積,但「能量守恆定律」依然存在。在進行 30 FPS 的即時偵測時,處理器會散發顯著熱量。無人機在飛行時雖然擁有強大的對流風冷,但若在靜止待機或烈日下作業,AI 晶片極易因過熱而降頻。因此,先進的 AI 視覺模組通常配備鋁合金散熱外殼,或設計有專用的導熱膠連接至機身框架。

在數據整合方面,AI 視覺模組不再僅僅傳輸影片訊號(如 RTSP 串流),更多的是傳輸「事件」。例如,當相機偵測到裂縫時,它會透過 Mavlink 協定傳送一組包含座標與標籤的數據包給飛控系統(Flight Controller)。這種「非同步處理」模式讓飛控能專注於飛行姿態穩定,而將認知的重任交給智慧相機。

小結

Edge AI 視覺模組的興起,讓小型無人機從單純的「遙控飛行攝像機」進化為「具備視覺意識的自主機器人」。透過本地端即時分析,我們能夠在無網路環境的深山進行搜救、在繁雜的工業區檢測電塔、甚至在室內自動避開突發的障礙物。

隨著 Sony、Luxonis 與 Qualcomm 等廠商持續推動運算功耗比的極限,我們預期未來的 AI 視覺模組將更進一步整合「多模態辨識」,讓無人機能夠聽懂指令、看懂手勢,並在邊緣端做出更複雜的邏輯決策。(責任編輯:歐敏銓)

》延伸閱讀:

-

Luxonis DepthAI Documentation (OAK Series): https://docs.luxonis.com/

-

Sony AITRIOS Developer Site (IMX500): https://www.sony-semicon.co.jp/e/products/aitrios/

-

Raspberry Pi AI Camera Official Announcement: https://www.raspberrypi.com/news/raspberry-pi-ai-camera-on-sale-now/

-

Intel RealSense vs. Luxonis OAK: Comprehensive Comparison of Depth Sensing Tech

-

NVIDIA TensorRT Optimization Guide for Drones: High-Performance Inference on the Edge

- 【Podcast】蜂群致勝:AI 協同如何重塑作戰與智慧系統 - 2026/01/29

- Edge AI 視覺模組如何讓無人機智慧飛上天際? - 2026/01/29

- AI需求推升記憶體市場產值連創高峰 2027可望實現50%以上年成長 - 2026/01/28

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!