「不是讓硬體去遷就 AI,而是讓 AI 學會在最小的硬體上思考。」

在人工智慧橫掃各產業的時代,物件偵測(Object Detection)已成為許多邊緣應用的靈魂技術——從智慧監控、無人機導航,到工業瑕疵檢測與農作影像分析,幾乎每一個視覺決策系統都離不開這項任務。然而,要讓模型在雲端伺服器上運作並不難,真正的挑戰,是如何讓它在僅有數百 KB 記憶體的微控制器(MCU)上即時偵測影像中的物件。

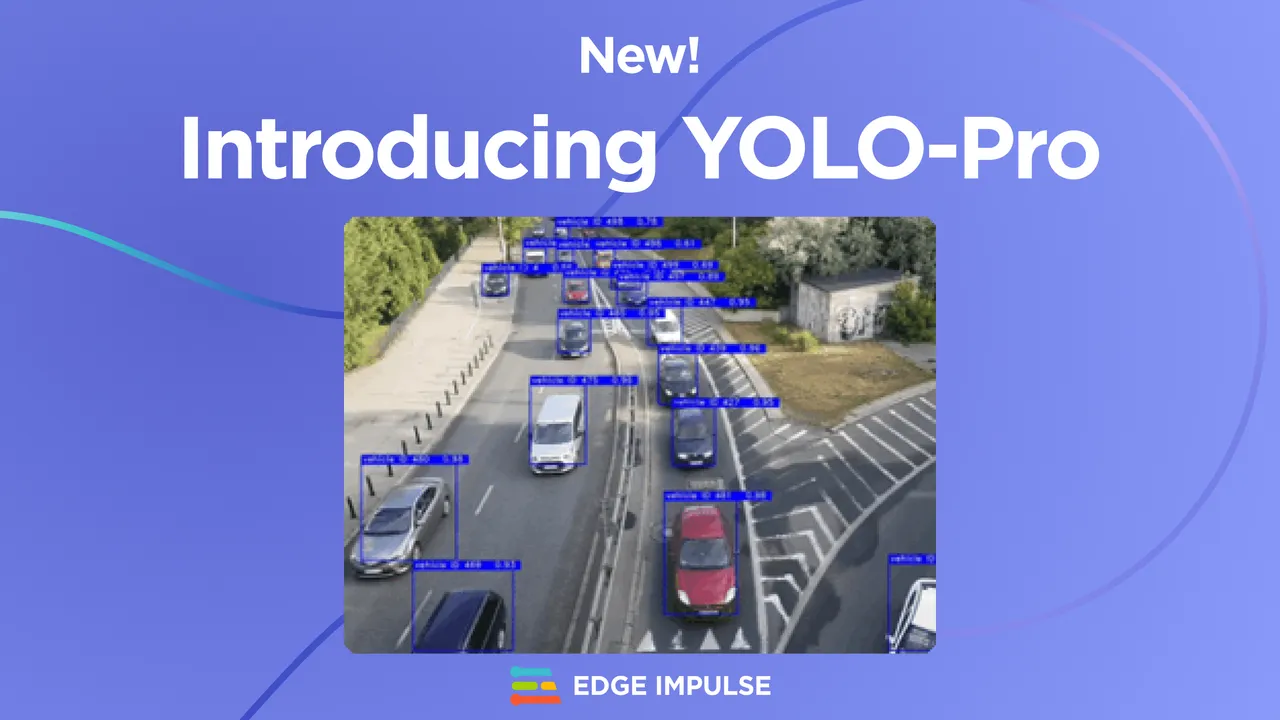

Edge Impulse 的 YOLO-Pro 正是為了解決這個痛點而誕生。它不是 YOLOv8 的縮小版,而是一個從底層為邊緣環境重新打造的 YOLO 分支。在不到 1 MB 的模型下仍能維持驚人的偵測精度,堪稱「讓微控制器看得懂世界」的關鍵突破。

從 YOLO 到 YOLO-Pro:讓速度與效率並存

YOLO(You Only Look Once)系列自 2016 年問世以來,一直是即時物件偵測的代名詞。它將影像分割成網格,在單次前向傳遞中同時預測多個物體的位置與類別,大幅超越傳統的 R-CNN 系列。YOLO 的理念簡單卻徹底改變了電腦視覺的生態——一次看、一眼辨識。

但問題在於,這些模型生來就是為雲端 GPU 而設計的。即便是最小的 YOLOv5s,也擁有數百 MB 參數與龐大運算量,對於資源受限的邊緣設備而言,根本無法承受。當開發者想把 YOLO 搬進嵌入式系統,如 STM32、ESP32、Raspberry Pi Zero 或 NVIDIA Jetson Nano 時,往往得在速度與準確率之間艱難取捨。

Edge Impulse 的研究團隊決定重寫規則。他們不是單純「裁切」模型,而是從零設計了一個全新的 YOLO 架構,讓它能在「微瓦級功耗」的晶片上維持足夠的準確率與即時性。這個全新模型族,被命名為 YOLO-Pro。

YOLO-Pro架構選擇(source)

專為邊緣設計的模型族譜

YOLO-Pro 的命名延續了 YOLO 的精神,但架構卻是完全重新打造。它包含六種不同尺寸,讓開發者能根據目標設備靈活取捨效能與資源:

- Pico:僅 682K 參數,可運行於高階微控制器;

- Nano(2.4 M)、Small(6.9 M):針對低功耗 CPU 或中階 AI 模組;

- Medium(16.6 M)、Large(30 M)、X-Large(35 M):為 Jetson Orin、Coral TPU 等邊緣 AI 加速平台量身打造。

這樣的多層級架構讓 YOLO-Pro 能橫跨 IoT、工業與機器人領域。無論是檢測倉儲貨物、追蹤機械臂運動,還是協助農業無人機識別果實成熟度,開發者都能找到合適的模型規模。

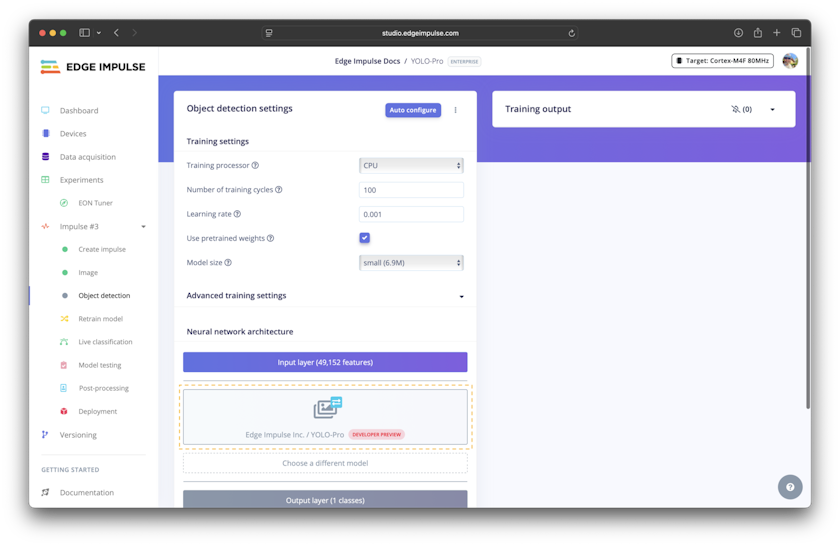

Edge Impulse 更將 YOLO-Pro 與自家 Edge Impulse Studio 完整整合。開發者不需手動調參,只要在圖形化介面中選擇 YOLO-Pro 模型,EON Tuner 便會根據資料集與硬體自動優化設定,實現「一鍵適配」。

兩種架構哲學:Attention vs. ReLU 的工程辯證

YOLO-Pro 不僅在體積上壓縮到極致,也針對不同硬體場景設計了兩種核心架構,體現了邊緣 AI 的工程哲學。

1. Attention with SiLU

延續傳統 YOLO 的高階設計,主幹網路中引入部分自注意力機制(Partial Attention),並採用 SiLU(Sigmoid Linear Unit)作為啟動函數。這種結構能更準確聚焦關鍵區域,適合具備 GPU 或高效 NPU 的平台,例如 Jetson Nano、Raspberry Pi 5 等。

2. No Attention with ReLU

為低階硬體而設的版本。Edge Impulse 果斷移除注意力模組,並改用運算更輕量的 ReLU 函數,讓模型能在不支援浮點運算的微控制器上流暢執行。這個版本運行速度可提升數倍,是真正為「邊緣原生」設計的 YOLO。

這種在注意力與運算之間的取捨,正是邊緣 AI 的核心思維:不盲目追求絕對性能,而是在受限環境中達成最優解。

資料增強:讓小資料集也能學會看世界

邊緣設備的另一個挑戰是資料匱乏。許多應用場景(如農業監控或製造線檢測)無法蒐集大量標註影像。YOLO-Pro 為此內建了強大的 資料增強(Data Augmentation)模組,結合空間變換(spatial transform)與色彩變換(color space transform),自動生成多樣化的訓練樣本。

這項功能來自 KerasCV 的預處理層,可根據應用需求動態調整。例如固定攝影機的場景可減少空間變換,而顏色敏感的應用(如紅外線檢測)則可關閉色彩增強。這樣的細緻設計,讓模型即使以小型資料集訓練,也能在真實環境中穩定運作。

從訓練到部署:一條龍的邊緣 AI 體驗

Edge Impulse 將 YOLO-Pro 打造為一個「即插即用」的開發體驗。整個過程僅需五個步驟:

- 在 Edge Impulse Studio 中建立物件偵測模組;

- 選擇 YOLO-Pro 架構與模型尺寸;

- 使用 Auto-configure 自動選擇最佳化參數;

- 執行訓練並檢視結果;

- 一鍵部署至微控制器或 GPU 平台。

整個流程不需額外授權,也不受傳統 YOLO 模型的商用限制。這讓企業可直接將 YOLO-Pro 整合入商業產品,如智慧零售監控、機械手臂視覺系統、交通安全檢測等,縮短從原型到量產的開發週期。

技術意義:邊緣 AI 的新臨界點

YOLO-Pro 的出現,標誌著邊緣 AI 正進入一個全新臨界點。

它在多個層面上重新定義了物體偵測的能效平衡:

- 記憶體壓縮:模型大小僅為傳統 YOLO 的 1/50;

- 延遲縮短:在 MCU 上可達到 10 FPS 的即時辨識;

- 功耗降低:僅需數百毫瓦即可長時間運作;

- 部署無縫:全面整合於 Edge Impulse Studio,免授權限制。

這些特性讓開發者能「以最小的硬體,實現最聰明的應用」,同時也推動 IoT 裝置真正具備「視覺感知」的能力。AI 的眼睛,不再停留在雲端,而是深入每一個現場。

開發者的機會:從創客專案到智慧工廠

對開發者與創客社群而言,YOLO-Pro 帶來的不只是技術上的突破,更是一種開發模式的轉變。

過去,邊緣 AI 專案往往受限於硬體效能或授權問題,難以快速原型化。如今,透過 Edge Impulse 的雲端平台與 YOLO-Pro 模型,創客能在短時間內打造具備「視覺智能」的裝置,並在無需昂貴 GPU 的情況下完成訓練與部署。

例如,開發者可利用 Arduino Nicla Vision、Raspberry Pi 或 Seeed Studio reTerminal 等平台,結合 YOLO-Pro 進行工業瑕疵檢測、倉儲物件辨識或農作物監測,甚至在智慧城市實驗場域中部署低功耗的 AI 感測節點。這些應用不再只是大型企業的專利,而是任何具創造力的工程師都能參與的創新實驗。

讓 AI 的眼睛走向現場

過去十年,YOLO 為電腦視覺打開了速度的新紀元;而 YOLO-Pro,則讓這雙眼睛走出了伺服器,走向街角、工廠與每一台感測裝置。當一個 682K 參數的模型能在微控制器上理解世界,YOLO-Pro將成為推動「AI 無所不在」的重要引擎。

(責任編輯:歐敏銓)

》延伸閱讀:

Introducing YOLO-Pro: Object Detection Optimized for the Edge

- 數位保育行動:AI演算法如何編織全球生態防護網? - 2026/03/03

- Anritsu攜手聯發科以無線通訊測試平台驗證AI加速技術 - 2026/03/02

- 【Podcast】綠色守望者:AI 如何保護亞馬遜免於非法採金 - 2026/03/02

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!