Hugging Face 正重新定義 AI 推論生態。透過 Inference Providers 架構,開發者可在 Hub 上自由選擇推論服務,從即時雲端到企業專用端點,一次串連多個 provider,開放、可控、低延遲地運行模型。

幾年前,Hugging Face 的 Inference API 曾是許多開發者接觸雲端推論的第一扇門。你只需將模型名稱與輸入資料傳入簡單的 API,就能在雲端即時獲得結果。這種「即開即用」的服務讓機器學習的推論像點餐一樣方便,也使 Hugging Face 從模型社群平台進化為推論基礎建設的供應者。

然而,AI 模型的版圖已不再單純。開發者如今需要更彈性的部署方式:有的專注低延遲推論,有的要求資料留在自有伺服器中,有的追求成本最佳化或特定硬體加速。面對這些多元場景,單一雲端 API 已難以滿足。

這正是 Inference Providers 誕生的背景。

Hugging Face 在 2024 年末正式推出這項新架構,將推論從「一個 API」重新定義為「多個可互換的供應者(providers)」之間的協作機制。開發者不再只仰賴官方提供的雲端端點,而能透過統一的 Hub 介面,選擇由不同企業、研究組織,甚至自建系統所提供的推論資源。

就像 App Store 讓開發者自由上架應用,Inference Providers 讓 AI 模型有了自己的執行市場。

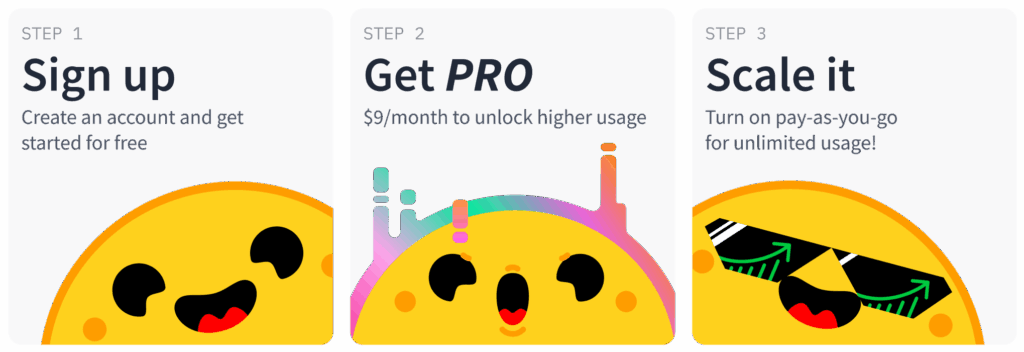

三步上手 Hugging Face Inference Providers

許多開發者對開源 AI 模型望而卻步,總以為部署過於複雜。但其實,只要三步,你就能在不到五分鐘的時間內,使用最先進的模型,且不需任何額外基礎建設。

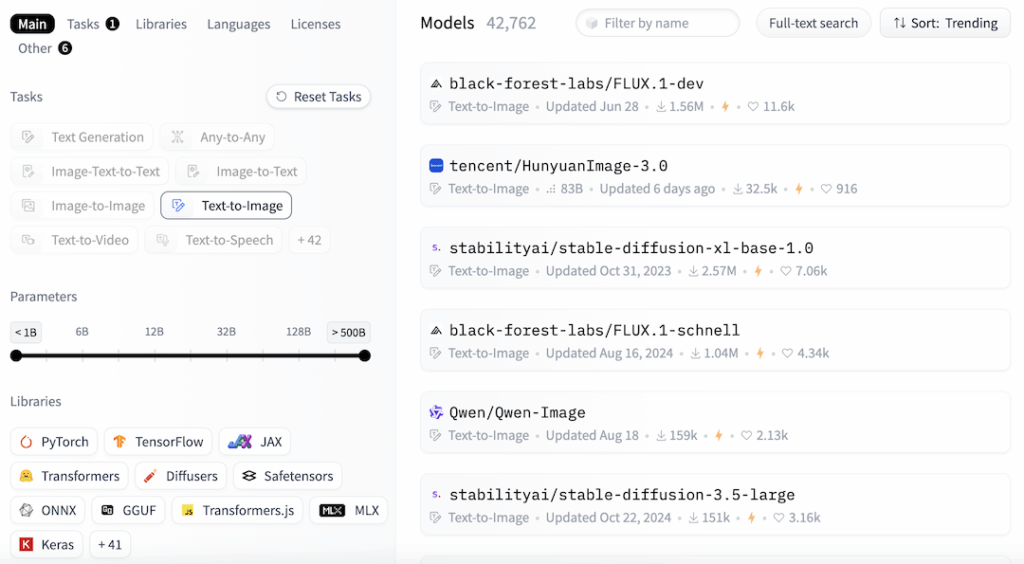

第一步:在 Hub 找到模型

打開 Hugging Face Hub,利用「Inference Providers」篩選器挑選你想使用的 provider。找到模型後,進入模型頁面,右側就能看到推論小工具(Inference Widget)。這是一個直觀的操作入口,讓你直接在瀏覽器中與模型互動。

第二步:試用互動小工具

在動手寫程式碼之前,先用這個小工具測試模型。你可以直接在頁面上輸入資料,從任何可用的 provider 獲得結果,還能即時感受不同 provider 的表現。同時,小工具也提供了對應的程式碼片段,方便你複製到自己的專案中。

第三步:從點擊到程式碼

確認模型表現後,點擊小工具中的「View Code Snippets」按鈕,就能看到 Python 範例程式碼。只需將程式碼中的 Hugging Face 使用者存取權杖(User Access Token)填入,即可在本地或伺服器環境中複製小工具的操作,實現與模型的互動。

一個 Hub,無限供應者

在技術層面,Hugging Face Hub 成為整個推論生態的中樞。當使用者在模型頁面上做了選擇,背後實際啟動的可能不再是 Hugging Face 自家的伺服器,而是由外部 provider 所支撐的運算節點。

這樣的設計實現了三個目標:統一介面、分散推論、集中管理。

- 統一介面:無論是哪個 provider,開發者都能用相同的 API 語法與 SDK(如

InferenceClient

)呼叫模型。

- 分散推論:不同 provider 各自運行在不同雲平台與硬體架構上,提升靈活性與可擴充性。

- 集中管理:帳單、權限、用量統一在 Hugging Face 帳號中管理,開發者不需分散操作。

從使用者角度來看,整個過程近乎無縫。你只需在呼叫參數中加入一行:

client = InferenceClient(model="meta-llama/Llama-3-8b", provider="public-ai")

這一行就足以讓推論從 Hugging Face 自家雲端切換到 Public AI 的運算節點。

這種「抽象層式推論」的理念,讓 Hugging Face 從單一服務商蛻變為推論生態的「控制塔」。

Provider 生態系:Public AI、Replicate、Cohere 的角色

目前在 Hugging Face Hub 上,已有數個主要的推論提供者(Providers)進駐。它們代表著不同的技術哲學,也映照出 AI 推論產業的分工變化。

Public AI:開放架構的即時推論

Public AI 是最早與 Hugging Face 深度整合的第三方 provider。它的理念簡單卻前衛:讓所有模型都能被即時推論,無需自行部署或排隊。

它採用高效 GPU 叢集與分散式快取機制,將 Hugging Face 上的熱門模型預先編譯並緩存於邊緣節點中。這讓開發者幾乎能即時獲得回應,同時減少了頻繁冷啟動的延遲。

對於正在開發互動式應用(例如 AI 助手、智慧客服)的團隊而言,Public AI 提供的是一種「以速度為核心」的推論體驗。

Replicate:讓模型像 API 一樣部署

與之對比,Replicate 則以「模型即服務(Model-as-a-Service)」的概念聞名。開發者可以在 Replicate 上託管自己的模型版本,並在 Hugging Face 上標註使用該 provider。

與之對比,Replicate 則以「模型即服務(Model-as-a-Service)」的概念聞名。開發者可以在 Replicate 上託管自己的模型版本,並在 Hugging Face 上標註使用該 provider。

這讓 Hugging Face Hub 成為一個模型的「展示窗」,而 Replicate 負責背後的執行。許多影像生成與多模態應用開發者喜愛這種模式,因為它允許更細緻的環境控制(如 CUDA 版本、專用權限),同時保留公開可分享的接口。

Cohere:語言模型專家的專屬空間

Cohere 作為大型語言模型(LLM)專家,在 provider 架構中提供了更高層級的語言推論服務。它不僅讓 Hugging Face 使用者能直接使用 Cohere Command 系列模型,也提供安全審核、企業級日誌與隱私隔離功能。

在金融與醫療領域中,這樣的 provider 具有特殊價值——讓企業能在信任邊界內享受 Hugging Face 的開放生態。

一個「多中心」的推論未來

從某種意義上,Inference Providers 的出現象徵了 Hugging Face 從「單一平台」走向「多中心網絡」的轉變。這不僅是技術策略,更是生態戰略的升級。

在舊模式中,模型開發、訓練、部署往往分屬不同平台:模型在 Hub 上託管、推論在雲端 API 執行、效能監控則交由第三方。而現在,Hugging Face 透過 provider 把這三個環節重新串接,讓開發者能在同一生態中選擇最適合的組合。

對企業與開發者而言,這種設計意味著:

- 自由選擇與競爭:不必被單一供應商綁定。

- 生態整合:一個模型可以同時被多個 provider 提供推論。

- 成本透明化:Hub 上清楚顯示各 provider 的價格、延遲與可用性。

換言之,Inference Providers 把推論從「技術服務」變成了「市場機制」。

小結

Inference Providers 並非只是 API 的升級,而是整個 AI 雲端生態的結構重寫。它讓推論不再被鎖定在單一供應商的黑盒中,而是成為一個可觀察、可替換、可競爭的市場。

未來,當更多供應商加入這個體系,推論將逐步走向「去中心化」——開發者能在最靠近用戶的節點上執行模型,企業能自主選擇符合合規要求的 provider,研究者能跨平臺共享模型效能。

- 數位保育行動:AI演算法如何編織全球生態防護網? - 2026/03/03

- Anritsu攜手聯發科以無線通訊測試平台驗證AI加速技術 - 2026/03/02

- 【Podcast】綠色守望者:AI 如何保護亞馬遜免於非法採金 - 2026/03/02

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!