大家對黃仁勳的虛擬化身(Avatar)或電視新聞的AI主播應該都很有印象吧,在AI的應用中,不論是真人的化身或虛構的AI角色,將會愈來愈多,也愈來愈真實,這樣的角色可統稱為Digital Human(數位人類)。

![]() 註:另一個很接近的詞為Digital Twin,中文翻為「數位孿生」,它的意涵更廣泛,指的是在虛擬空間中創建與現實物理世界中的物體、系統或流程相對應的數字化模型,這些模型能夠反映實體對象的狀態、行為和特性,並進行即時更新和模擬。

註:另一個很接近的詞為Digital Twin,中文翻為「數位孿生」,它的意涵更廣泛,指的是在虛擬空間中創建與現實物理世界中的物體、系統或流程相對應的數字化模型,這些模型能夠反映實體對象的狀態、行為和特性,並進行即時更新和模擬。

Digital Human 的實現融合了人工智慧、電腦繪圖及自然語言處理等技術,旨在模擬人類的外貌、語音、行為以及情感表達。它的應用很廣,可以成為企業的品牌大使及客服角色,在品牌官網上與客戶進行對話,也用於實體活動的說明導覽。當然,也可以化身賣場的服裝秀女郎,甚至成為你的虛擬情人或遊戲人物,在未來的元宇宙中也將扮演重要角色。

關鍵技術

1. 3D建模與動畫

- 角色建模: 利用3D建模工具(如 Blender、Maya)構建高精度的數位人類外觀,包括皮膚紋理、毛髮和服裝。

- 骨骼動畫與面部捕捉: 利用骨骼架構模擬動作,並通過面部捕捉技術(如 Apple ARKit、MetaHuman)同步捕捉面部表情變化,實現真實的動態表現。

2. 自然語言處理(NLP)

- 語音識別與生成: 數位人類能夠理解語音(如 Google Speech-to-Text)並生成自然且流暢的語音回應(如 TTS 技術)。

- 語義分析: 結合大語言模型(如 OpenAI 的 GPT),理解上下文語義並生成具體且有意義的回答。

- 多語言支持: 提供即時的語言翻譯與多語言交流能力。

3. 電腦視覺(Computer Vision)

- 手勢與動作捕捉: 通過深度攝像頭或傳感器捕捉用戶手勢、肢體動作,實現即時的互動。

- 情感識別: 分析人類的面部表情、聲調或行為,判斷情感狀態並作出對應的情感表達。

4. 情感AI與行為建模

- 情感AI: 數位人類結合情感計算,根據對話內容或環境作出相應的情感反應。

- 行為預測與個性化: 通過深度學習,學習用戶習慣與偏好,實現個性化互動。

5. 語音合成與語音變形

- 使用先進的語音合成技術(如 WaveNet、Tacotron 2)生成高品質、自然的語音。

- 語音變形技術讓數位人類能模擬不同年齡、性別或情感狀態的聲音。

6. 實時渲染與雲端計算

- 實時渲染: 使用引擎(如 Unreal Engine、Unity)提供高效能的即時圖形處理,保證數位人類的流暢呈現。

- 雲端運算: 將計算資源集中於雲端,減輕終端設備的負擔,實現跨平台支持。

7. 多模態交互

- 數位人類能將語音、文字、手勢、面部表情等多模態信號結合,提供更加豐富且直觀的互動體驗。

主要挑戰:多模態情感辨識

在上述的7大關鍵技術中,有多項都提到「情感辨識」,且統稱為情感人工智慧(Emotion AI)技術。此技術旨在使AI系統能夠識別、理解並回應人類的情緒狀態。這項技術結合了多種領域的研究,包括自然語言處理、電腦視覺、語音識別和心理學等:

- 語音情感識別: 透過分析語音的音調、速度和音量等特徵,AI可以判斷說話者的情緒。例如,新創公司Hume AI開發了具備情商的語音AI工具,能夠分析用戶語音訊息中的語氣,理解使用者的情緒和心理狀態,並做出即時回應。

- 面部表情分析: 利用計算機視覺技術,AI能夠識別並解讀人類的面部表情,以判斷情緒。然而,研究指出,臉部動作與情緒未必正相關,且文化差異可能影響準確性。

- 文本情感分析: 通過自然語言處理技術,AI可以分析文本中的情感傾向,識別正面、負面或中性的情緒。這在社交媒體監控和客戶反饋分析中有廣泛應用。

- 多模態情感識別: 結合語音、面部表情和文本等多種數據來源,提供更全面的情感識別能力。這種方法有助於提高情感識別的準確性和可靠性。

Digital Human解決方案

以下介紹幾個Digital Human解決方案,有興趣可以試試:

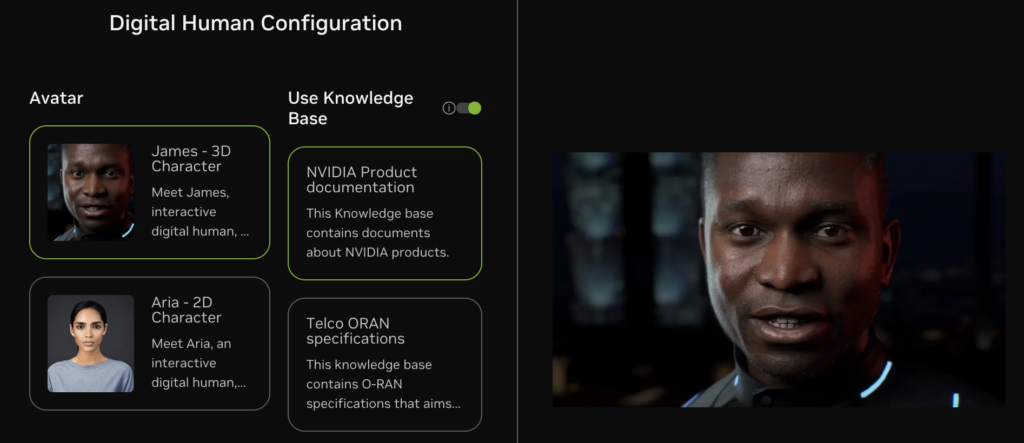

1. NVIDIA ACE

NVIDIA ACE(Avatar Cloud Engine)是一套利用生成式人工智慧(Generative AI)技術,為數位化身、AI非玩家角色(NPC)和互動式虛擬形象賦予生命的解決方案。ACE技術包裝為NVIDIA推理微服務(NIM),提供易於部署且高性能的微服務,協助開發者在遊戲和應用程式中創建栩栩如生的數位角色。

(Source)

2. Intel OpenVINO

由Intel主導開發的OpenVINO開源平台,也提供一些Digital Human的解決方案,包括對Digital Human-TTS (GPT-SoVITs)的支援,GPT-SoVITS是一個強大的語音Clone模型,支援少量的語音轉換和文字轉語音。您只需提供5秒的語音樣本,即可體驗相似度80%~95%的語音複製。如果您提供1分鐘的語音樣本,就可以接近真人的效果,訓練出高品質的TTS模型。技術內容可參考本文介紹。

另一個方案則是Wav2Lip,它能在開放環境下僅使用一段影片與一段音頻生成準確的2D唇同步影片。Wav2Lip 利用精確的唇同步「專家」模型及連續的人臉幀來生成準確且自然的唇部動作。Intel這篇文章中將介紹如何使用 OpenVINO 啟用和最佳化 Wav2Lippipeline 。

3. Hume AI

Hume AI是一家專注於情緒分析技術的新創公司,相較於一般只能分辨「快樂」、「悲傷」、「憤怒」、「害怕」等基本情緒的AI能力,Hume AI在其網站上列出了它能夠檢測用戶的53 種不同情緒,包括欽佩、崇拜、美感、娛樂、憤怒、煩惱、焦慮、敬畏、尷尬、無聊、冷靜、專注、錯亂、沉思、鄙視、滿意、渴望、慾望、決心、失望等。

Hume AI 的理論是,透過開發能夠更精細地理解和表達人類情感的 AI 模型,它可以更好地為用戶服務——作為「願意的耳朵」傾聽和理解他們的感受,同時也提供更現實和令人滿意的客戶支援、資訊檢索、陪伴、腦力激盪、知識工作協作等。

小結

隨著生成式AI、大語言模型、電腦視覺技術及多模態情感AI辨識等技術的進步,Digital Human的真實性和慧程度將持續提升,可望成為與你我在數位社會中頻繁互動的角色喔。

(責任編輯:歐敏銓)

》延伸閱讀:

- 邊緣覺醒:Edge AI如何實現無人機SLAM即時建圖 - 2026/02/23

- Ceva Wi-Fi 6和藍牙IP支援Renesas物聯網/智慧家庭組合式MCU - 2026/02/13

- 【Podcast】機器人的巧手革命:靈巧手如何推動實體 AI 崛起 - 2026/02/12

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!