作者:陸向陽

2022年11月ChatGPT上線掀起大語言模型(Large Language Model, LLM)風潮,但模型的參數量過大,只能在雲端用大量電腦運算才能即時文字回應。然近期愈來愈多輕量版的LLM登場,開始能夠在一般電腦上安裝使用,如NVIDIA Chat with RTX、AMD LLM Studio等。

不過有些還是需要一些技術知識,沒那麼好實現,本文在這裡介紹一套超快實現本機端LLM的方法,那就是用Ollama這套軟體,以下逐一說明。

實務操作

1.先到Ollama官網,網址https://www.ollama.com/

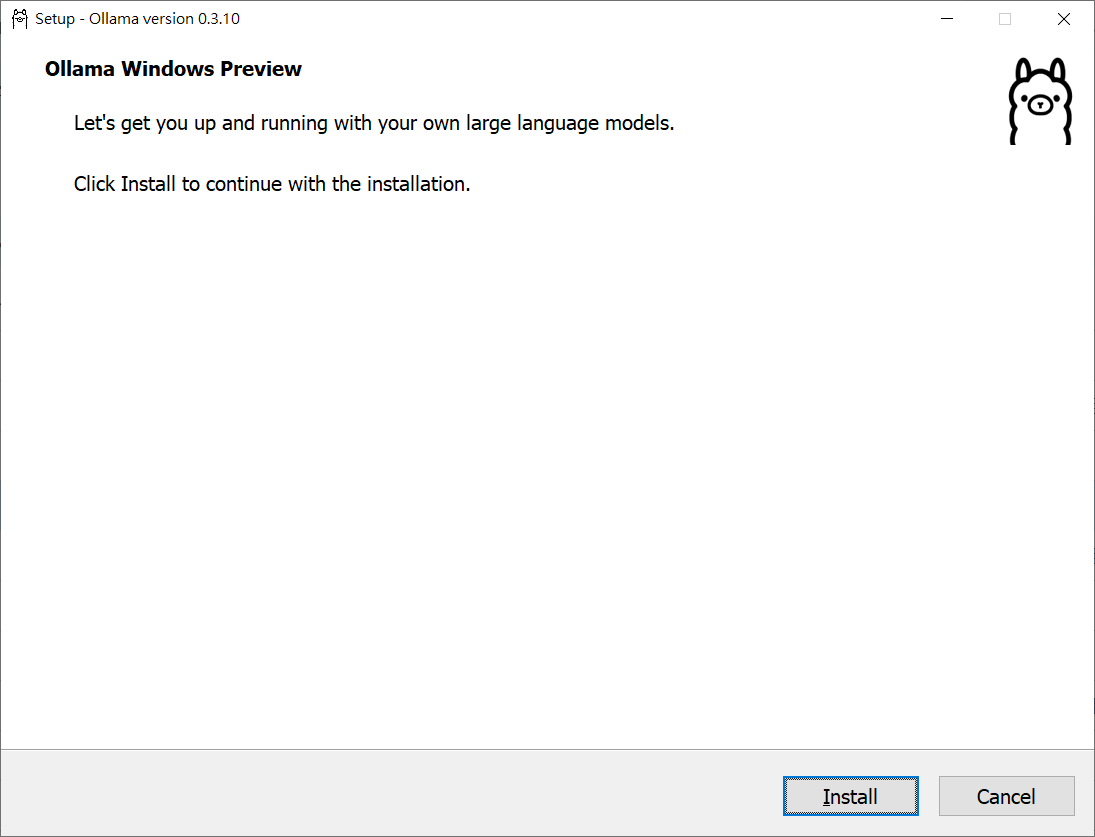

假定多數人是使用Windows(也有Mac版、Linux版,本次暫跳略說明),必須是使用Windows 10(含10)之後的作業系統版本才能安裝Ollama,目前Ollama軟體本身也在預覽(preview)階段,不能期許太多,按下「Download」,然後選擇「Windows」,再按「Download for Windows (Preview)」開始正式下載「OllamaSetup.exe」檔案,檔案容量約645MB(0.3.10版,2024年9月)。

2.下載完成後雙按「OllamaSetup.exe」開始安裝,就跟一般安裝應用程式一樣,一直按「下一步」就完成了,然後從Windows的開始工具列去啟動Ollama,Ollama就會在右下角的狀態列常駐執行。

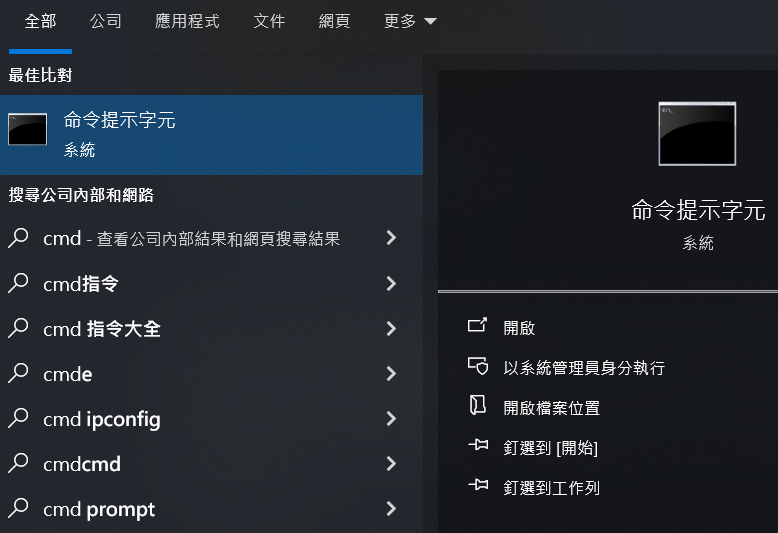

3.接下來要啟動Windows的命令列模式,即「命令提示字元」,先按左下角Windows圖示圖案,然後打英文字cmd(command一詞的縮寫),就會浮現「命令提示字元」,按下它讓它執行:

命令提示字元可以用「系統管理員身分」執行,但本次沒有必要,以一般身分執行即可,執行後就出現一個黑暗的視窗,筆者在這裡暫時挖去自己的使用者身分,但無礙說明:

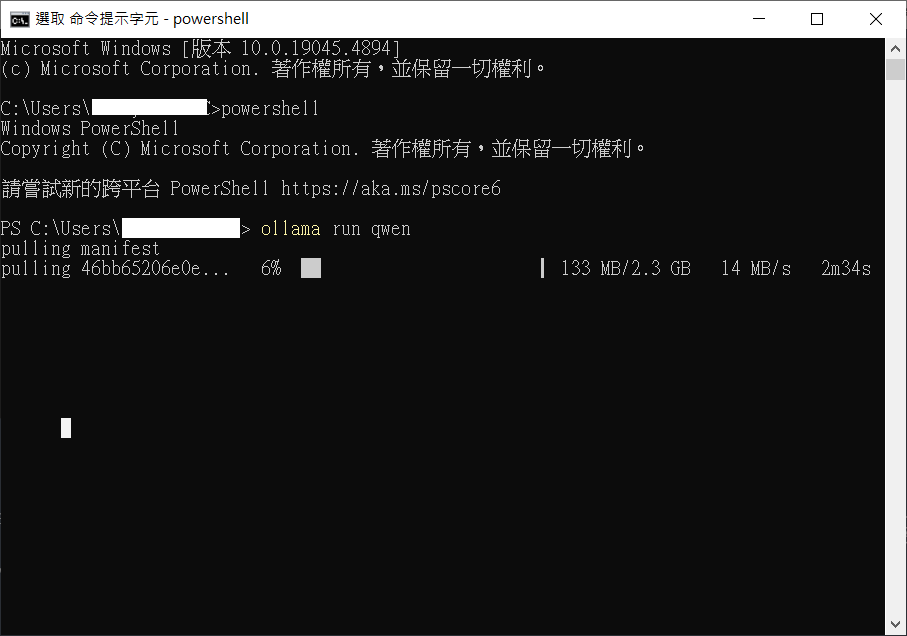

4.接著在視窗中輸入「powershell」字樣然後按「Enter」,如此將進入Powershell模式:

5.由於我們是要儘快獲得成就感,這裡先打「ollama run qwen」按下Enter,先有結果我們再來解釋。按下Enter後,Ollama開始從網路上下載一個名為qwen的LLM,並且會執行該模型,以下是下載過程的畫面,下載進度為6%,等待變成100%:

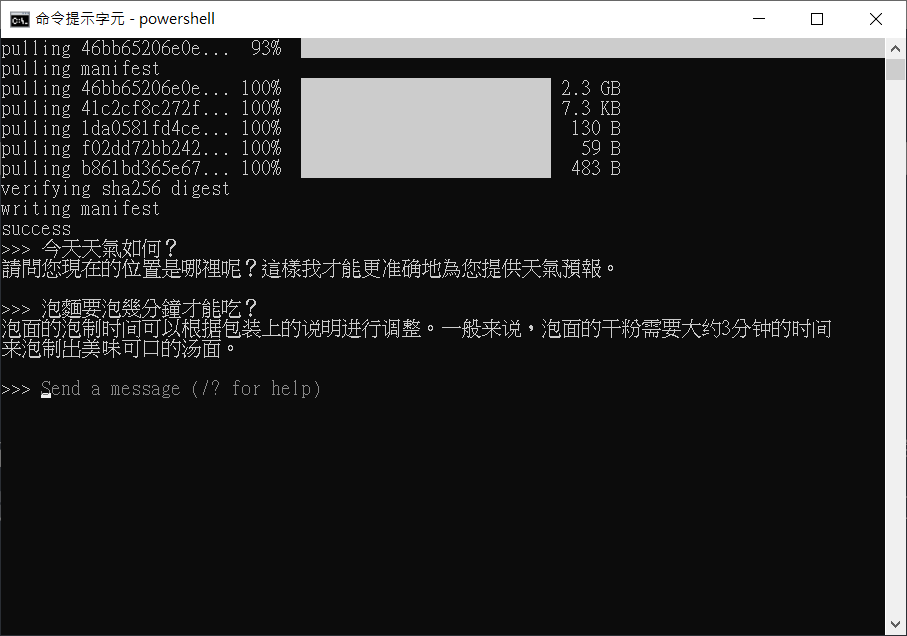

6.到達100%即告模型下載完成,同時也順帶自動執行,到此就完成了,接下來就跟使用ChatGPT一樣,直接打中文,qwen模型就會用人性化文字跟您回應了:

如果要離開Ollama,只要打「/bye」即可,想離開Poweshell只要打「exit」,想離開命令提示字元狀態也是只要打「exit」,就可以回到一般Windows狀態。

機理解說

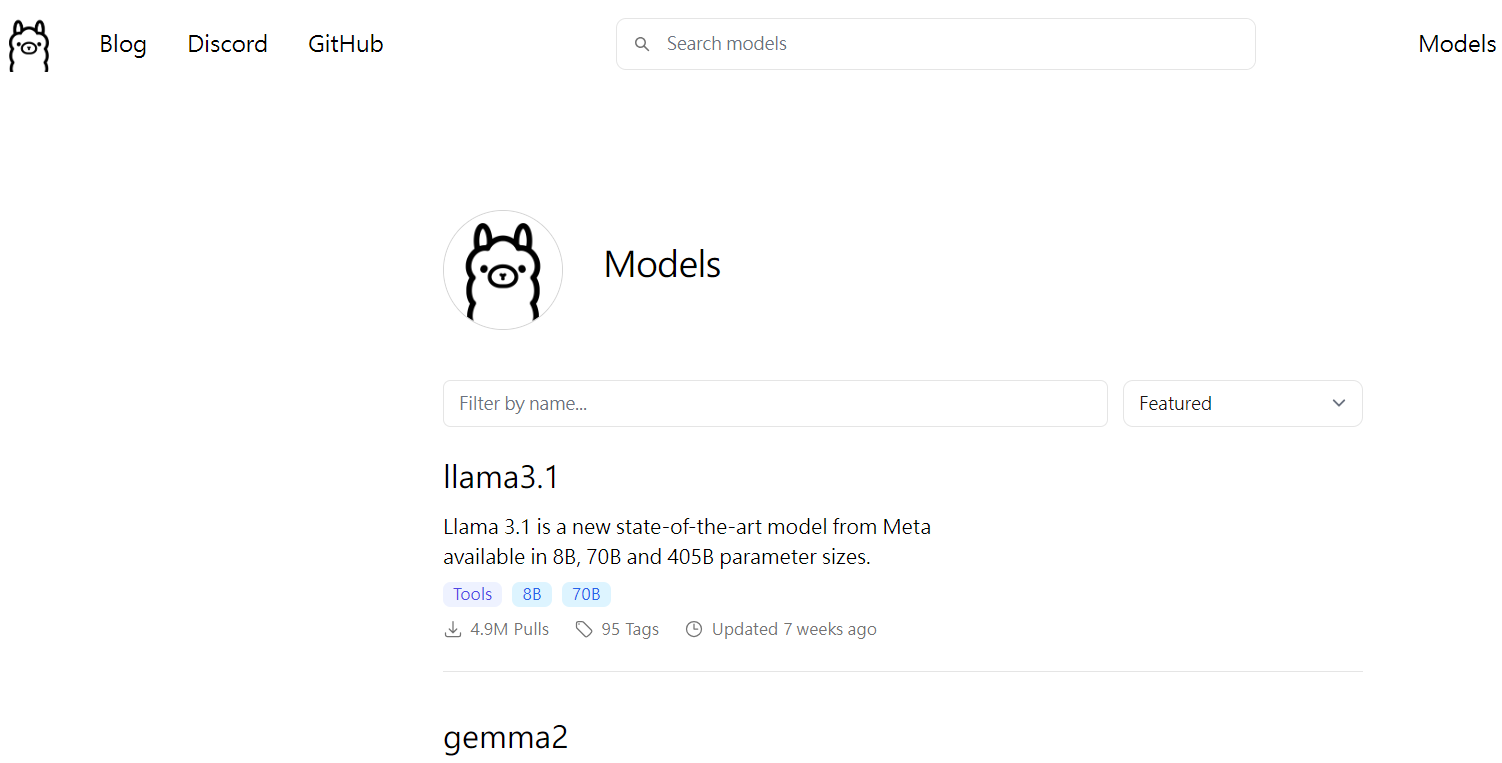

實務操作至此,接下來回到機理解說,其實Ollama有許多模型可以用,各位可以到官網點按「Models」字樣的頁面,就會羅列出Ollama所有可用的模型,目前大約有幾十個可用,我們本次所用的qwen自然也在其中:

以上的示範之所以使用qwen模型,主要是這個模型的參數非常少,模型容量小,即前述的2.3GB,且支援中文,目前Ollama上許多LLM是只支援英文文字對話的,此外qwen模型回應的文字是簡體中文,主要是qwen是由對岸開發訓練而成,中文名稱叫「通義千問」。

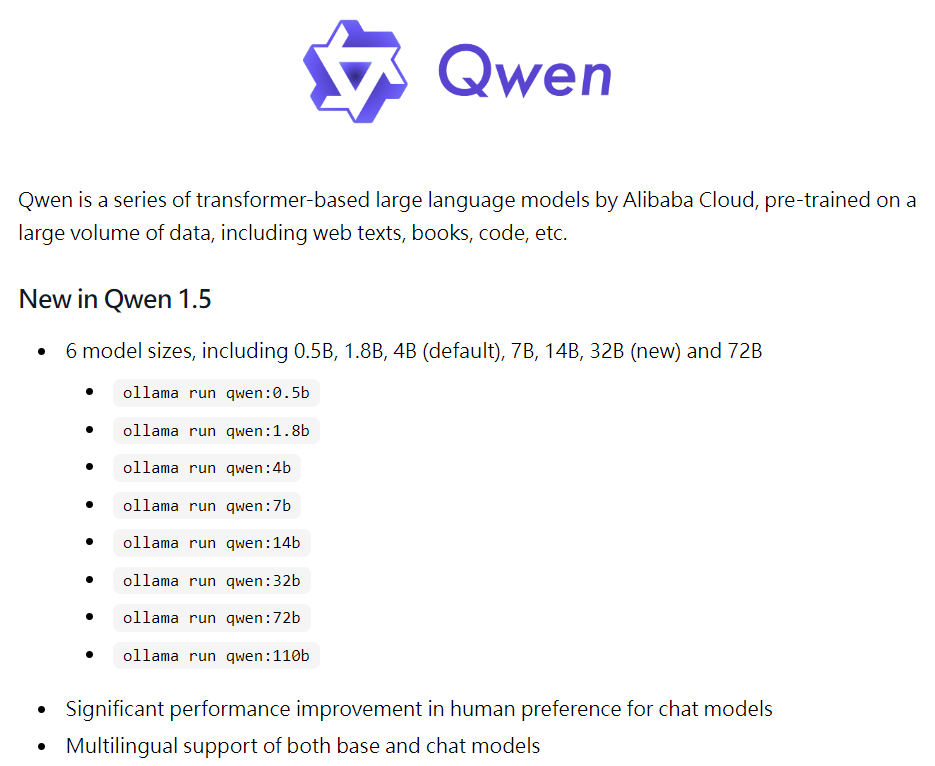

Qwen其實有不同參數量的版本,2.3GB這個其實是4B(40億個參數),嚴格而論是39.5億個參數,每個參數權重為4-bit,更嚴格說目前Qwen是1.5版,之後也有Qwen 2版。

Qwen 1.5預設是使用4B參數版本,但也有更多或更少參數的版本,例如0.5B、1.8B,或者是7B、14B、32B、72B、110B等,參數越多其實需要越大的硬碟空間跟記憶體才能執行,且需要更強的運算力才能即時回應,筆者嘗試用過Qwen 1.5的7B版,以互動上的直覺感受而言,確實反應時間比4B版慢一倍。

若想執行其他參數版本的Qwen 1.5模型,下命令時就得稍微改一下,例如改成ollama run qwen:1.8b、ollama run qwen:7b等。

同理,想改下載與使用其他的LLM,只要在Models網頁查詢模型名稱,直接改變下達的命令即可,例如要使用Google的開放原碼大語言模型gemma2,只要下ollama run gemma2即可,Gemma2目前有2B、9B、27B三種參數版本,預設是9B版(92.4億個參數),容量約5.4GB,這些資訊都在Models的頁面上有說明。

小結

最後,因為ollama預設是把下載的模型放在C:\Users\user\.ollama位置,今日電腦的C槽很多是寶貴的固態硬碟空間,容量有限、抹寫壽命有限,畢竟LLM模型動輒GB等級的佔量,故建議變更存放模型的位置。

變更方式是在Windows的系統環境變數內新增一則系統變數,變數名為OLLAMA_MODELS,變數值則為新指定的路徑位置,例如改成D:\ollama,儲存後重新開機即可,後續下載的模型就會改到新位置上。

除上述外ollama還有許多地方可以細玩,例如更新ollma主體程式、檢視其日誌檔內容、使用ollama目前支援的硬體來加速執行,例如今年3月份開始支援用AMD的顯示卡來加速等。後續有機會再詳介了。

(責任編輯:謝嘉洵)

- Windows PC上安裝PicoClaw最基礎實務 - 2026/03/03

- 跟上「龍蝦」潮了嗎?xClaw旋風現象觀察與後續 - 2026/02/26

- MakerPRO「2025台灣Edge AI開發者調查」初探 - 2026/02/11

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!