作者:創業小聚特約編輯 張育瑄

生成式AI掀起了一場科技革命,各大科技巨頭紛紛投入這場戰局。

除了近日OpenAI與Apple合作的消息,根據美國新創產業研究公司PitchBook的數據,今(2024)年NVIDIA也持續押注,參與了韓國新創Twelve Labs的A輪募資,投資約5,000萬美元(約新台幣16億元),這筆資金大大的幫助Twelve Labs進行後續的AI開發。

NVDIA參與Twelve Labs的A輪融資,投資約5,000萬美元,幫助他們進行後續的AI開發。(圖片來源:Nvidia官網)

Twelve Labs的AI專攻影片分析,只要說:「幫我找到狗狗打滾的片段」,AI就能馬上找到。看似簡單,其實背後需要理解影片中每個動作、聲音和情緒所代表的意思,這背後是Twelve Labs僅花2年就推出的AI模型。

超越MUM的客製化AI模型,Twelve Labs解決AI訓練影片痛點

MUM是一款多任務統一模型,能夠透過從使用者搜尋語句中判斷關鍵字的關聯性,搜尋出多個資料,並比對分析使用者透過文字、影像或是語音所詢問的問題,以更全面的形式判斷使用者的提問。

其實Google很早就推出了MUM AI模型,能夠了解人類語言在不同情況下有不同的意義,例如「住在這很方便」跟「我去方便一下」,兩句話的「方便」所代表的意義就不同。

Google的MUM聚焦於提供更精準的搜尋結果,而Twelve Labs則著重在影片的AI訓練。Twelve Labs將AI模型公開給客戶,讓他們能夠依據自己的需求調整模型並開發相關應用,以建立API的方式將AI應用到各自的領域。

Google MUM的AI搜尋系統與Twelve Labs都希望使用者能更快找到所需,但Twelve Labs將AI公開給需要的客戶並讓他們調整AI模型。(圖片來源:Google)

為何Twelve Labs選擇不同於Google的影片AI訓練這條路?

「我們最初的目的是能夠讓使用者就像用『ctrl+f』在網頁中能夠快速找到需要的詞語一樣,也能夠快速搜尋到需要的片段。」 Twelve Labs共同創辦人暨執行長Jae Lee說,許多訓練AI處理影片的公司的做法比較「土法煉鋼」:以手動標記每個影片片段,一個30秒的影片可能就有幾千萬個標記點,耗時又費力。

Twelve Labs採用了一種更有效的訓練方式。如果說傳統做法是將每一個片段同時標上動作、元素、聲音等標籤來訓練,Twelve Labs的作法則是水平分割式的:將整部影片的動作、聲音、圖像幾個元素分開訓練和分析。

例如,他們根據音頻的波形,訓練AI辨別人群聲音、鳥叫聲或是樹葉聲;也透過人物之間的關係互動和時間的變化,讓AI分辨人物的動作和關係。最後,他們將這些AI訓練的成果結合起來,打造出能夠理解影片內容的AI模型。

Twelve Labs AI功能3大特色,加速影片自動化開發

Twelve Labs的AI功能結合影片搜尋、語言生成、自動分類以及產出摘要,透過API的方式,以3大功能幫助簡化影片和內容工作者的後製流程。

- 影片搜尋和語言生成的結合:Twelve Labs的AI搜尋配合語言生成的方式,可以透過AI找到需要的片段。對於後置工作者來說,不需要看完整部影片,就可以找到需要編輯的片段,是相當省時的一個工具,像是在一部狗狗的影片中,可以告訴AI:「請幫我找到狗狗在草地上打滾的片段」或是在一部烹飪料理的影片中,詢問AI影片中會用到哪些食材或調味料,對於比較長的影片也可以請AI提供影片摘要,找出這部影片的人物和核心重點是什麼。

Twelve Labs的AI搜尋配合語言生成,可以透過AI找到需要的影片片段,像是詢問AI:請幫我找出偷溜進超市裡的狗狗。(圖片來源:Twelve Labs官網)

- 自動標記影片:YouTube某些影片也有片段標記,現在可以透過Twelve Labs的AI自動下標功能,找出影片中需要標記的片段。像是在一部創業家的影片中,AI會自動標記出「3:16~6:26是創業家故事」、「15:36~18:37是產品技術的解釋」,加快影片後製人員下標的速度,節省影片編輯的時間。

Google MUM的AI搜尋系統與Twelve Labs都希望使用者能更快找到所需,但Twelve Labs將AI公開給需要的客戶並讓他們調整AI模型。(圖片來源:Google)

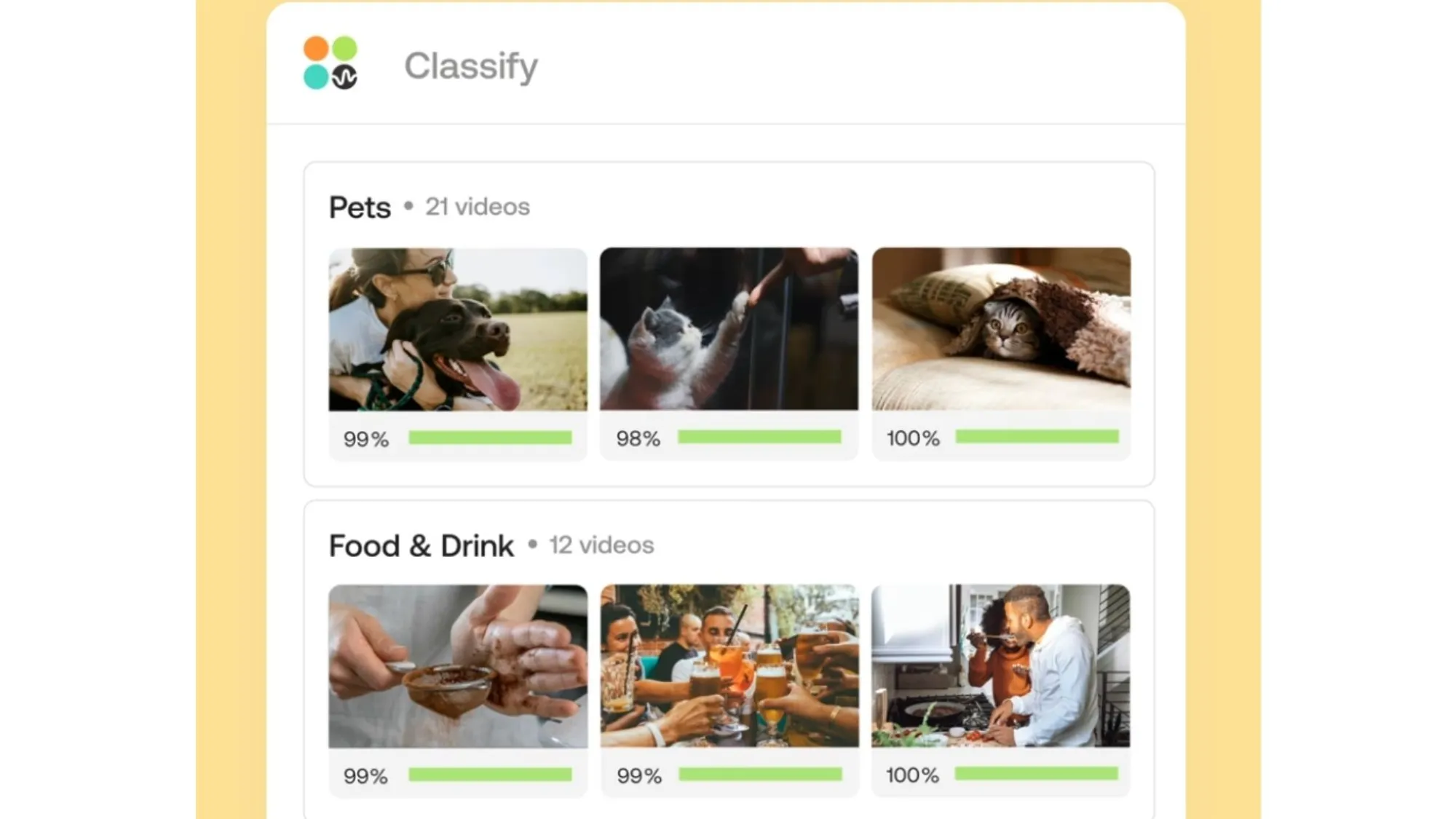

- 自動分類影片:最後的功能是針對有大量影片瀏覽需求的公司。透過Twelve Labs的AI分類功能,公司能夠從內部累積的影片作品或歷年影音報導中快速找到需要的類別,節省從海量影片中翻找和篩選的時間。

Twelve Labs的AI分類功能,可以快速找到需要的類別,節省從海量影片中篩選的時間。(圖片來源:Twelve Labs官網)

目前,Twelve Labs針對不同使用者提供不同的收費方案,包含90天的600分鐘免費版方案、個人開發者方案和企業方案,後兩者可依單日或單月計算,並針對圖片、聲音和影片標記等不同AI需求進行每分鐘的收費。

兩年半開發2個AI模型,影片AI模型獲投資青睞

Twelve Labs的AI功能已有約3萬多名的開發人員使用,並主要應用於內容創作者以及訓練生成式AI的各領域企業。

此外,團隊同時也與企業合作,像是在2022年幫助NVIDIA訓練A100和H100的GPU,達到影片分類、摘要和推薦等自動化影片的功能。今年,他們的AI也幫助線上影片編輯網站Blackbird,利用AI加快自動標註影片的效率,讓創作者和後製人員能夠更專注在影片內容,不用一直反覆確認影片後製細節,提高人員工作效率。

去(2023)年,Twelve Labs推出了第一個AI模型Pegasus,成功的將長、短影片和語言生成AI結合,從4秒到20分鐘的影片都能讓使用者用文字與AI對話,讓AI回答關於影片中的所有問題。今年3月,又推出第二個AI模型Marengo,經歷訓練6,000萬條影片以及5億多張圖像,可以回答更多影片、圖片和聲音的多模型AI。

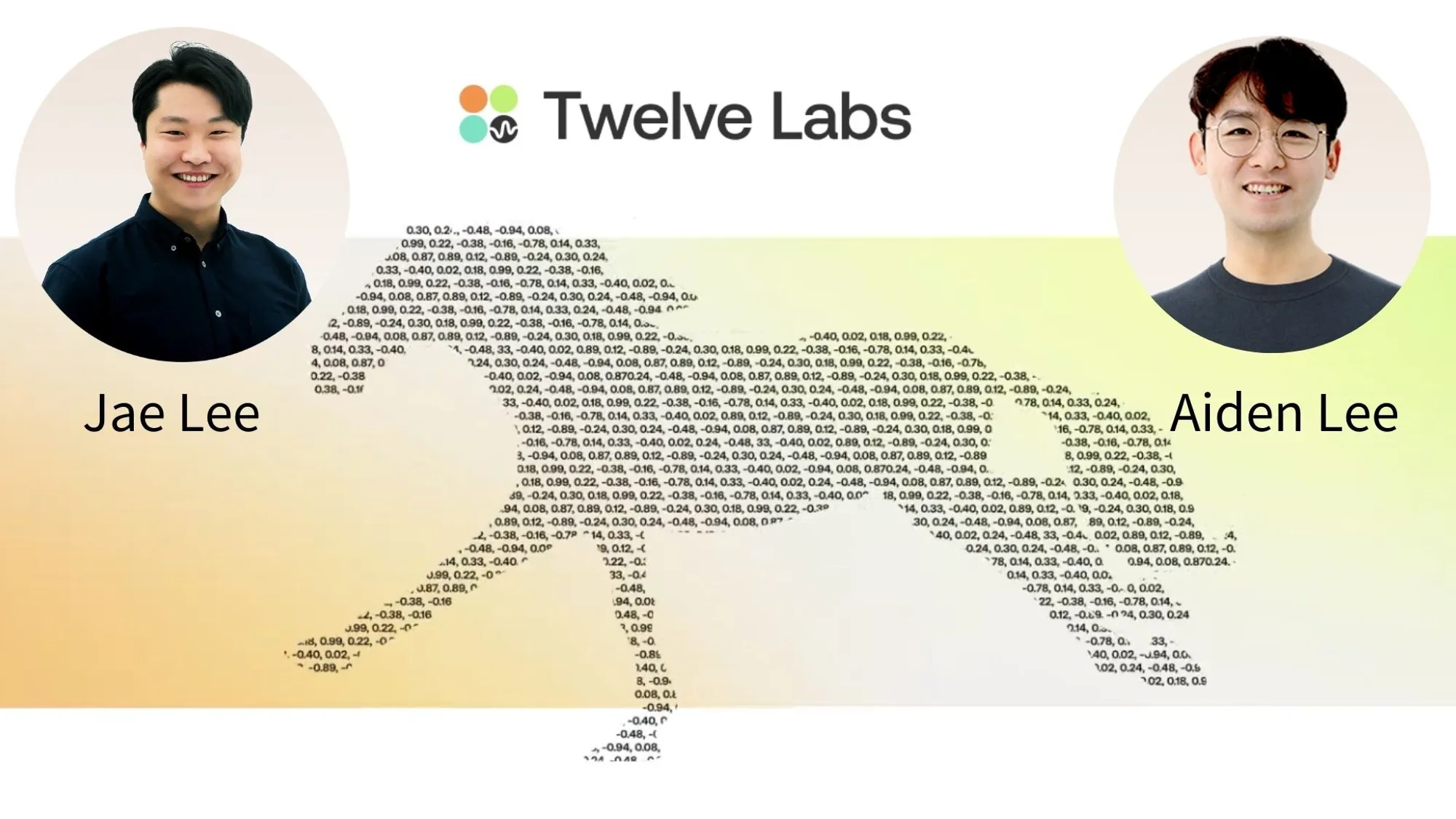

Twelve Labs創辦至今兩年多的時間,完成2個AI模型。

Jae Lee和Twelve Labs技術長Aiden Lee也從最初集合了5位核心成員成長成3、40人的團隊,並陸續從歐洲創投Index Ventures和加拿大投資公司Radical Ventures等募得了3,000萬美元(約新台幣9億元)的種子資金,更在近兩年與NVIDIA、Intel和Samsung建立了合作關係,後續也將利用NVIDIA此次投資的資金,持續研發、精進他們的AI模型。

Twelve Labs執行長兼共同創辦人Jae Lee(左)和技術長Aiden Lee(右)(圖片來源:Twelve Labs官網)

(本篇文章經同意轉載自創業小聚,原文連結;責任編輯:謝嘉洵。)

- 打擊失眠 思惟睡眠科技用「AI+腦波」展開睡眠革命 - 2026/01/23

- 以獨創壓電感測器讓機器人「有感覺」 宇霆科技完成千萬元Pre-A輪募資 - 2026/01/22

- 完成2億元Pre-A輪募資 佐翼科技「爬牆機器人」攻進半導體龍頭 - 2026/01/02

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!