當製造業面對缺工狀況,如何善用科技來因應人力缺口?AI技術有機會成為解答,本文將介紹一個運用AI技術開發生產線品管的解決方案。

身為一名工程師,Soloman Githu打算運用物件偵測演算法來快速檢查並分辨產品的好壞。他分別設定好的產品跟有各種缺失的產品組成的資料集,讓AI學會去辨識而且做出好壞的判定。

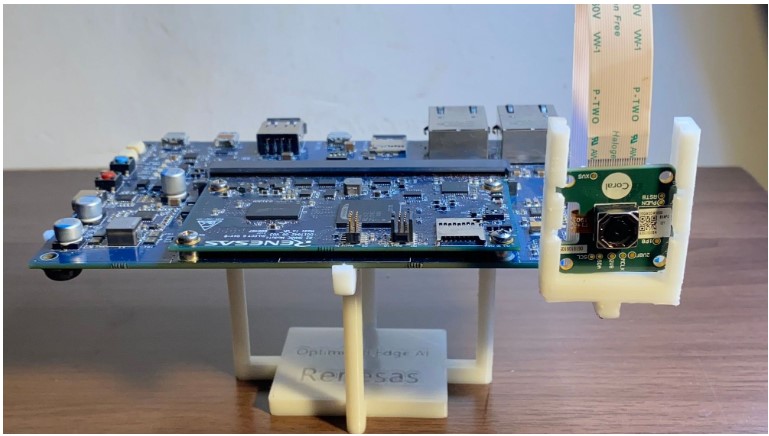

他選用了Edge Impluse Studio的Web介面來建置這個訓練資料集,並搭配專為電腦視覺與機器學習設計的Renesas RZ/V2L 開發板。RZ/V2L 配備 Arm Cortex-A55 雙核心處理器、Arm Cortex-M33 處理器、2 GB DDR4 SDRAM、AI 加速器晶片與許多用於連接外部設備的接口,可以運行經 Edge Impulse優化的物體檢測模型。此開發套件中還包括一個 Google Coral 鏡頭,為生產線品管作業提供視覺偵測。

Renesas RZV2L 開發板附上 Google Coral 鏡頭(Source)

標籤化+YOLOv5加速訓練

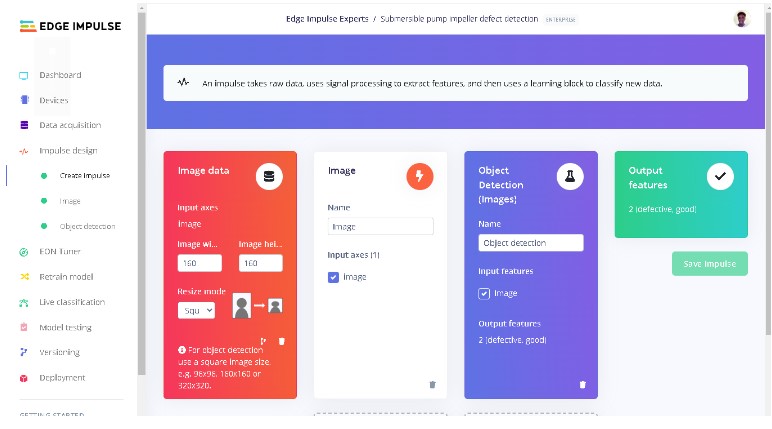

雖然這專案為了是各種不同類型的產品開發,Githu先以方便取得的抽水機葉片圖像取得了約1300張圖片-好的壞的都有,將圖片上傳到Edge Impluse Studio網站上專案去跑訓練流程。利用物件偵測功能與AI輔助選項去幫這些圖片標示好壞,將他們標籤化。然後縮小圖檔大小,然後用YOLOv5的偵測模型去加速。

AI協助標註資料集(Source)

增加訓練週期,提高辨識精確度

在建立模型的時候,Githu發現好的產品跟壞的產品區別常常很模糊,他覺得會發生這狀況應該是好的產品跟瑕疵的產品大多數特徵都很類似,除了一些『壞的很明顯』的才能很明顯的區分。『如果10次訓練週期不行,那就再來10次』,測試多次後,Githu發現100個訓練週期+0.001的學習率才解決了問題—高於96%的辨識精確度。除了原有的訓練資料集外,搭配事先分配的測試用資料集達到了98%的精準度,這結果其實蠻能讓製造業老闆們期待了。

Edge Impulse Studio的資料分析管道(Source)

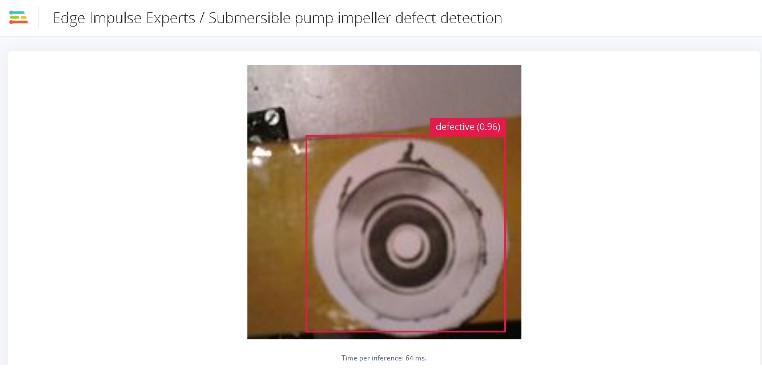

設定好RZ/V2L開發板,搭配安裝好的Linux版的Edge Impluse後,開始連結Edge Impluse Studio專案並且下載訓練後的模型,Edge Impluse還有一個可以快速測試的模型,從網路瀏覽器可以看到鏡頭偵測的標的物是好的還是壞的的顯示。

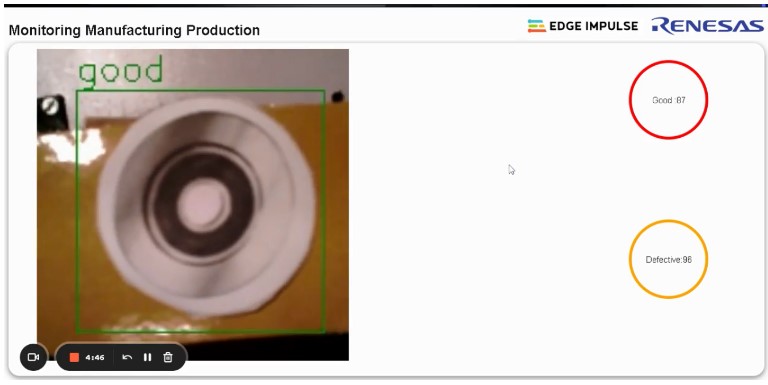

即時顯示預測的自訂 Web 應用程式(Source)

然後Githu開始了轟轟烈烈的測試,他製作了一個跑得很快的輸送帶,印了很多有好有壞的抽水機葉片圖,放在輸送帶上面跑,經過開發板本身的鏡頭拍攝後,透過Web的畫面,開始跑模擬生產線的產品品管流程,檢測的結果令人滿意。

除了偵測抽水機葉片外,透過複製的開源Edge Impluse Studio的專案資料,然後上傳自己的相關數據,你想測什麼就測什麼。在其專案文章還有很多說明,作者Githu還提供了自己的Web應用程式的開源代碼,有興趣的製造業者可以參考及運用喔。

(責任編輯:Peter Wang)

參考連結:

Elevating Quality Standards with AI(Edge Impulse Blog)

- TI與NVIDIA攜手加速新一代實體AI發展 - 2026/03/10

- 更智慧的5G通往6G順暢演進:英特爾的AI就緒網路願景 - 2026/03/06

- 當手術機器人遇上AI 精準微創利器再進化! - 2026/03/06

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!