作者:許哲豪 Jack

本篇文章摘要了外國網友比較三個 AI 開發版的文章,內容則是樹莓派加 Intel 神經計算棒、 NVIDIA Jetson Nano 及 Google Coral 三者的實驗數據比較。

最近 AI 開發板掀起一陣大混戰,每個人都說自家的廠商算力有多高, CP 值沒得比,但到底實情如何,只能各說各話。有位網友 Alasdair Allan 發表了一篇比較文,把目前最火的三個方案樹莓派加 Intel 神經計算棒、 NVIDIA Jetson Nano 及 Google Coral 做了完整實驗數據比較,結果各打五十大板,沒有一家能到達號稱的最高效率,真不知是廠商在特定(優化)條件下執行還是作者的測試方法不公平,又或是這些廠商有什麼隱藏祕技未公開。

這篇文章非常長,測試方法非常完整,在這裡簡單幫大家摘要一下,因此接下來的內容、圖片都出自下方連結,有興趣的朋友請直接參考原文

Benchmarking Edge ComputingComparing Google, Intel, and NVIDIA accelerator hardware

這篇文章最可愛的地方,就是文後最後一句話「 This post is sponsored by Coral from Google 」,作者拿了 Google 的贊助,雖然結論是 Google Coral 比較優,但文中仍保留很多意見,且意見皆誠實陳述,沒有一面倒幫 Google 多講好話,看來 Google 還是滿大方的。

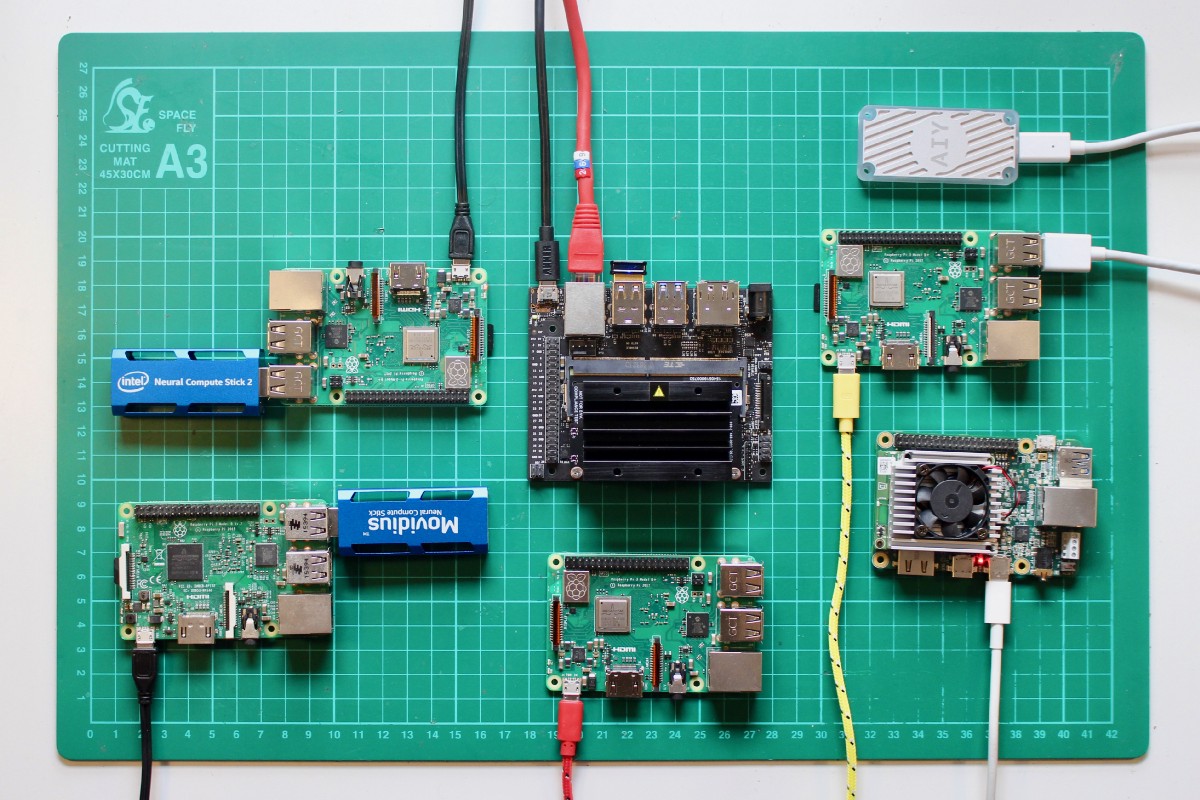

七種測試平台:

- 樹莓派 3B 加 Movidius(Intel)神經計算棒一代

- 樹莓派 3B + 加英特爾神經計算棒二代

- NVIDIA Jetson Nano

- 樹莓派 3B +

- Google Coral USB 加速器

- Google Coral 開發板

- 蘋果 MacBookPro(Intel Core i7)

七種測試平台(圖片來源:Alasdair Allan)

二種模型:

- MobileNet V1 SSD

- MobileNet V2 SSD

測試條件:

在微軟 COCO 資料集,將圖縮到 300×300 後進行推論 1000 次後再取執行時間平均值。

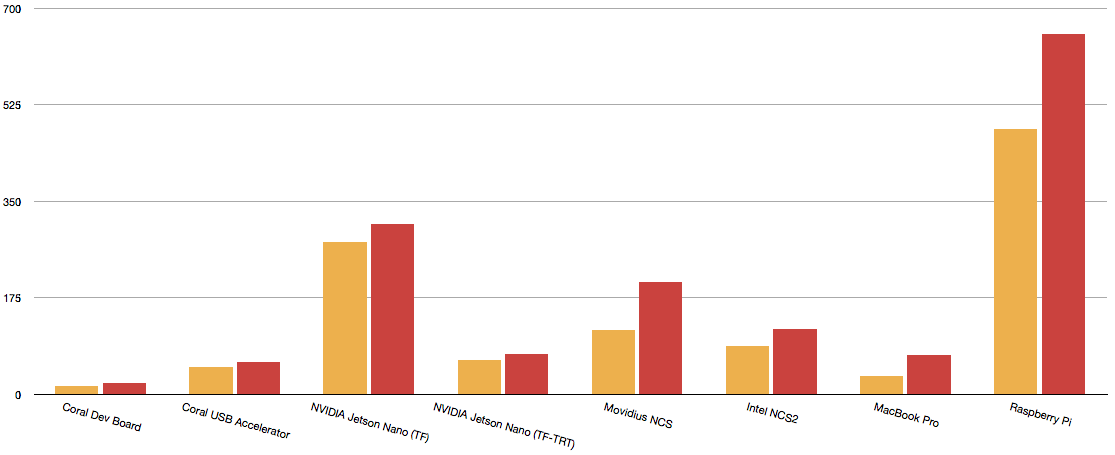

黃色:MobileNet V1 SSD;紅色:MobileNet V2 SSD(圖片來源:Alasdair Allan)

使用框架:

樹莓派:TensorFlow

Google Coral : TensorFlow 、 TensorFlow Lite

Intel(Movidius)NCS : TensorFlow 、 OpenVino

NVIDIA Jetson Nano : TensorFlow 、 TensorRT

USB 介面速度會明顯影響執行效率─樹莓派加神經棒、 Google Coral USB2.0 、 NVIDIA Jetsno Nano USB3.0 。

USB 型加速器(圖片來源:Alasdair Allan)

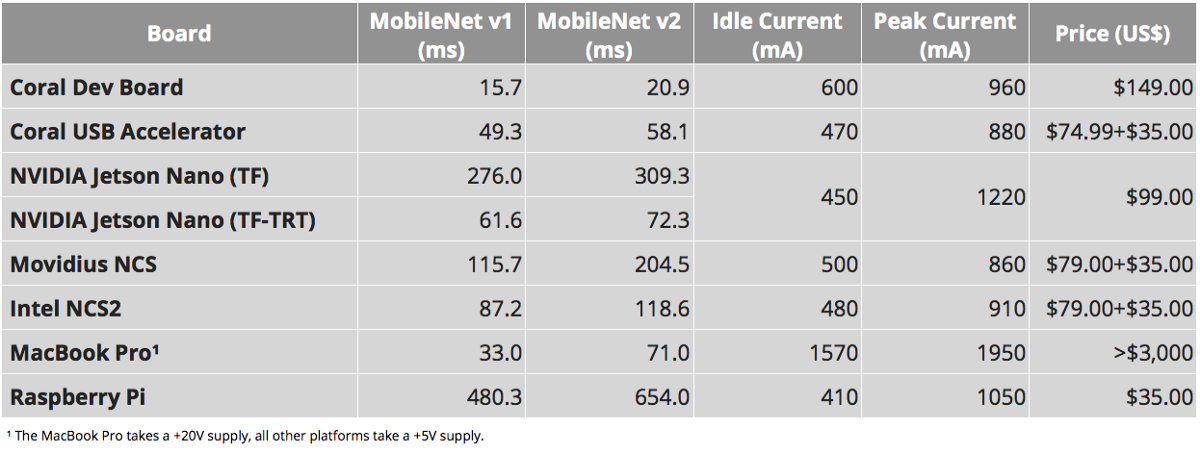

能量消耗:在無鍵盤、滑鼠、顯示下測量空載及滿載峰值電流

MobileNet v1 SSD 0.75 和 MobileNet v2 SSD 的基準測試結果以毫秒為單位,均使用COCO數據集進行測試,輸入大小為300×300(圖片來源:Alasdair Allan)

在推理期間測量Coral Dev Board的電流(圖片來源:Alasdair Allan)

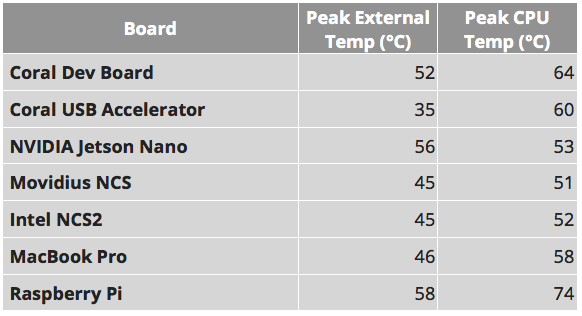

執行五千次推論後溫度變化

在推理期間峰值外部和峰值CPU溫度,單位為°C(圖片來源:Alasdair Allan)

小結

更多完整測試步驟及方式請參考原文,原作者詳細記錄了測試過程,並提供檔案讓有興趣者可以下載,一起動手試試看。

(本文轉載自歐尼克斯實境互動工作室、原文連結;責任編輯:楊子嫻)

- Arduino UNO Q教學案例整理 - 2026/03/09

- 有了Intel AI Playground 不寫程式也能輕鬆玩生成式AI - 2025/09/02

- 【開發資源】TinyML MCU 等級開源推論引擎 - 2025/06/09

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!