PyTorch Lightning 是建立在 PyTorch 之上的輕量級封裝(wrapper framework),由 William Falcon 於 2019 年推出,目標是讓研究人員與工程師在進行深度學習訓練時,能將「模型邏輯」與「訓練細節」分離。

在原生 PyTorch 中,訓練流程往往包含大量重複的樣板程式碼,例如:

- GPU/CPU 切換與裝置管理

- 批次訓練與梯度更新

- 檢查點儲存、early stopping

- 多 GPU 或 TPU 的分散訓練設定

這些細節若由研究者自行處理,容易造成程式雜亂、不易維護。PyTorch Lightning 的出現,就是為了 讓你只專注在「模型該怎麼學」,而不是「如何訓練」。

「少寫樣板(boilerplate),多專注模型邏輯。」

—— PyTorch Lightning 的核心哲學

簡言之,它是 PyTorch 的結構化訓練框架(structured training framework),幫你管理實驗工程的部分,讓研究更簡潔可重現。

特色與優勢:乾淨、可擴充、具生產力的 PyTorch

1. 乾淨的程式架構(Clean Code Design)

Lightning 將模型、資料、訓練、測試、記錄等模組化。典型的 LightningModule 結構如下:

class LitModel(pl.LightningModule):

def __init__(self):

super().__init__()

self.model = Net()

self.loss = nn.CrossEntropyLoss()

def training_step(self, batch, batch_idx):

x, y = batch

y_hat = self.model(x)

loss = self.loss(y_hat, y)

self.log("train_loss", loss)

return loss

def configure_optimizers(self):

return torch.optim.Adam(self.parameters(), lr=1e-3)

接著只需:

trainer = pl.Trainer(max_epochs=10)

trainer.fit(model, train_loader)

無須再寫訓練迴圈、梯度清零、GPU 分配等樣板代碼,專注於模型本身。

2. 多設備與分散式訓練變得簡單

Lightning 支援多 GPU、TPU、DeepSpeed、FSDP、以及最近的 Apple Silicon,

只需在 Trainer 中設定:

Trainer(accelerator="gpu", devices=4, strategy="ddp")

即可輕鬆切換到分散式訓練,不需修改模型邏輯。

這讓研究從單機快速擴展到集群訓練變得無痛。

3. 強大的 Callback 與 Logger 系統

Lightning 內建多種訓練監控機制,如:

- EarlyStopping

- ModelCheckpoint

- LearningRateMonitor

- TensorBoard / WandB / MLflow 整合

透過簡潔的 callback API,即可自動記錄指標、儲存最佳權重,不必手動處理檔案或狀態管理。

4. 可重現與易維護的實驗流程

Lightning 的設計鼓勵 deterministic training 與明確的實驗結構:

模型、資料、Trainer、Logger 清楚分離,使得團隊能輕鬆重現實驗結果,也更適合長期專案維護與版本控制。

5. 與 PyTorch 完全相容

Lightning 並非「取代」PyTorch,而是「增強」它。

你可以在任何階段回到原生 PyTorch 操作,例如直接呼叫:

outputs = model.forward(inputs)

這種「透明封裝」的特性讓它成為研究界和產業界的折衷選擇。

適合的使用背景:從研究到產品化的橋樑

PyTorch Lightning 適合的場景包括:

- 學術研究者 / 研究生:

想快速試驗新架構、不想被訓練細節綁住。 - AI 工程師 / 開發者:

想維護乾淨可重現的代碼庫,或需要多 GPU 訓練。 - 企業研發團隊:

想要團隊協作、可版本化、容易部署的訓練框架。

與 TensorFlow 的 Keras 相比,Lightning 更貼近 PyTorch 的原始靈活性,

同時具備高階封裝的生產力與清晰結構。

入門背景建議:

- 已熟悉 PyTorch 張量操作與模型建構。

- 理解基本的 訓練流程(forward/backward/optimizer)。

若完全是新手,建議先閱讀 PyTorch 官方教程,再進入 Lightning。

學習資源推薦:

| 類型 | 資源名稱 | 說明 |

|---|---|---|

| 官方文件 | https://lightning.ai/docs/pytorch/stable/ | 最完整的官方指引與 API 說明 |

| 教學課程 | Lightning Tutorials on Colab | 官方互動式教學,附 GPU 環境 |

| 社群論壇 | Lightning Community | 研究者與開發者交流平台 |

| YouTube | William Falcon’s Channel | Lightning 創辦人講解框架哲學與應用 |

發展現況與延伸生態

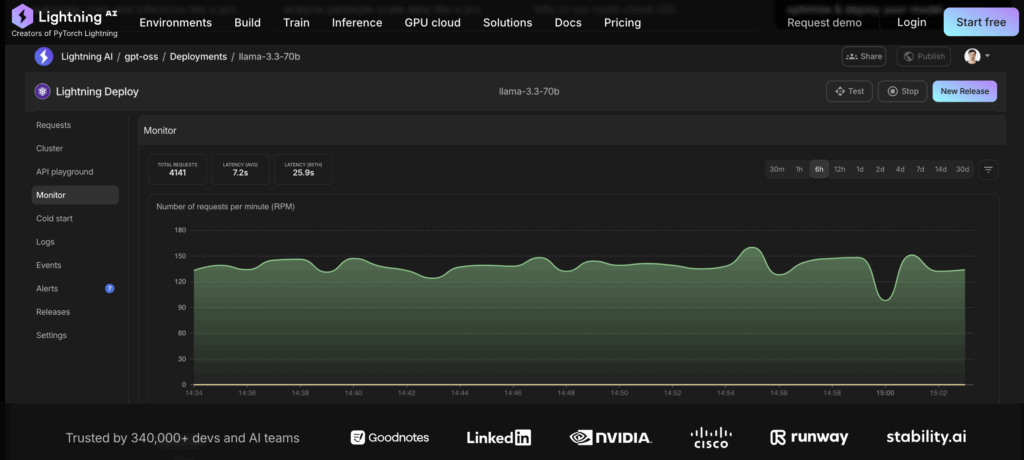

PyTorch Lightning 已演進為 Lightning AI 生態系的一部分,除核心訓練框架外,還包括:

- Lightning Fabric:靈活的分散式訓練後端

- Pytorch Lightning Training Studio App:用於快速部署 AI 產品與雲端應用

這代表 Lightning 不僅是「研究用訓練框架」,更逐步成為 從模型訓練到產品落地的全流程平台。

結語

PyTorch Lightning 的出現,代表著深度學習工程實踐的一次質變。它並未重新發明 PyTorch,而是讓 PyTorch 更乾淨、更高效、更具生產力。

對研究者而言,它釋放了專注創新的時間;對工程師而言,它提供了可重現與可擴充的結構;而對整個 AI 團隊,它則是通往「研究到產品」的橋樑。

(責任編輯:歐敏銓)

》延伸閱讀:

Lightning-AI/pytorch-lightning(Github)

Pytorch-lightning Alternatives

- 結合開源OpenClaw 耐能拓展輕量化AI應用新型態 - 2026/03/05

- 觸發「直覺」上手:AI如何賦予仿生手靈巧感受 - 2026/03/05

- AI資料中心擴充關鍵:CPO技術與市場概述 - 2026/03/04

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!