作者:歐敏銓

密西根大學研究團隊推出的 ML.ENERGY Leaderboard 能效觀測排行榜,透過名為 Zeus 的開源測量工具,能精準追蹤 CPU、GPU 在 LLM 推論過程中的能耗,並以公開數據的形式排名,讓外界第一次能清楚看見「AI 回應背後的電表數字」。

近年來,生成式人工智慧(Generative AI, GenAI)的爆炸式發展徹底改變了我們與資訊互動的方式。大型語言模型(Large Language Models, LLM)驅動的聊天機器人不再只是科幻電影裡的場景,而是實實在在進入了我們的日常生活。無論是透過 ChatGPT 來輔助寫作,還是透過 Google Gemini 搜尋與學習,甚至是企業客服自動回覆,這些模型正逐步成為人類的「第二語言」。

然而,當人們愈發沉浸於與 AI 的自然對話時,卻鮮少有人意識到,每一則即時生成的回應,背後都伴隨著龐大的電力消耗。這些「看不見的能源」,正逐漸累積成全球環境的一項新挑戰。本文將從最新的研究數據出發,帶領讀者揭開 LLM 聊天機器人能耗的真相,以及這背後牽動的技術與環境議題。

一次對話的耗電量,真的很高嗎?

許多人或許會直覺認為,一個聊天機器人輸出的文字,不過是伺服器上幾行運算的結果,能耗應該微不足道。但實際情況卻更複雜。

密西根大學等研究團隊推出的 ML.ENERGY Leaderboard 提供了一個全新的能效觀測角度。這個排行榜透過名為 Zeus 的開源測量工具,能精準追蹤 CPU、GPU 在 LLM 推論過程中的能耗,並以公開數據的形式排名,讓外界第一次能清楚看見「AI 回應背後的電表數字」。

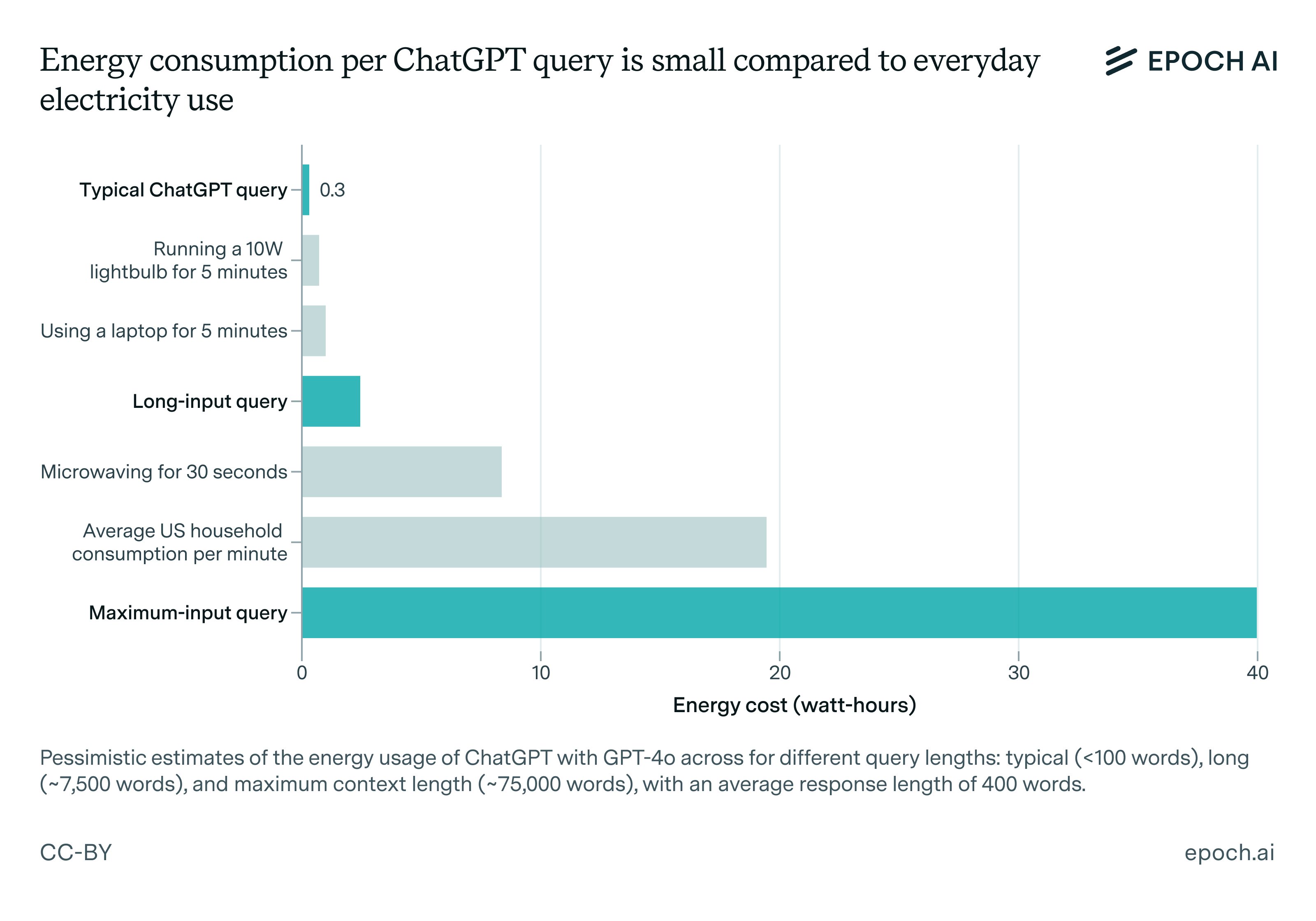

以目前市面最受矚目的 ChatGPT(基於 GPT-4o 模型)為例,根據 Epoch AI 的分析,一次標準回應大約消耗 0.3 瓦時(Wh)。這個數字相當於一顆 LED 燈泡亮幾分鐘,或是一台筆電短暫運作的耗能。這與早期廣為流傳的「單次查詢需耗 3 瓦時」形成強烈對比,顯示隨著硬體效能與模型架構優化,能效確實獲得了顯著改善。

另一方面,Google 在其公開的技術報告中指出,Gemini 模型的「文字查詢中位數能耗」約為 0.24 瓦時,幾乎等同於微波爐啟動一秒鐘的耗電。Google 進一步拆解指出,這 0.24 瓦時中約有六成來自 AI 加速器本身,其餘則分別來自主機系統、閒置備援與資料中心基礎設施。

然而,這些數據多半來自企業公開或第三方推估,並未經過獨立的標準化測試。這正是 ML.ENERGY Leaderboard 的價值所在。由密西根大學團隊推出的 Zeus 測量工具,能在可控環境下,精確追蹤 GPU 與 CPU 在推論過程中的能耗,並將多款開源 LLM 的標準化測試結果公開比較。例如,Leaderboard 上顯示,像 LLaMA-7B 在標準推論任務中平均約需 0.12 瓦時,而更大型的 LLaMA-13B 則約為 0.22 瓦時,這些實測數據提供了學術界與開發者一個具體參照點。

| 模型 | 單次回覆耗能 (Wh) | 來源 | 條件說明 |

| GPT-4o | 約 0.3 Wh | 外部研究報告 | 標準長度回應,測試細節未公開 |

| Gemini | 約 0.24 Wh | Google 內部測試 | 單次查詢耗電中位數 |

| LLaMA-2-7B | 約 0.12 Wh | ML.ENERGY Leaderboard | 推論 batch size=1,序列長度=512 |

| Falcon-40B | 約 0.47 Wh | ML.ENERGY Leaderboard | 推論 batch size=1,序列長度=512 |

換句話說,雖然我們目前對 GPT-4o 與 Gemini 這類商用模型的能耗仍只能依賴外部估算,但有了 ML.ENERGY 這樣的科學化平台,至少能確立「能耗量測標準」與「跨模型比較基準」,逐步推動產業在 AI 永續發展上的透明化。

訓練與推論:AI 背後的雙重能耗

從上述的LLM Chat能耗數字來看,似乎不大,但問題是,全球每天有數億甚至上十億次的 AI 對話在發生。當這些「小小能耗」疊加在一起,總量便足以影響整個資料中心的能源結構,並推升全球的用電需求。而要理解 LLM 的能源結構,必須從它的兩個核心過程切入:訓練(Training) 與 推論(Inference)。

訓練,是能耗的巨獸。

打造一個 200B參數的 LLM,往往需要數週乃至數月的 GPU 集群計算。美國多間大學的一個研究估算,在 AWS 這樣的雲端平台上訓練一個這等規模的模型,能耗可高達 11.9 兆瓦時(GWh),這個數字相當於超過一千戶美國家庭一整年的用電量。這是 AI 產業裡最為龐大且一次性的能源投入,也解釋了為什麼每一次新模型的誕生,都被形容為「能耗黑洞」。

推論,則是能耗的日常。

如果說訓練是一次巨大的爆發,那麼推論就是細水長流的消耗。每一次使用者輸入問題、獲得回答,都是推論的結果。雖然單次耗能遠低於訓練,但由於 ChatGPT 每日要處理超過十億次請求,累計起來的總能耗依舊驚人,並在資料中心總體電力需求中占去相當份額。

更重要的是,推論的耗能會隨著輸入與回覆的複雜度而攀升。簡單的問候或查詢可能只需極少運算,但若涉及長篇生成、邏輯推理,或結合文字、語音、影像的多模態處理,能源消耗則會直線上升。這意味著使用者的「一句話」,背後的耗電差距可能呈數倍甚至數十倍。

Zeus 與 ML.ENERGY:AI 能效的體檢表

在這場 AI 能耗辯論裡,Zeus 的出現可說是一次關鍵的突破。這套由密西根大學團隊開發的開源工具,能同步監測 GPU 與 CPU 的運算與耗電狀況,並適用於包括 NVIDIA、AMD 以及 Apple Silicon 在內的多種硬體平台。這不僅讓能耗測試更透明,也使研究者能進行跨平台比較。

透過 Zeus 所驅動的 ML.ENERGY Leaderboard,外界能清楚看見不同模型的平均能效差異。例如,同樣是開源 LLM,有些模型在標準測試下耗電量顯著低於同級對手,這讓開發者能更理性地選擇,並在部署時兼顧效能與環保考量。

更進一步來看,這類平台的公開化,也在推動整個產業對「綠色 AI」的共識。當能效不再是隱藏的成本,而成為公開排名的一部分,企業勢必會更重視優化,避免因高能耗而被貼上「不環保」的標籤。

當資料中心變成能源巨獸

大型語言模型的能耗並不是孤立存在,而是與全球資料中心的能源結構緊密相連。根據美國能源部(DOE)2023年報告指出,美國資料中心的用電約佔全國總電力消耗的4.4%,該報告還預測伴隨AI快速普及,到2030年前資料中心電力需求會大幅增加,甚至在2028年電力需求將達到佔美國總用電的6.7%-12%區間,整體用電量有望增長2-3倍以上。

另一份報告則預測網路的能耗將從2022年的800 TWH上升至2030年的2,000 TWH,到2050年將超過4,000 TWH(參考下圖)。主要驅動因素包括人工智慧、區塊鏈、流量成長以及效率提升帶來的能耗。

這樣的趨勢不僅讓產業界警惕,也引來環保界的強烈關注。因為資料中心多集中於高耗能的伺服器運算與冷卻需求,碳排放壓力也隨之加重。若沒有相應的節能措施,AI 的繁榮將可能以環境代價為隱形標籤。

因此,企業與研究機構正積極探索解方。從硬體端來看,更高效能的 GPU、專用 AI 加速器(如 ASIC、FPGA)的開發,正試圖在同等運算量下降低耗能;從軟體端而言,模型壓縮、知識蒸餾、動態推論調度等方法,則致力於減少不必要的計算;基礎設施方面,則興起了「再生能源資料中心」的風潮,例如將伺服器設置於靠近水力或風能的區域,藉此降低碳足跡。

節能新技術的未來想像

面對這股龐大的能源挑戰,AI 社群並非束手無策。近年來,一系列的新技術正逐步浮現:

首先是 模型結構的革新。更輕量化的 LLM,或是將大型模型拆分為分布式小模型,能有效降低推論所需的計算負荷。這樣的設計不僅能提升能效,也有助於讓模型在行動裝置或邊緣設備上運行。

其次是 動態計算調度。這是一種根據輸入複雜度,靈活調整計算資源的技術。若問題簡單,就不必動用完整的模型層級,從而避免過度耗能。

再者是 專用硬體加速。ASIC、FPGA 等定制化晶片,能針對 LLM 的運算特徵進行優化,讓同樣的運算在更低功耗下完成。這也是 Google TPU 與各大晶片公司積極投入的方向。

最後,像 ML.ENERGY 這樣的 開源能效評比平台,正逐漸成為產業透明化的推手。當能耗數據被公開比較,企業將更有動力投入節能技術,推動形成「能效就是競爭力」的新共識。

結語

大型語言模型聊天機器人正在以前所未有的速度改變世界。它們為人類帶來了創作的自由、教育的普及與效率的提升,但同時也打開了一個新的環境難題。

單次查詢的能耗看似微小,卻在全球巨量使用下化為龐大的能源洪流。訓練階段的高能耗更是不容忽視。正因如此,AI 的未來不能只是追求「更聰明」,也必須追求「更節能」。

透過 Zeus 工具與 ML.ENERGY 等平台,社會得以清楚看見 AI 能效的真實樣貌;透過硬體革新、軟體優化與再生能源應用,產業也正在邁向更加永續的方向。

》延伸閱讀:

How much energy does ChatGPT use?(Epoch.ai)

How much energy does Google’s AI use? We did the math(Google Cloud)

Reducing Energy Bloat in Large Model Training(論文)

看見AI爆發下的能源與生態危機!(MakerPRO)

- 讓AI成為雨林金礦盜採防線:Amazon Mining Watch計畫介紹 - 2026/02/23

- 當仿生靈巧手遇見Physical AI:四間頂尖開發單位介紹 - 2026/02/13

- 戰略決策AI進化:Palantir AIP如何導入LLM重塑現代戰場指令 - 2026/02/11

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!