看完使用Colab雲端 將手上資料集訓練成YOLOv5模型,覺得YOLOv5模型還是不夠快嗎??講師洪銘恩將帶大家了解如何藉由TensorRT,來加速YOLOv5模型的推論速度,特別強調YOLOv5轉換、如何操作及其卓越加速效果。

學習目標

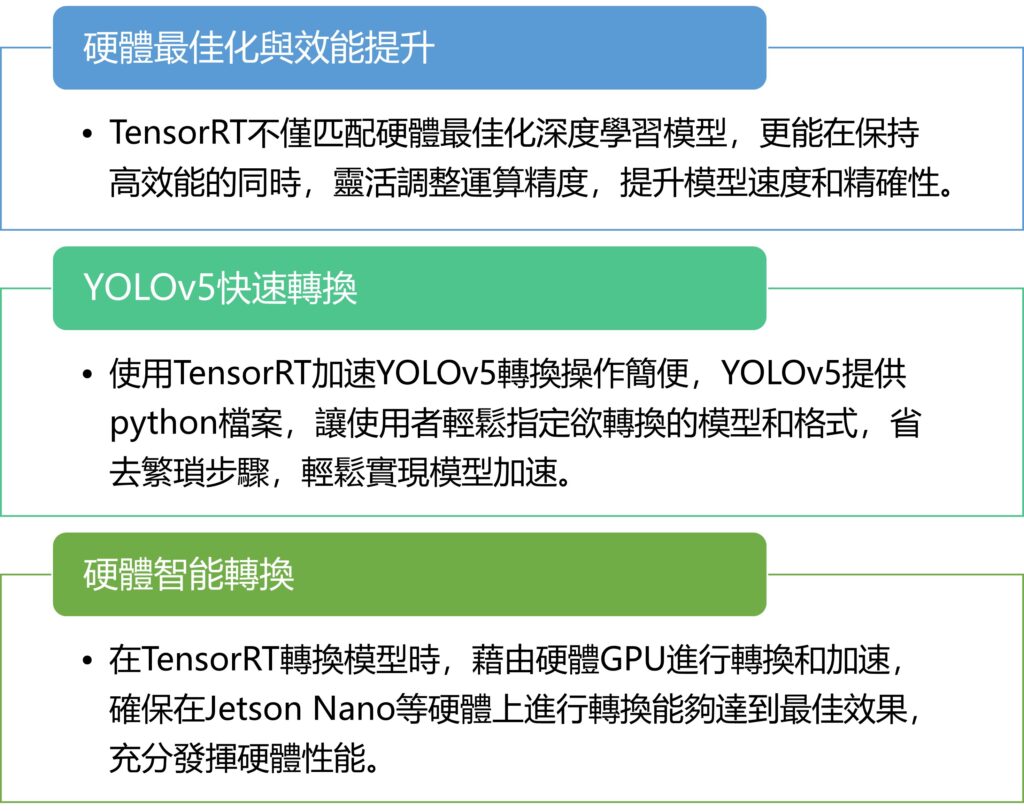

TensorRT,作為NVIDIA Jetson系列深度學習模型的加速工具,不僅匹配硬體最佳化模型,還提高效能。它靈活適應運算精度,如FP32到FP16、INT8,同時修補模型結構以提高速度和精確性。本影片中深入淺出的介紹TensorRT的使用,特別聚焦YOLOv5轉換,解析操作簡便性及加速效果,以下為章節重點:

1.何為TensorRT

TensorRT是NVIDIA Jetson系列產品的一個工具,用於加速深度學習模型。它能夠將模型最佳化以匹配硬體,並在降低運算精度的同時提高效能。TensorRT不僅可以調整運算精度(如從FP32到FP16、INT8),還能修補模型結構,去除不必要的部分,以提高運行速度和準確性。

2.使用TensorRT加速 – YOLOv5快速轉換

使用TensorRT加速YOLOv5的轉換相對簡單,因為YOLOv5提供了一個python檔案,可用於自由轉換模型。通過該檔案,使用者可以指定欲轉換的模型和轉換格式,使整個過程更為便利。這消除了一些繁瑣的步驟,讓使用者能夠輕鬆地達到模型加速的目的。

3.使用TensorRT加速 – 事前作業

在使用TensorRT之前,需要進行一些事前作業。首先,安裝ONNX套件,因為TensorRT轉換過程需要將PyTorch模型轉換成ONNX格式。此外,必須新增一個包含模型類別數量和類別名稱的Label檔案,以便轉換後的模型能正確輸出類別信息。這些準備工作為後續使用TensorRT提供了必要的基礎。

4.使用TensorRT加速 – 將模型轉換成TensorRT格式

在這一步驟,要注意使用TensorRT轉換模型時,它會根據硬體的GPU進行轉換和加速。因此,在Jetson Nano等硬體上進行此轉換是必須的,而在個人電腦上執行此優化將只影響電腦的GPU,而非Jetson Nano上的GPU。

5.使用TensorRT加速 – 執行轉換後的模型

完成模型轉換後,可以通過選擇不同的選項來進一步調整,例如指定輸入圖片大小、選擇要使用的裝置(如CUDA)、調整精度(FP16)等。最後,輸入這些參數後,Jetson Nano 將開始優化轉換模型。

6.YOLOv7模型如何用TensorRT加速

如果想要在Jetson Nano上使用YOLOv7模型進行加速,可以參考YOLOv7的GitHub,將其資源clone下來。這邊的重點是YOLOv7的最小模型實際上是指tiny版本,這可能是在Jetson Nano上使用的更合適的選擇。在模型的使用方面,需注意模型轉換後的檔案(例如best.engine)、標籤檔案(labels.yaml)的輸入以及其他相關參數。

小結

TensorRT的操作不僅簡單,而且極大地提升了YOLOv5模型的轉換效能。事前作業中的ONNX套件安裝和Label檔案新增為後續作業打下堅實基礎。值得注意的是,在進行TensorRT轉換時,應選擇硬體上進行,以確保最佳轉換和加速效果。透過調整輸入參數,Jetson Nano能夠迅速開始模型的最佳化轉換。

延伸學習影片

(責任編輯:Peter Wang)

- 邊緣覺醒:Edge AI如何實現無人機SLAM即時建圖 - 2026/02/23

- Ceva Wi-Fi 6和藍牙IP支援Renesas物聯網/智慧家庭組合式MCU - 2026/02/13

- 【Podcast】機器人的巧手革命:靈巧手如何推動實體 AI 崛起 - 2026/02/12

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!