作者:許哲豪 Jack

前不久因為有感台灣推動人工智慧(以下簡稱 AI)落地方向不明,剛好看到工業局及資策會正在推動的 AIGO 活動「業界出題、人才解題」,於是隨手整理了廠商出的 76 個實際需求問題寫了一篇「從AIGO業界出題內容看台灣AI如何落地」,收到不少迴響。

最近 AIGO 又開始第二梯次出題,出了整整 100 題,於是激起我再寫第二篇的動力(依然不是業配文),想就個人觀點和大家談談一般人對 AI 的迷思、如何確認導入 AI 成效及未來該如何出題才能得到快速有效的解題方案。

AIGO 官網畫面(圖片來源:AIGO官網)

出題分析

目前 AIGO 官網上只將出題分為三大類問題「電腦視覺」、「自然語言」及「數據分析」。經個人逐一閱讀 100 題說明後,再依主觀看法重新摘要、細分技術子項及應用領域,「電腦視覺」部份佔 46% (人臉辨識:9,影像分類:7,物件偵測:6,文字辨識:6,語義分割:6,光學檢測:3,行為分析:3,立體視覺:2,圖像標題:1,指紋辨識:1,影像合成:1,影像迴歸:1,共 46 題),「自然語言」部份佔 19%(語音客服:11,語義理解:6,語音合成:1,語言分類:1,共 19 題),「數據分析」部份佔 35%(時序預測:18,生產優化:6,推薦系統:4,資料探勘:3,資訊安全:2,迴歸分析:1,資料分類:1,共 35 題),最後統計結果得到如下圖所示。

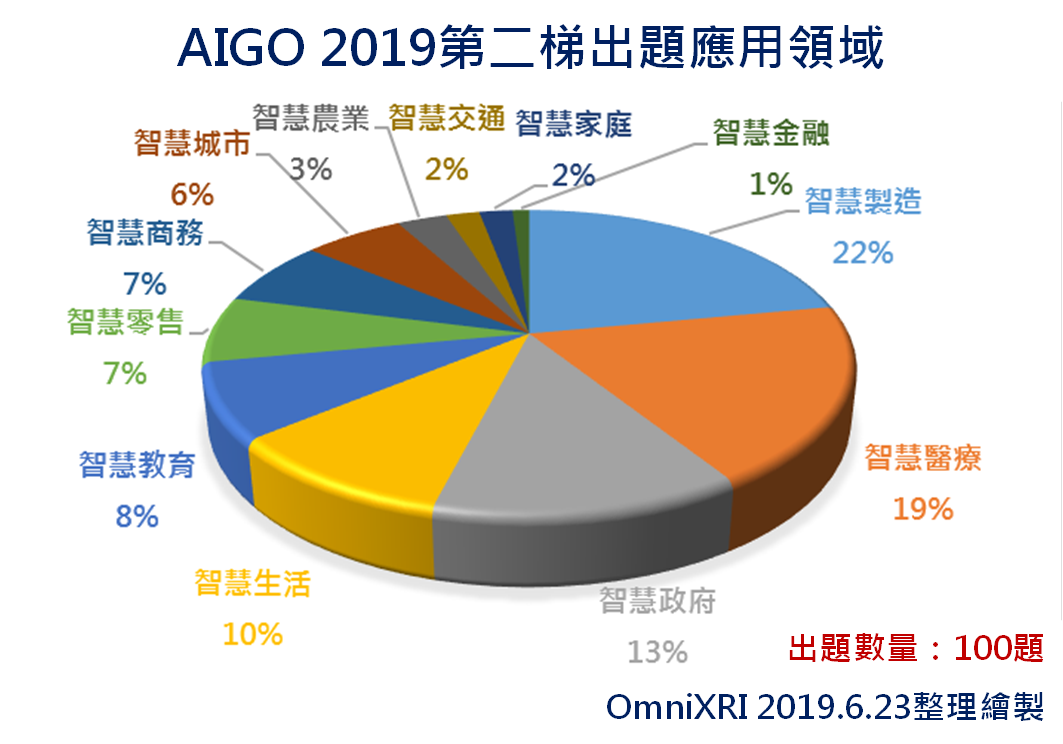

另外 AIGO 官網是以出題廠商領域來分類出題類型,但出題內容可能和本業不一定完全相關,因此個人重新自行以應用領域分類,包括智慧製造(22%)、智慧醫療(19%)、智慧政府(13%)、智慧生活(10%)、智慧教育(8%)、智慧零售(7%)、智慧商務(7%)、智慧城市(6%)、智慧農業(3%)、智慧交通(2%)、智慧家庭(2%)、智慧金融(1%),如下圖所示。另外此次由於 AIGO 加入高雄地區及政府單位徵題,所以有 41 題(所有領域)是來自高雄地區,而公部門(全台)則出了 23 題。

這樣的分類或許不夠精準(部份有複合問題)或許還有些因個人本職學能不足,在閱讀說明時產生誤解,分得不好或不對的地方再請大家見諒多多包涵。更完整的出題說明請詳見 AIGO 官網「解題競賽108年度第二梯次」。

大眾對 AI 的迷思

個人在閱讀大量學術論文、新聞報導並參加許多研討會及和業界人士閑聊後發現,目前大多數人仍對人工智慧(AI)存有大量幻想及恐懼,在此提供一些個人觀點希望能破除一些迷思,或許能更有助未來廠商導入 AI 時不會有過高的期待,且能更容易找到符合自身需求的解決團隊及方案。不過受限個人能力有限,如有說明不清楚或者有爭議內容,歡迎留言討論。以下個人就從 AI 定義、資料集、算法、算力及成效指標等範圍來分別說明 AI 常見的八項迷思。

迷思一:AI 無所不能,什麼工作都能交給 AI

「人工智慧」一詞從 1950 年代就被提出,其間歷經幾次大起大落,從最早的「符號邏輯」、「專家系統」、「機器學習」、「資料採礦(大數據)」到近兩年興起的「深度學習」及「知識圖譜」。對於這些技術的差異和應用範圍大多數人可能都難以區分,甚至更誇張地認為只要有用到「電腦視覺」、「語音辨識」、「數據分析」代替人類工作的項目全部都可稱為「人工智慧」。

從技術發展來看,早期多半是採條件方式來代替人類進行單純邏輯判別,進而發展出多條件線性組合的最佳化判斷協助人類決策,再來是可自我學習的非線性算法逐漸被採用,而這些方式可歸類到「規則驅動」型人工智慧。近十年主流技術主要著墨在以數據統計分析的「資料採礦」及利用深層或時序型神經網路來訓練及學習的「深度學習」,而這幾種方式則歸類到「資料驅動」型人工智慧。

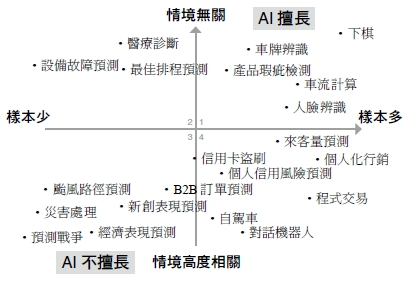

目前所謂「資料驅動」型的「人工智慧」比較擅長的是很難定規則或規則多到難以人工制定的問題(如影像分類、自然語言分析、文本理解),或者如博奕(棋牌類、遊戲類)這類結果可能變化大到人類難以估算問題,而需要透過產生精準數值(如以影像量測距離、聲音頻率計算)之類的問題反而得依靠較傳統的「規則驅動」型技術來完成;更多人工智慧擅長及不擅長的項目,藉「人工智慧在台灣」一書中的圖表可更清楚了解,右上角是目前落地狀況較佳的領域(如下棋、人臉辨別)。

機器學習擅長問題(圖片來源:buzzorange)

迷思二:AI 會自我學習只要一直提供資料就會變更厲害

目前常聽到的機器學習(深度學習)方式,不管是監督式(Supervised)或非監督(Unsupervised)式在學習完後,新資料再加入是不會自動改善學習結果的,除非將舊資料加上新資料再重新訓練後才會改善分類正確率或回歸預測能力。而當資料集越來越來大,訓練時間(成本)就會隨之提高,因此需要像遷移學習(Transfer Learning)這類技術來降低訓練時間。至於多久要重新訓練一次整合後的資料集,可能隨著不同產業需求各有不一。

另外常見的增強式學習大致上可分為兩大類,有一類像是博奕、棋類、電玩等,此類不須加入新學習樣本(也無法加入),隨訓練次數及時間增加就可越來越強,因有其特定決策條件並透過分數高低(輸贏)決定學習方向(參數),如此才算是自我學習。不過當加入新限制條件或決策規則時還是得重新學習,顯然這類作法不太適合大多數的應用。另一類以反覆訓練生成器(Generator)和判別器(Discriminator)方式來學習的手法,像是對抗生成網路(Generative Adversarial Network,GAN),雖然會在訓練過程會自我學習,讓辨識率提高,但對於新(不同樣態)樣本加入時仍會有須要重新訓練的問題。

迷思三:數據越多學習訓練效果越好

這句話只對了一半,對監督式學習來看應該說「高品質已標註資料越多越好」,所謂高品質還包含資料的多樣式及平均性,未經清洗的資料或未在特定(嚴謹)規範下標註出來的數據,只會造成垃圾進垃圾出(garbage in, garbage out,GIGO),訓練完的結果也不會有太好的結果,若是用於醫療影像應用上,標註者的專業知識及經驗更會影響判定標註品質及訓練結果,甚至影響到病患權利,因此更須謹慎處理。

另外一般更常見的問題是資料集分佈極端不平均,正常的資料可能高達 80~90% 甚至更高,而想檢出的特定分類(如不同物種影像)或不正常(如瑕疵影像)資料不到 10% 甚至更低。假設訓練後正確率為 80%,則表示有 20% 正確的資料會被當成不正常,那資料集過小的分類就很有可能永遠檢不出(或錯誤率極高),但不幸地是這些小分類通常就是我們最想檢出的內容。

因此資料集的平均性及多樣性比起單純數量大會來得更為重要,其解決手段除傳統的資料擴增法(Data Augmentation)、對抗生成網路(GAN)生成外,透過公開資料集也是不錯的解決方式,但對業界非通用需求(如工業、醫療等)通常還是得乖乖回去實際應用場域收集特定資料集才能解決。

對於非監督式學習(聚類問題)來說,數據越多總該沒毛病了吧?同樣地,不在特定情況下,還是有很大問題。首先是資料集是否為格式化資料(如固定尺寸影像)每筆資料的每個欄位是否都填滿填好,再來是資料維度是否超出算法及記憶體能力能處理範圍。舉例來說,以一個 28×28 全彩(RGB888) 影像來說,輸入維度為 28x28x3 = 2352 ,一段以 1 Khz 取樣一秒的時序變化訊號(如聲音或感測器)則有 1000 筆連續資料,當然同樣一段時序信號在不同分析方式下輸入及輸出維度可能變成一維或任意維度(N <= 1000)。

所以當資料維度變成數萬維甚至數千萬維時通常難以直接計算,須先特徵提取、資料壓縮、主成份分析或其它聚類(Cluster)等手段將資料降維才有辦法計算,對於非格式化資料(如文章、對話等)來說,資料長度過長、過大時也會遇到須先拆解或特徵提取甚至資料清洗並正規化後才能訓練問題。

迷思四:只要大量良品資料就能自動學習特徵做為不良品檢測

一般工廠在訓練作業員時,只需告知檢測基本規則或提供少數不合格問題樣本即可,當看到、聽到或量測到和正常樣本的不一樣的就要排除,不管問題出在那個位置(時間),出現的樣態只要符合規則(特徵)不管是否和原先提供的不合格樣本完全一樣,大多數作業員經過學習後都能在很快時間內上線且可有不錯的表現;但不幸地是,目前主流的人工智慧算法大部份都是「深度學習」的擴展,和人類學習(提取)特徵後再判斷的方式有極大不同,反而是要提供非常大量(數千到數百萬筆)已標註不良品資料集才有辦法運作。

訓練模型時亦要用非常大量(數萬到數億)的參數,加上反複計算數千萬到數百億次矩陣乘加運算才能求出最佳參數值(學習成果),故這樣的算法只能算是在求最佳函數解,更誇張一點來說根本就是暴力法(窮舉各種可能性),強迫訓練出的模型硬用記憶方法(填鴨法)來學習,而不是真的像人一樣學到特徵可以觸類旁通,當遇到不曾出現過的問題(符合不良品規則,但樣態不在資料集中),常難以正確檢出。所以當訓練資料集多樣性不足或分類數量極不平均時,常會在訓練(學習)時有很好的成績,但遇到真實世界數據時正確率就瞬間掉個十幾二十個百分點,比人工作業還糟的問題產生。

近來有一部份研究從建立良品特徵來進行非正常偵測(Anomaly Detection),其主要原理是先以大量良品找出樣品相關參數的高斯分佈(參數集中度),之後再以此參數作為基準進行生產,並在檢測過程中把超出 N 個標準差的樣品當成不良品,這樣就不用關心是何種不良產生都可被偵測出。但其缺點是無法分辨是何種不良,因為不同的不良問題出現次數過少,難以提取出相關參數的差異(分界點)。另外對於高維度資料(如大尺寸影像)亦難以找出合理特徵分佈區間,所以通常需搭配一些降維處理才能有效檢出。

迷思五:只要提供巨量未標註資料就能自動找出分類規則及關連

大部份的人會想說我有成千上萬的樣本是否可以直接用人工智慧找出特徵並自動分類(過分類)後,再由人工方式決定那幾類屬於同一類(分類合併)?遺憾地是目前超高維超稀疏資料集雖有一些自動聚類的方式,但當資料維度過高或者是資料集筆數過大時是極為困難進行運算的,至少不是目前常見深度學習算法可以處理的。但要人去標註成千上萬的樣本其成本又太高,所以目前有些資料樣態可以透過少量已標註的資料集來自動標註其它未標註資料集的半監督學習(Semi-Supervised Learning)方式。乍聽之下這不就解決了自動分類的問題了嗎?但嚴格來說這種手段只是大幅簡低標註時間,但最終還是要人來分辨到底標註出來的內容是否正確、品質是否良好及是否可以加入已標註的資料集中。

迷思六:一定要花很多錢買專用深度學習專用伺服器

這個問題可能要從幾個方面來看,主要分為「資料集訓練(Training)」及「資料推論(Inference)」兩大部份。在說明前以交通運輸為例,常見的運輸工具有腳踏車、機車、轎車(計程車)、貨車、卡車、火車、高鐵、貨輪、飛機,而運送管道有柏油(水泥)道路、高速(高架)公路、鐵軌(高架)、航線,另外還需搭配建置交通號誌、高架橋、隧(地下)道、車站、港口、機場等硬體設施才能讓交通順暢運行,讓使用者可自由往返兩地。

當然更重要的是要擁有操縱交通工具的人(不一定是自己)及持有對應的駕駛執照,必要時還要有專屬的車隊、客運、航運公司提供服務。當有交通需求時,使用者會依需求方便性、建置(使用)成本、交通時間、使用頻度、運輸內容(數量)而會選擇不同的交通工具及服務供應商,更進一步為了時效及運量達到最佳化,甚至採用混搭方式完成。

一般來說,深度學習的訓練時間會和模型複雜度(參數多寡)、資料集大小、正確率要求(迭代次數)有直接關連,這個部份明顯需要極大量的計算,因此選擇高速運算設備會省下許多時間。選擇計算工具依不同建置成本(包含人及設備)可從 CPU(單核、多核)、GPU(數百到數萬核)到專屬設備(如 TPU、FPGA、ASIC),可自己建置亦可透過雲端高效計算(HPC)服務,和買(用)車一樣,依不同需求買不同車種或者請交通運輸業者提供對應服務,就像台北到高雄是要自己騎機車、買車開車、搭火車(高鐵)還是飛機一樣。

同樣地,高效計算建置整體考量的重點和交通是一樣的,硬體建置、消耗能源(網路、電力、空調)、人員(內部、外部)配置、使用頻度(訓練次數)及方便性等因素。當然一開始就要採購高價設備可能對很多小公司風險太高,此時可多利用知名雲端高效計算(Google GCP、Amazon AWS、Microsoft Azure)算力,採用部份(較少筆數)資料集、低一點的正確率(或少次數迭代)來進行不同模型的概念測試,如此即可在較短時間找出可行方案及後續需要投入資源(算力、時間)。

若使用情境為模型訓練完後,幾乎不太需要重新訓練或很久才需重新訓練一次,那大部份的時間只有用到推論,那就很可能完全不用高價高性能的專用伺服器,只需不用連網的邊緣運算設備,如低價的專用IC(NPU、ASIC)、樹莓派或手機上就能直接進行推論(運算)。當然若要提供大量的使用者同時使用推論服務時,則可考慮自建推論伺服器(單機或機房)或使用雲端高效計算及儲存空間,至於何者划算就得看使用計算效能、連線數量、推論頻(速)度、耗能及管理(運營、折舊)成本等各項因素了。

迷思七:選對模型調好超參數就搞定 AI 應用

一個完整的 AI 落地應用就像煮一盤美味咖哩雞飯的流程一樣,不是只有一個好的模型就能完成,它包括「資料收集」、「資料清洗」、「資料標註」、「資料倉儲」、「特徵分析(模型建立、超參數調整)」等步驟,最後才是完整的「智能應用」。

通常建模及調參可能佔不到 20%,許多 AI 新創公司及想導入 AI 的廠商常會忽略或輕視前面三大步驟,或者說不想把手弄髒,只想展現燒菜技巧,導致取得品質不良的原料,造成「垃圾進垃圾出」,模型怎麼調整都得不到好結果。

一份完整的美食除了有很好的原料及加工(工序)外,擺盤和餐具也是影響顧客食慾的一大因素,所以一個完整的 AI 應用如何佈署訓練好的模型及參數到執行(邊緣)端並提供流暢的執行效率,也是影響使用者是否能給予好評的重要因素,不能等閒視之。

迷思八:正確率越高越好

這句話表面上看來沒有什麼大問題,有誰不想正確率接近百分之百,但只靠正確率這樣就沒問題了嗎?更進一步請參考下一節「如何確認導入 AI 成效」中對各項指標的說明。

如何確認導入 AI 成效

前面提到一般人對人工智慧(AI)有著許多的迷思,因此對導入 AI 也常有著不合理的過高期待。因此不論是想藉導入 AI 來減少人力支出、提升(穩定)檢測品質、預測產能及故障維修周期等,都必須以適當指標來衡量導入效果。就實務上來說不是把指標訂的越高越好,這樣在導入時會有很大的挫折感。

舉例來說一個想減肥的人,體重就是他的指標,假如他目前 100 Kg,目標是 50 Kg,若期望一個月要達成,則付出的代價及辛苦可能無法言喻。但如果把期望值改成一年達成,那就輕鬆多了。因此導入 AI 前要先量測目前以人工或是現有設備能做到的程度(指標分數),再訂立改善目標和期程逐步達成。當然過程中一定也會遇到撞牆期,怎麼改善都無法讓指標分數更好些,此時就要再重新檢討該算法(模型)是否已達極限,是否要再換個算法(模型)或是加入更多樣態的資料集來改善。

為了讓大家能更了解不同問題所適用的指標,以下就「分類」、「物件定位」、「影像分割」、「語音客服」、「自然語言(文本)理解」、「時序預測」等六大問題適用指標進行說明。

1. 分類問題

在前面迷思八中有提到大部份的人會以「正確率」作為判定導入 AI 的重要指標,但正確率高就表示 AI 完美執行並完成工作了嗎?其實並非如此,以下就各項常用指標進行說明。

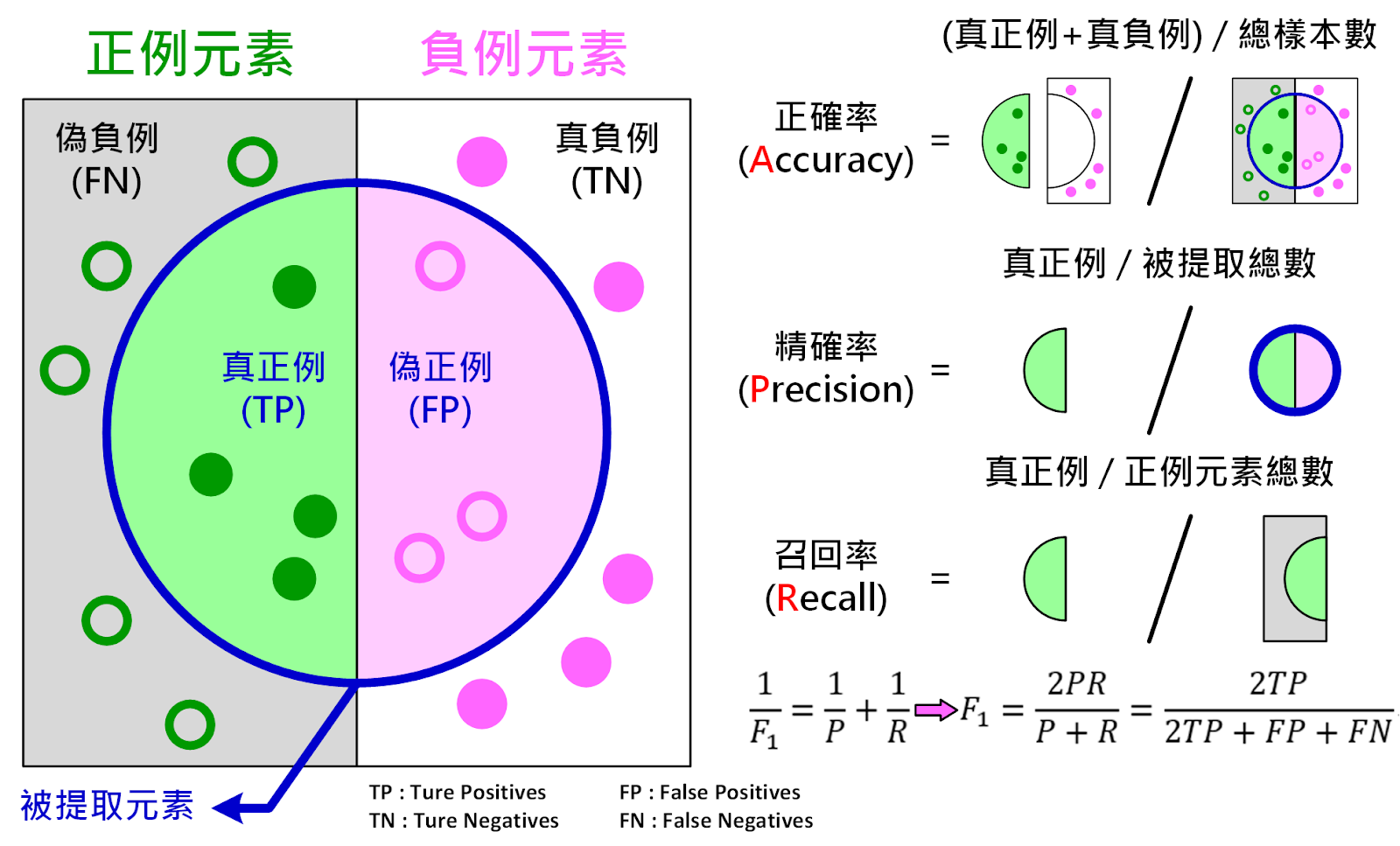

假設有一測試資料集如下圖所示,其中包含正例元素(Positive Elements)和負例元素(Negative Elements)(或可稱為正樣本及負樣本)當執行某一 AI 演算法後可提取出一些元素(如下圖藍圈所示),其中包含真的正例元素(True Positives,TP)和偽的正例元素(False Positives,FP)(就是負例被當成正例的樣本)。而未取提到的部份則包括偽負例(False Negatives,FN )(正例被當成負例樣本)及真負例(True Negatives,TN)(本來就不該提取出來的負例樣本)。

一般來說真正例(TP)加上真負例(TN)再除以所有元素總數即可得到正確率(Accuracy),但如果遇到正負例數量極不平均時,那正確率就會失去表達能力。舉例來說,真正的良品佔總樣本數量 95%,不良品數量佔 5%,若把所有樣本都當成良品,經由正確率公式計算後,正確率為 95%,表面上得到極高的正確率,但這樣的結果明顯不是我們要的,因為負例(5%)全部被無視了。

為更容易了解算法的可用性及避免正確率極易受正負例數量比例影響,目前許多人改用精確率(Presicision)及召回率(Recall)來做為參考指標,而不同應用領域對這兩個指標的高低要求也有很大的差異。所謂「精確率」是指提取出真正例(TP)佔總提取出樣本(TP+FP)總數的比例,而「召回率」或稱查全(查準)率、真正例(真陽性)率(True Positives Rate,TPR)、敏感度(Sensitivity),是指提取出的真正例(TP)佔總正例元素(FN+TP)總數的比例,可作為偽負例(假陰性)的量化指標;和召回率相反的是特異性(Specificity),也稱為真負例(真陰性)率(True Negative Rate,TNR),是指提取出的真負例(TN)佔總負例元素(FP+TN)總數的比例,可作為偽正例(假陽性)的量化指標。

以醫療影像為例,假設有病為正例(陽性),沒病為負例(陰性),真正例(TP)可視為醫生診斷有病而病人也確實有病,而真負例(TN)則是醫生診斷沒病而病人也確實沒病,以上狀況都是完美的。若沒病當成有病(FN)頂多病人虛驚一場,但有病當成沒病(FN)時馬上會產生醫療糾紛問題那麻煩可就大了,因此在醫療領域要求的召回率就會非常高。另外為了方便表達兩項指標的互動關係,亦可用 F1 Score (或稱 F-score、F-measure)來表達,其公式為二倍精確率(P)乘以召回率(R),再除以精確率(P)加上召回率(R)。

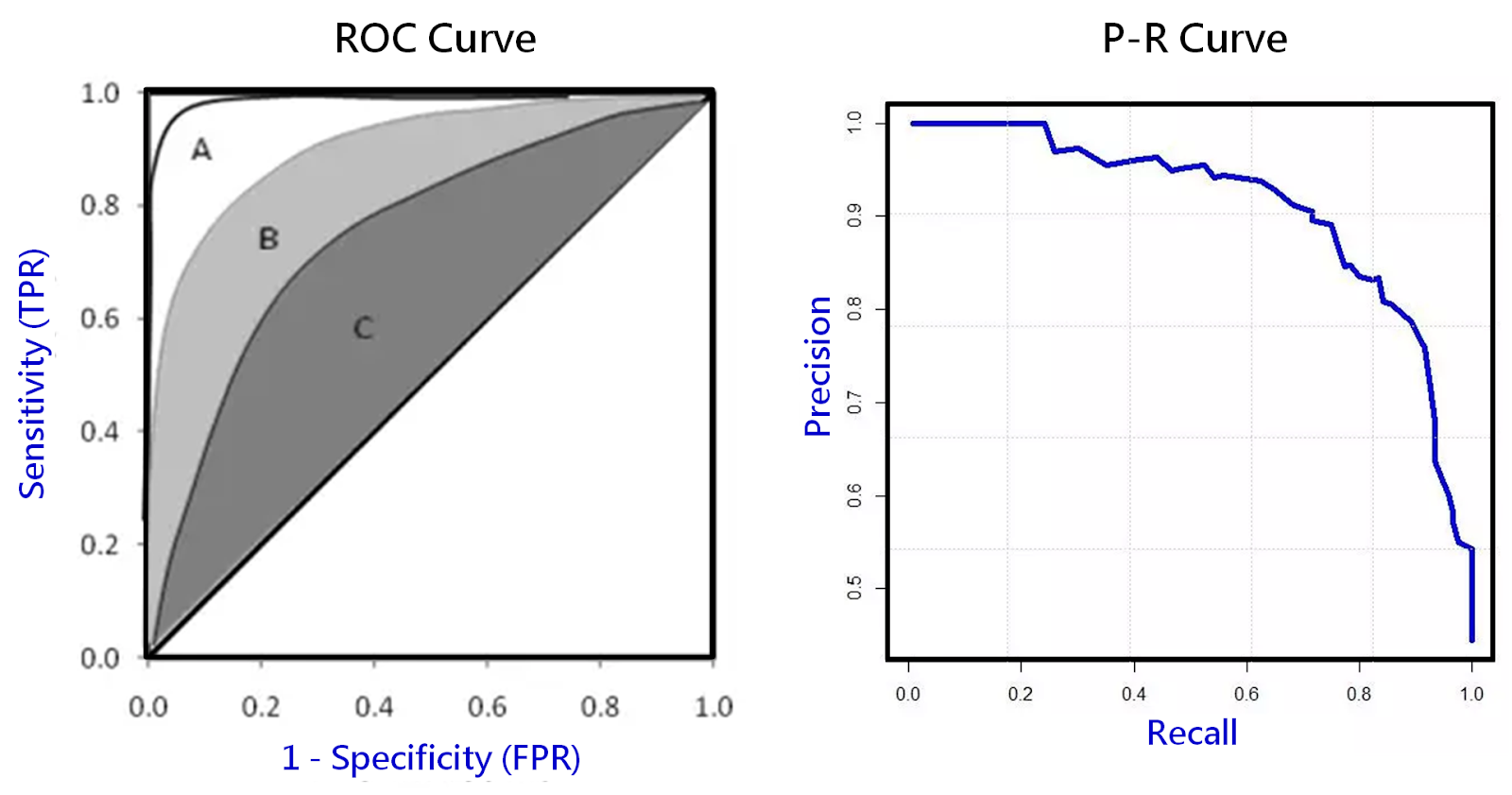

由上述說明可知,當算法變動或說篩選(分類)的門檻值變動時,FP 和 FN 都會產生變動,而為了更進一步了解分類的品質好壞,常會再利用 ROC 曲線(Receiver Operating Characteristic Curve,ROC)(如下圖左)或 P-R 曲線(recision – Recall Curve)(如下圖右)來分析;ROC 曲線圖的縱軸為敏感度(即召回率,真陽性率),而橫軸為 1- 特異度(Sensitivity),等於偽陽性率(False Positivity Rate,FPR)。

當曲線為 45 度斜線時代表沒有鑑別度(是最差狀況),而下圖中的 A 曲線優於 B 優於 C ,有時亦可改用曲線下方面積總和(Area Under Curve,AUC)來表示,面積越大分類效果越顯著,而 P-R 曲線圖的縱軸為精準度,橫軸為召回率;由於 P-R 曲線橫軸和 ROC 曲線縱軸都是召回率,所以基本上這兩種表示方式有很大連動(關連)性,但又有些不同,至於採用那一種,亦或兩種都採用,則視不同應用領域有所不同。

*影像物件定位問題

對於單一(影像、聲音、文本、數據)分類問題只需用到精確率(Precision)和召回率(Recall)大概就足夠,但遇到同一筆資料中有多個分類出現時(如從影像中找出多個物件並定位)就需改採平均精確率(Average Precision,AP)或者平均多筆平均精確率(mean Average Precision,mAP)來做為指標,接下來就以單一影像中出現多個物件為例作進一步說明。

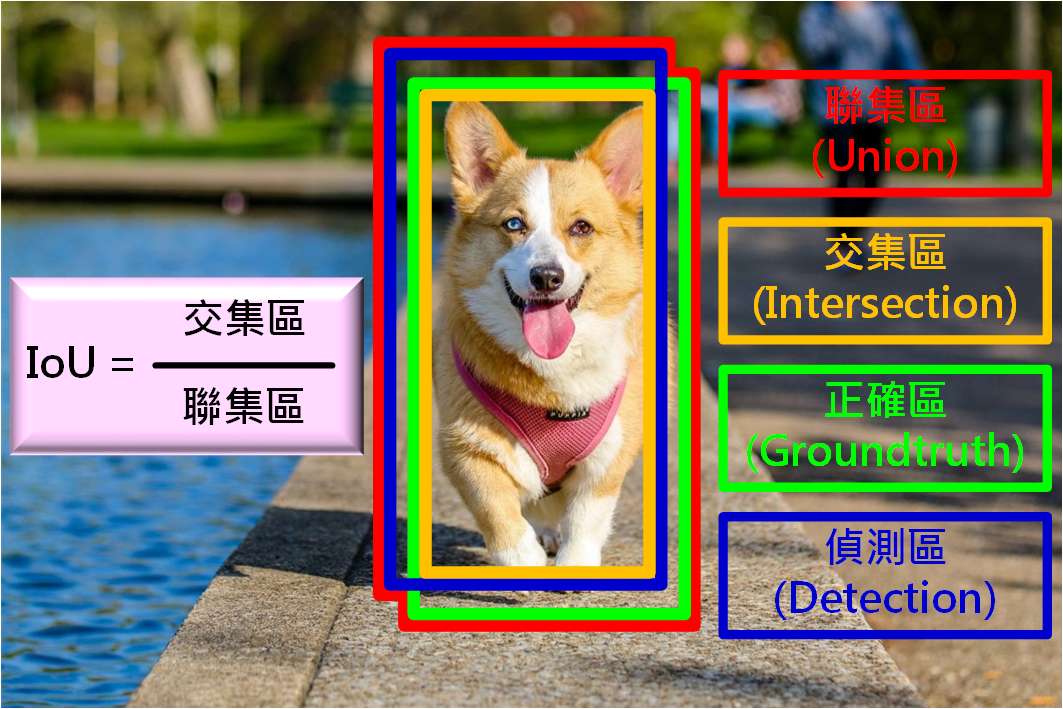

首先要定義一個物件是否被正確偵測到且位置也很正確,此時會利用真實物件邊界框(Bound Box)和偵測到的物件邊界框聯集區中交集區(Intersection Over Union,IoU)的佔比做為指標,如下圖所示,其公式即為交集區面積除以聯集區面積;當 IoU = 1.0 時為完全重疊(正確位置),而 IoU 值低於自訂門檻值時就視為未找到(負例元素)。

接著對所有找到的物件(不管同一張影像出現幾次,出現在多少張影像中)計算 P-R 曲線,而曲線下方面積(AUC)即為對此物件的平均精確度(AP)。若再擴張到不同物件,假設有 N 種物件待偵測,就會求出 N 個 AP 值,可能有的高有的低,再對所有 AP 加總求平均,此時就可得到平均多筆平均精確率(mAP)。

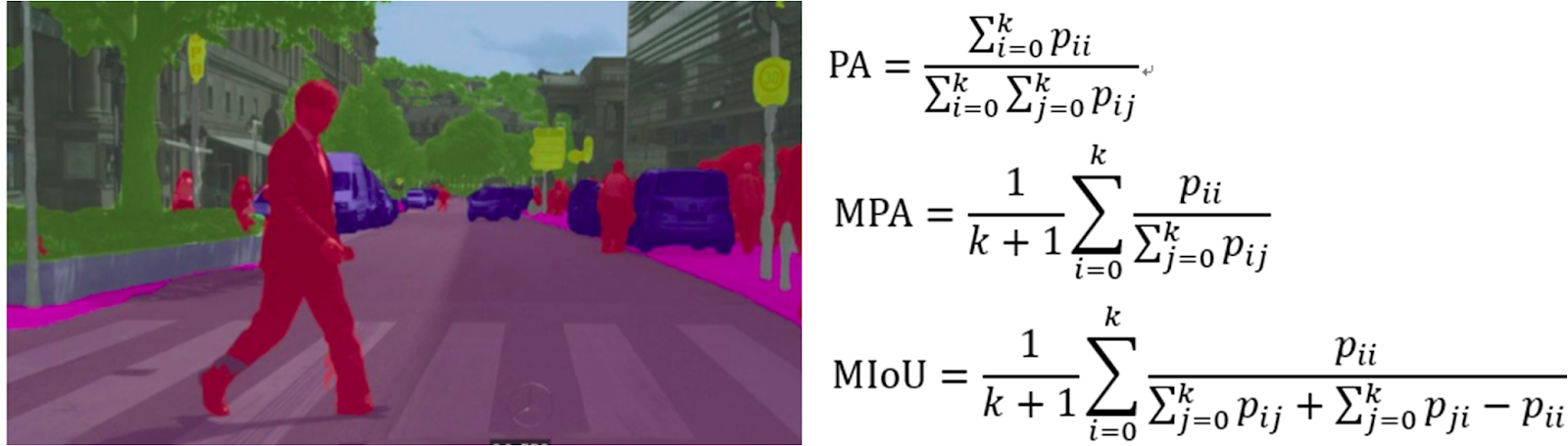

2. 影像分割問題

影像語義分割(Semantic Segmentation)基本上等於像素級分類,把每個像素進行分類,所以精確率計算方式可以用分類方式計算亦可類似影像物件偵測方式計算,如上圖所示。假設像素會被分到 k 個分類(包括背景),而第 i 類像素正確被分到第 i 類的像素總數以 Pii 表示,而第 i 類像素分到第 j 類的像素總數則以 Pij(包括Pii)表示,以下就介紹幾種常見的三種準確率指標(PA、MPA、MIoU)。

首先是像素準確率(Pixel Accuracy,PA),概念上和一般分類一樣,把分類正確的像素數量(Pii)除以像素總數(Pij);平均像素準確率(Mean Pixel Accuracy,MPA),則是先對每一類求 PA,再把所有類的 PA 平均;平均交集聯集比(Mean Intersection over Union,MIoU),先計算每個分類像素真實分類和預測分類的交集區大小(像素個數)和聯級區大小,再求出 IoU,最後把所有分類的 IoU 加總求平均即可得 MIoU。

3. 語音客服問題

語音客服主要目的是節省人力,取代以往電話語音客服工作,讓客戶能利用語音(或文字串)提問並快速得到已預設的答案,不需層層選擇。因此廣義來看這也可屬於分類問題,事先建好的問題答案對照表(Q & A Table)中的答案就等於待分類的項目,可參考分類項指標來評估。除了基本指標外,還可建立一個無法分類轉接真人客服次數的指標,方便未來強化問題答案對照表及分類精確性。

4. 自然語言(文本理解)問題

從一段自然語言(或一段文章)中要提取特定資訊,這部份較難定義定量指標來決定品質,可能要藉由真人建立評分資料庫後,再將分數當成訓練參數,以得到定量指標,另外亦可將此類問題重新定義成一般分類問題,那就可利用分類指標來作為定量評估基準。

5. 時序預測(回歸)問題

一般時序預測或線性(非線性)回歸問題,對於推論部份來看,通常只需把預測出來的值和真實值相減後就能得到差值,即可得知預測的準確性,所以通常不須特別指標。若不只想做單點時間預測而是要用評估一小段時間的預測品質,則可考慮使用「平均絕對誤差」、「均方誤差」、「中位數絕對誤差」等常用指標來評估。

如何出題以獲有效解題

從 2019 年第一梯次及第二梯次出題來看,雖然 AIGO 官方已有舉辦出題工作坊,也有提供廠商出題規範(指定欄位)來逐漸改善出題品質,但實際出題時還是很多廠商無法清楚表達需求,似乎是出題方為了保密,所以只能不斷強調待解問題很重要,期待有緣人來解題。更有些廠商將待解 AI 問題放大到系統(產品)級問題,猶如產品研發外包,導致單純 AI 解題方難以投入,間接造成難以媒合成功問題。綜合所有出題內容來看,智慧醫療領域出題方式算是比較理想的,因此也較容易找到合適解題團隊及方法,以下就個人觀點整理出題重點,可作為未來出題方及解題方參考,協助大家更快找到交集,順利讓 AI 應用完美落地。

首先是「問題定義」,要先確認是屬於「電腦視覺」、「自然語言」、「數據分析」或「混合類」大類,再來可再細分是「分類問題」、「回歸預測(時序預測)」、「問答對應」、「自然語言理解」、「資料探勘」或其它類型問題,因為這會連動到究竟要以何種指標來衡量結果是否接近人工處理能力,已滿足 AI 應用。

再來是「樣本範例」,大部份的出題方都未提供輸入及輸出資料樣本格式,包括影像、聲音、文本、數據,這會嚴重影響解題方可能提出之解決手段及方案。雖然有些廠商基於保密問題不方便提供,但出題時仍應備妥具代表性去識別化樣本資訊,以利解題方評估技術複雜度。

接著需說明「資料集」收集狀態,此次出題方在資料收集上大致分為「使用公開資料集」、「已收集足夠並已標註」、「有巨量資料但無標註」、「有少量標註和巨量未標註資料」、「無資料集待解題方收集、標註」,除了前兩項外,其它都會對解題方造成極大的負擔,如果遇到有特定領域專業知識才能標註時,若出題方無法支援教育訓練或協助標註,那案子失敗機率就會大幅增加。另外資料集收集及標註上由於執行方不同可能會產生智財擁有權問題,這部份則需事先約定好歸屬(出題方、解題方或共同擁有)以免造成糾紛。

另外明確的「標註規範」,不論是監督式、非監督式都是極度必要的,因為除了可提高標註水準外,對於各項指標的分數也會受此影響。另外像醫療影像標註時為求慎重,有時還須多位(不同經驗)醫生同時對同一張影像進行標註,以利確認其正確性及容許度。

最後對「評量指標」必須明確定義,可參考上一節「如何確認導入 AI 成效」中提到的各種指標。在定義範圍時,雖然出題方可無上限的要求,但實務上可能永遠做不到,因此合理的要求甚至暫時性的退讓或階段性要求都是出題方為求更快落地的妥協結果。

當然如果出題方有專屬的 AI 工程師當窗口,那對解題方來說就可減少許多溝通時間,也會有較多解題廠商投入。

小結

此次 AIGO 官網僅提供出題方的資訊,但就媒合角度來看應該是雙向的,讓解題方也能透過 AIGO 官網自我介紹一下,展現一下團隊能力及經驗,不然僅靠不到十分鐘的輪桌會及後續面談可能難以讓出題方留下深刻印象。除此之外若能公開解題方資訊,即使此次無法媒合到合適廠商或太多解題方搶一個題目未能出線時,仍有機會被其它出題方或未出題廠商看到,這樣對促進台灣 AI 產業互動應更有助益,使 AIGO 這個平台更能展現其效益。

(本文轉載自歐尼克斯實境互動工作室、完整原文請見原文連結;責任編輯:楊子嫻)

- 【開發資源】TinyML MCU 等級開源推論引擎 - 2025/06/09

- Arm架構引領行動運算新典範:開發者無痛轉移密技大公開 - 2025/05/29

- 輕鬆用Intel AI PC及OpenVINO建立數位分身 - 2025/03/27

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!