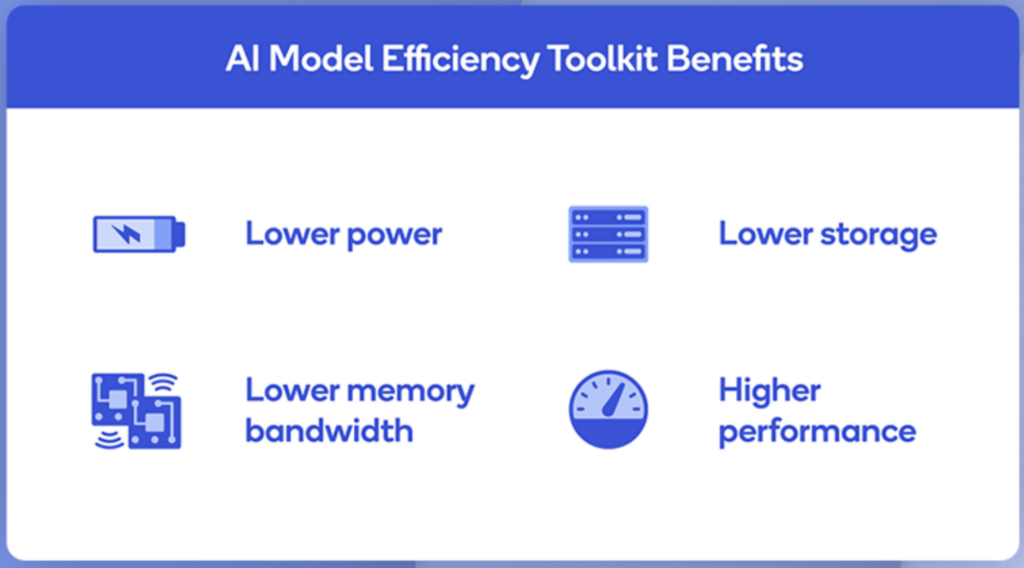

Qualcomm® AI Model Efficiency Toolkit (AIMET) 是 Qualcomm 開發的一套 AI 模型優化工具,它透過壓縮和量化技術來縮小模型,同時保持任務的準確性。更小的模型意味著更高的運行性能和更低的延遲以及更低的計算、記憶體和功耗,有助於提高其在資源受限設備(如手機、邊緣裝置、IoT 設備)上的運行效率。

Qualcomm® AI Model Efficiency Toolkit (AIMET) 是 Qualcomm 開發的一套 AI 模型優化工具,它透過壓縮和量化技術來縮小模型,同時保持任務的準確性。更小的模型意味著更高的運行性能和更低的延遲以及更低的計算、記憶體和功耗,有助於提高其在資源受限設備(如手機、邊緣裝置、IoT 設備)上的運行效率。

開發人員可以將 AIMET 先進的模型壓縮和量化演算法整合到他們的 PyTorch 和 TensorFlow 模型建立管道中,以實現自動訓練後優化以及模型微調。這些演算法的自動化有助於消除手動優化神經網路的需要,因為手動優化神經網路可能很耗時、容易出錯且難以重複。AIMET是Qualcomm AI Stack 的一部分 ,開發者可以在開發中結合多種軟體功能。

高通創新中心(QuIC)在GitHub 上開源了 AIMET, 以便與其他領先的 AI 研究人員合作,並為 AI 開發人員提供一個簡單的程式庫插件,以實現最先進的模型效率性能。AIMET用到的尖端壓縮和量化技術是基於 Qualcomm AI Research的創新研究。

AIMET 的模型優化技術 #

1. 量化(Quantization) #

AIMET 支援後量化(Post-Training Quantization, PTQ) 和 量化感知訓練(Quantization-Aware Training, QAT),可將 32-bit 浮點數(FP32)模型轉換為 INT8 或更低精度,從而減少模型的計算需求和存儲大小。

此技術的主要優勢是能減少記憶體使用量,從 FP32 降為 INT8 可減少約 4 倍 的儲存需求。量化後的模型可加速推理速度,特別是在 Qualcomm 硬體(如 Snapdragon AI Engine)上。

此外,透過 QAT 技術則可在訓練階段模擬量化誤差,以減少準確度損失。

2. 剪枝(Pruning) #

AIMET 提供多種剪枝技術,透過移除冗餘的神經元來減少模型大小和計算量,例如:Channel Pruning(通道剪枝):移除 CNN 模型中影響較小的通道,以減少運算量;Spatial SVD(空間奇異值分解):將權重矩陣拆解,以降低計算複雜度。剪枝後的模型可顯著減少參數量,同時保持高準確度。

3. 批量歸一化折疊(Batch Normalization Folding) #

這項技術可以將 Batch Normalization(BN)層 與相鄰的卷積層合併,減少計算開銷,加快推理速度。

兼容性與應用領域 #

AIMET 針對 Qualcomm 的 Snapdragon AI Engine 及 Hexagon DSP/NPU 進行最佳化,確保優化後的模型能高效運行於 Qualcomm 晶片上,如Snapdragon 處理器(手機 AI 運算)、Qualcomm RB5(機器人與嵌入式 AI)、Qualcomm Cloud AI 100(雲端 AI 加速)。

AIMET 可被應用於以下領域:

- 行動裝置 AI,如智慧手機上的影像識別、語音處理、自然語言處理

- 邊緣 AI,如監控攝影機、IoT 設備

- 自動駕駛,ADAS 系統

- 醫療 AI,如AI 診斷、X 光影像分析

如何使用 AIMET #

AIMET 可與 TensorFlow、PyTorch、ONNX 等框架兼容,開發者可以透過 Python API 來進行模型優化。例如,對一個 ResNet 模型進行後量化:

import aimet_torch.quantsim as quantsim

from aimet_torch.model_preparer import prepare_model

import torch

# 加載 PyTorch 模型

model = torchvision.models.resnet18(pretrained=True)

# 量化感知準備

model = prepare_model(model)

# 創建量化模擬(Quantization Simulation)

sim = quantsim.QuantizationSimModel(model, dummy_input=torch.rand(1, 3, 224, 224))

# 訓練校準(Calibration)

sim.compute_encodings(forward_pass_callback, forward_pass_callback_args)

# 儲存優化後的模型

sim.export(path="./optimized_model", filename_prefix="resnet18_quantized")

小結 #

整體而言,AIMET 的優勢包括減少模型大小,降低記憶體與存儲需求;加速推理,特別適用於 Qualcomm 晶片;保持高準確度,透過量化感知訓練(QAT)和剪枝技術減少性能損失;支援多種 AI 框架(TensorFlow、PyTorch、ONNX);適用於邊緣 AI 應用,特別是在行動裝置、嵌入式系統和 AIoT 領域。

AIMET 讓開發者能夠在 Qualcomm 硬體上運行 更小、更快、更高效的 AI 模型,特別適用於行動 AI 和邊緣 AI 應用。

》延伸閱讀: