作者:陸向陽

嶄新的一年已開始,回顧去(2021)年的Maker人工智慧嵌入式專案,多數仍是在NVIDIA的Jetson Nano上實現,因此檢視較佳的Jetson Nano專案,或許有助於眾多Maker對新專案的發想,以及現行專案的改進唷!

1.搜救無人機

圖1 Jetson-Nano Search and Rescue AI UAV(圖片來源:hackster.io)

以GitHub上的無人機專案PX4 Pixhawk為基礎,再附搭上Jetson Nano進行飛行影像判別,構成搜救無人機。

Jetson Nano上執行的是Darknet tiny-YOLO V3(推論判別速度快且記憶體佔量少),在取得空照影像後,搭配PX4 Pixhawk給出的座標、高度等數據,從而研判影像中是否有人。這個專案跟無人機的飛行控制各自分離,所以也可以跟其他無人機專案結合運用,如ArduPilot、DJI Pilot等。

2.人工智慧的狗形機器人SpotMicro

圖2 SpotMicro(圖片來源:SpotMicro專案)

專案靈感明顯來自波士頓動力公司的Spot,一開始是用Arduino Mega建構的,後來進行相關擴充而有了AI需求,因而改用Jetson Nano運作。

專案期望讓狗形機器人在各種環境下正常行走,所以硬體上用及LiDAR(光達)、超音波收發感測、慣性感測,以及樹莓派攝影機,在收集各種感測數據後再透過AI研判,從而下達正確的移動控制命令。

3.姿態偵測

圖3 人體姿態偵測(圖片來源:NVIDIA)

這是NVIDIA官方發起的專案,專案硬體上只要1個攝影機,專案中已有預先訓練的AI模型,模型可偵測出影像中人的形體,然後想進一步去偵測人眼位置、直角姿態等就變得比較容易。專案應用簡單,但卻很吃耗影像擷取、人工智慧運算等資源,因而需要用上Jetson Nano。

4.RB-0漫遊車

圖4 RB-0(圖片來源:hackster.io)

RB-0是一個漫遊車專案,它的懸吊設計採行搖臂-轉向架系統(Rocker-Bogie system),這是與美國太空總署NASA新式太空漫遊車相同的系統。RB-0漫遊車的身車零件多數是用3D列印成,且只要用20 x 20公分的小型3D列印機即可。

RB-0漫遊車上也用到樹莓派攝影機、伺服馬達、線性伺服馬達等,影像的AI識別自然是用Jetson Nano。

5.面罩偵測

圖5 面罩偵測(圖片來源:GitHub LorenRd)

面罩偵測的專案使用跟前述的搜救無人機相同的視覺演算法(YoloV4/Darknet),但改用來偵測影像中的人有無配戴口罩,有則亮綠色LED,反之亮紅色LED。專案不需要再行訓練自己的模型,而是運用853張圖片預先配置資料集。

除了偵測有無配戴外,也能偵測是否配戴正確,無配戴會在影像中標示藍框,有正確配戴則是粉紅框,配戴不正確則是綠框。

6.除草機器人

圖6 Auto roboculature(圖片來源:GitHub)

Auto roboculture是一個自動除草機器人專案,它運用滑輪進行移動,並配有樹莓派攝影機及一個類似夾娃娃機的抓爪,抓爪系統稱為Nindamani,系統透過攝影機影像、Jetson Nano的AI識別,而能區別雜草與作物,然後操控抓爪只拔起雜草,保留作物。為了精準操控抓爪,操控方式採類似於3D列印機噴頭的操控法,而非一般夾娃娃機的單純垂吊操控。

Auto roboculture完全相容ROS 2作業系統,電池使用時間約8~10小時,使用TensorFlow與Keras技術;Nindamani使用Mask-RCNN的預先訓練模式,對雜草的識別率達85%。

7.賽車型機器人

圖7 MuSHR(圖片來源:GitHub)

MuSHR是用於教育、機器人研究的賽車型機器人專案,是一個平台,平台上配備有Intel RealSense 3D深度攝影機、LiDAR光達、保險桿上有碰撞開關,車棚車殼則是以3D列印成。MuSHR使用YoloV5來訓練模型,模型用來偵測外界其他的車輛、規劃行駛軌跡,或深度學習的自駕技術教學等。

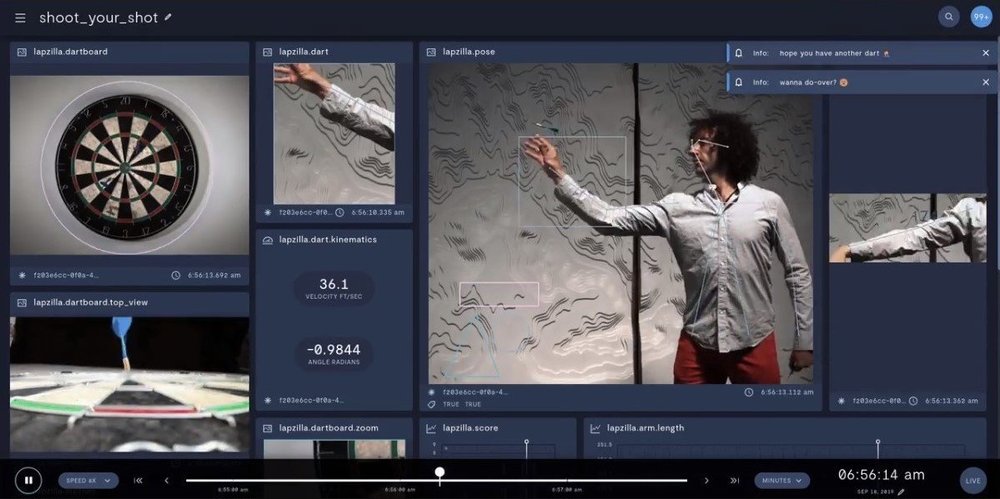

8.飛鏢偵測

圖8 Shoot Your Shot!(圖片來源:hackster.io)

Shoot Your Shot!專案運用5個攝影機來捕捉射鏢人的姿態歷程,使飛鏢可以越射越精準。

9.瘧疾偵測

圖9 瘧疾偵測(圖片來源:hackster.io)

瘧疾很致命,但早期發現很好治療,然而對偏遠地區而言早期發現有其困難。

Salman Faris發起的專案先運用OpenFlexure顯微鏡專案,以3D列印方式印出一台數位顯微鏡,搭配內有27,000張受感染的血液細胞圖片的NIH資料集,而後用TensorFlow預先訓練出可以偵測血液圖像是否有瘧疾的AI模型,再透過Jetson Nano進行推論研判,讓偏遠地區也能及早發現瘧疾。

10.動物聲音偵測

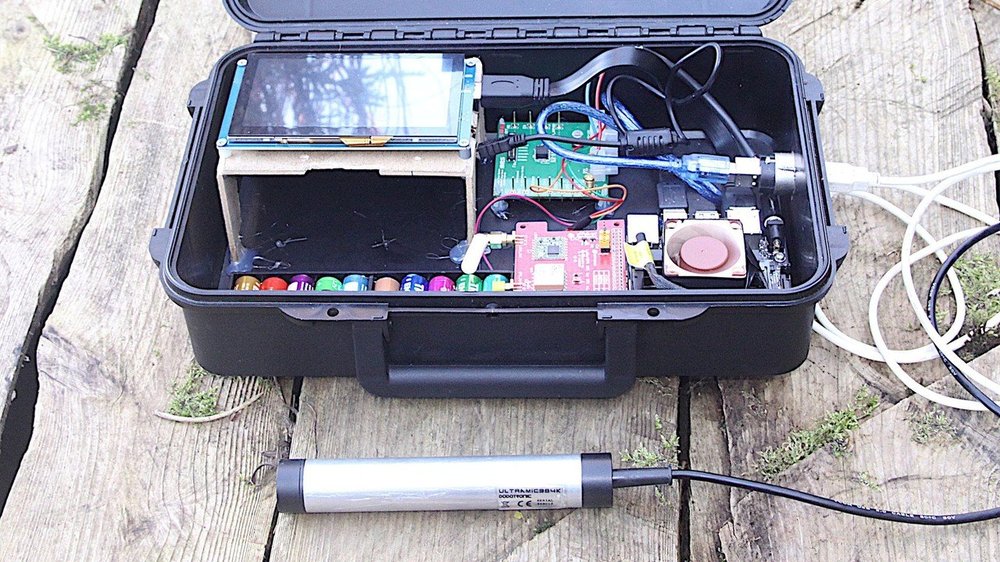

圖10 Intelligent Wildlife Species Detector(圖片來源:Hackaday)

專案名稱Intelligent Wildlife Species Detector(野生物種智慧偵測器)是一個盒子,盒內有12V電池、GPS定位、USB麥克風(UltraMic 384,銀色棒狀,除了一般聲音外也能偵測超音波)、5吋電容式LCD顯示器(人機操作介面),盒子放置於野外環境,依據GPS定位來掌握附近應當會有哪些類型的野生動物。

然後盒子運用電池電力持續在野外錄音,並運用Jetson Nano研判是否有動物的叫聲,而偵測超音波是為了偵測蝙蝠,該專案已能偵測7種蝙蝠。

(責任編輯:謝涵如)

- Windows PC上安裝PicoClaw最基礎實務 - 2026/03/03

- 跟上「龍蝦」潮了嗎?xClaw旋風現象觀察與後續 - 2026/02/26

- MakerPRO「2025台灣Edge AI開發者調查」初探 - 2026/02/11

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!