作者:歐敏銓

Gemini、GPT-4V 與 Claude 3 的能力解析與未來展望

“真正的智慧,不只是能聽、能看,而是能『綜合感知』並推理。”

— AI 學者 Yoshua Bengio,在 2024 年 AI 前沿會議上

當人工智慧從單一文字生成邁向多模態輸入時,它就像打開了另一個感官世界。而如今,「全模態 AI」(Omnimodal AI)的輪廓已逐漸浮現——不僅能讀、能看,還能聽、能理解並推理。這一轉變不僅提升了 AI 的表現能力,更意味著通用人工智慧(AGI)已站上門檻。

多模態(Multimodal)模型,代表 AI 能理解多種形式的輸入——例如文字 + 圖像。但「全模態」則更進一步,要求模型能夠任意模態之間無縫轉換與融合。例如,一段影片可以直接被理解為文字敘述、行為推理或情感分析,而不需要手動轉換模態。

Google、OpenAI 與 Anthropic 等技術大咖,正紛紛推出自家具備全模態雛型能力的旗艦級模型,試圖在這場「感官革命」中搶佔高地。

Gemini 2.5 Pro

Google 的 Gemini 2.5 Pro 是其最新的人工智慧模型(2025/3/28推出),具備強大的多模態處理能力。根據 Google 的說法,Gemini 2.5 Pro 能夠處理文字、音訊、圖像、影片以及大型程式碼庫等多種資料形式,並提供增強的推理能力和更大的上下文視窗。(延伸閱讀)

最新MRCR (Multi Round Coreference Resolution) 評估(Source)

相較之下,上一版的Gemini 1.5 Pro 也支援多模態輸入,包括文字、圖像、音訊和影片,並能夠處理高達 100 萬個 token 的上下文。然而,Gemini 2.5 Pro 在推理能力和處理複雜任務的表現上有所提升,並計劃將上下文視窗擴展至 200 萬個 token。(延伸閱讀)

總體而言,Gemini 2.5 Pro 在多模態處理和推理能力方面相較於 Gemini 1.5 Pro 有所進步,特別是在處理複雜任務和更大的資料集方面。然而,Gemini 1.5 Pro 仍然是一個功能強大的多模態模型,適用於各種應用場景。

舉例來說,用戶可以上傳一段影片並提問:「請分析角色的心理狀態變化。」Gemini 不僅能從語音與視覺線索中解讀內容,還能產出語意一致、邏輯嚴謹的分析結果。這樣的能力不僅改變了使用者與 AI 互動的方式,也開啟了跨模態創作、醫療輔助與教育新應用的可能性。

GPT-4o

OpenAI 於 2024 年 5 月推出全新旗艦模型 GPT-4o,其中的 “o” 代表 omni,意即全面模態支援。這是首款原生整合文字、圖像與音訊處理的 AI 模型,不再依賴外部模組轉換,使得跨模態理解與生成更加順暢自然。

GPT-4o 最受矚目的創新在於其即時語音互動能力。使用者可直接與模型對話,GPT-4o 不僅理解語意,還能辨識語調、情緒與語速,甚至模擬自然的中斷與回應,帶來類似真人的對話體驗。

語言能力方面,GPT-4o 支援超過 50 種語言,涵蓋全球 97% 使用者語言,展現出卓越的跨語言推理與生成能力。視覺與語音處理則不僅止於「看」與「聽」,更強調理解與邏輯推理的深度。

效能與成本表現亦是其一大亮點。GPT-4o 執行速度為 GPT-4 Turbo 的兩倍,API 成本則減半,同時提升五倍的使用限制,大幅降低了開發與部署門檻。在標準測試中,GPT-4o 在 MMLU(Massive Multitask Language Understanding)測驗中獲得 88.7 分,高於 GPT-4 的 86.5,顯示其在多模態理解與語言推理上的領先地位。

Claude 3.7 Sonnet

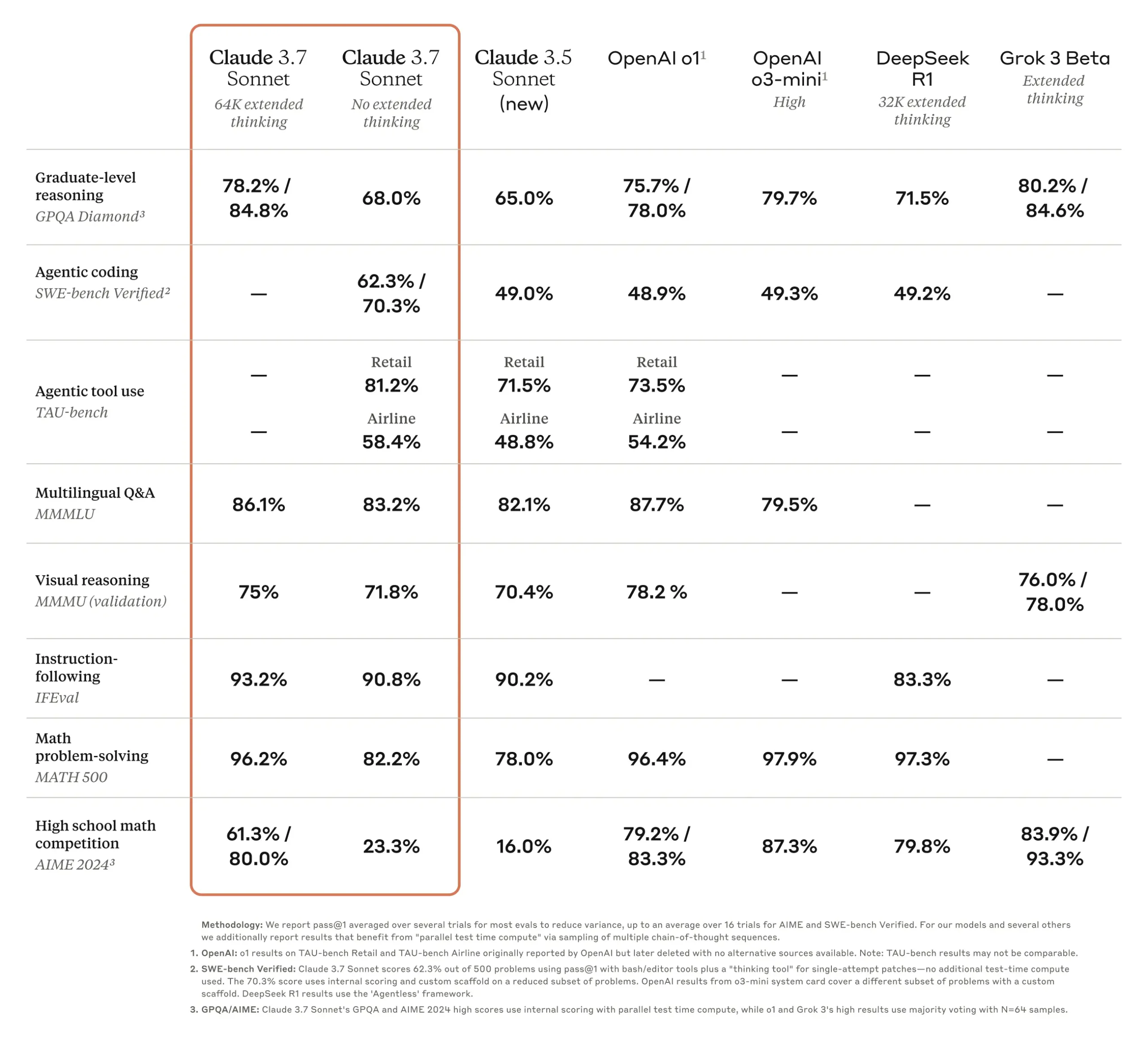

2025 年 2 月,Anthropic 推出其最新旗艦模型 Claude 3.7 Sonnet,標榜為首款「混合推理模型」(hybrid reasoning model),在多模態處理與推理能力上取得顯著進展。

Claude 3.7 Sonnet 支援文字與圖像輸入,能夠進行文件分析、圖像描述等任務,顯示其多模態處理能力。然而,與 OpenAI 的 GPT-4o 相比,Claude 3.7 尚未支援音訊或語音輸入,尚未達到「全模態」的標準。

在推理能力方面,Claude 3.7 引入了「延伸思考模式」(extended thinking mode),允許模型在回答問題前進行更深入的推理與反思,提升其在數學、科學等領域的表現。

此外,Claude 3.7 在程式碼生成與工具使用方面表現出色,特別是在 SWE-bench Verified 測試中,得分達到 62.3%,顯示其在軟體工程任務中的實用性。

總體而言,Claude 3.7 Sonnet 在多模態處理與推理能力上取得了重要進展,為實現全模態 AI 邁出了關鍵一步。然而,與支援文字、圖像、音訊與語音的 GPT-4o 相比,Claude 3.7 尚有進一步發展的空間。

Benchmarks(Source)

小結

人工智慧的未來不僅關乎演算法或算力,更在於它是否能像人類一樣整合多重感知來源、進行有意義的推理與表達。從多模態到全模態,是一次技術上的飛躍,也是一場「認知革命」。Gemini 2.5 Pro、GPT-4o 與 Claude 3.7 Sonnet等模型正走在這條路上,而全模態模型的成熟,將成為通用人工智慧(AGI)是否可能實現的關鍵里程碑。

(初稿協作:AI)

》延伸閱讀:

- Google DeepMind: Gemini官網

- OpenAI: Introducing 4o Image Generation

- Anthropic: Claude 3.7 Sonnet

- OpenAI GPT-4o: The Next Generation of Omni-Multimodal AI

- Breaking Barriers: How Omnimodal AI Models Are Mimicking Human Senses

- 當AI學會自我演化,將自訂遊戲規則? - 2025/06/11

- 「聽懂」海豚說什麼的AI模型:DolphinGemma - 2025/06/03

- 看見AI爆發下的能源與生態危機! - 2025/05/29

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!