如何使用Intel AI PC及OpenVINO實現虛擬主播

為了使大家能更進一步理解如何實作一個簡單離線版(邊緣端)的虛擬主播,可以輸入所需文字,產生對應語音,配合閉嘴人物影片生成新的對嘴影片。接下來就分別從「推論硬體及環境建置介紹」、「MeloTTS 文字轉語音生成」、「Wav2Lip 自動對嘴影片生成」及「建置完整虛擬主播」等四大部份作更進一步說明。

AI實現健康大未來! 英特爾攜手生態系夥伴展現最新智慧醫療應用成果

台灣醫療科技展(Healthcare+ EXPO 2024)於12月5日至12月8日在台北南港盛大開展,英特爾(Intel)攜手合作夥伴共同展示運用最新AI技術的智慧醫療應用案例;今年展覽聚焦生命科學、智慧醫院、5G雲端AI、AI醫療等4大主軸,引領參觀者深入了解英特爾從雲端到邊緣如何布署智慧醫療產業。

【Arm的AI世界】以TinyML為基礎的高效率嵌入式電腦視覺

本文將透過在配備Ethos-U55 NPU的現代微控制器上執行兩個TinyML應用,來展示NPU的效能優勢。我們將分別在採用和不採用Ethos-U55 NPU的微控制器上運作應用中所使用的 ML模型,以此對推論延遲進行基準測試。

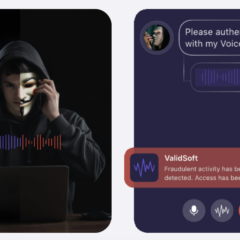

Deepfake深偽音訊真假難辨?五款AI方案有解

「深偽」Deepfake生成技術門檻愈來愈低,已被有心人普遍用於詐騙、誹謗或政治操作中。而AI生成的深偽問題,得靠AI技術來防範,本文列舉五個「語音偵偽辨識」方案,說明目前以AI防範AI的發展現況。

著眼企業級AI應用 Intel力推Xeon 6+Gaudi 3平台解決方案

各領域企業生成式AI應用持續成長,推動資料中心與基礎設施大規模轉型,英特爾(Intel)攜手伺服器生態系夥伴廠商,在台展示最新搭載P-core的Intel Xeon 6處理器結合該公司Gaudi 3 AI加速器的最新系統和解決方案…