作者:陸向陽

近年來語音辨識應用愈來愈流行,2011年蘋果(Apple)為iPhone提供Siri語音助理,之後谷歌(Google)、微軟(Microsoft)等也跟進,先後提出Google Now(2012年)、Cortana(2014年4月)。

到了2014年11月,亞馬遜(Amazon)推出Echo家庭語音助理(179美元),使語音辨識從行動裝置普及回家庭客廳,2016年3月在推出平價版的Echo,即Echo Dot(49美元),以及行動版的Echo,即Amazon Tap(129美元),使語音辨識助理裝置的應用風氣更為開展。

Maker的語音辨識開發套件:ReSpeaker

不過,上述的語音辨識應用,通常用來搜尋網頁、開啟或操作App、或獲得語音回應,卻較少用來操控家電或物聯網裝置,因此深圳矽遞(SeeedStudio)在2016年11月推出ReSpeaker開發套件,一方面可接受語音辨識,另一方面透過創客(Maker)的硬體控制電路開發,有機會用語音操控家電及物聯網裝置。

ReSpeaker是具備語音辨識技術的開發板

ReSpeaker是如何做到更廣大可能的語音辨識應用?

事實上ReSpeaker借用了現行多種技術,在硬體電路控制部份,ReSpeaker使用與Arduino相同的控制晶片:ATmega32u4,讓原本熟悉Arduino的創客,可以直接把過往設計過的控制電路,直接沿用到ReSpeaker上;它也規劃了I2C、AUX、USB等介面可供Maker來連接週邊,拓展應用性。

在Wi-Fi方面,ReSpeaker採用了聯發科(MediaTek)的MT7688晶片,這是顆本來用於家晶用Wi-Fi Router的晶片,但之後也學仿Linino ONE、Arduino Yun,透過重新規劃,包裝成LinkIt Smart 7688/7688 Duo,打入創客應用領域(相關報導)。

軟硬整合,開發潛力大

為了讓MT7688晶片獲得更穩的收發、運作表現,運用群登(AcSiP)的SiP封裝技術,事先將MT7688晶片外圍需要的電路封裝在一個模組內,再將模組交付給SeeedStudio做成ReSeapker(相關報導)。

因此,使用者發出的語音,會先由MT7688晶片先行接收,而後透過Wi-Fi無線方式傳遞到Internet上,再由Internet上的各種語音雲端服務接手處理,並傳遞回應,MT7688再將回應以喇叭方式發聲,或轉換成其他控制信號,進而控制家電等。

值得注意的是,ReSpeaker基本上只有一個單純的麥克風來接收語音,比較適合近距離發聲、低環境背景噪音下發聲,若要遠距離發話辨識,或是在較吵雜環境,則建議擴充連接陣列式麥克風(Array MIC),此在ReSepaker屬於選購配件。

ReSpeaker的麥克風陣列架構

實測影片如下:

而在控制應用程式的開發環境上,ReSpeaker與LinkIt Smart 7688/7688 Duo一樣使用嵌入式Linux作業系統,即OpenWrt,程式語言方面可用Python,或是C/C++、Arduino、JavaScript及Lua。

可以使用多種工具開發,以ReSpeaker打造各種物聯網裝置(Source)

語音辨識服務是關鍵

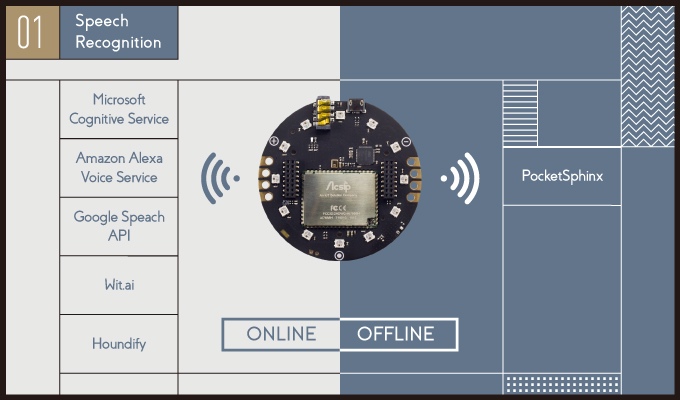

有關軟硬體構成簡述如上,我們將重點轉到語音辨識部份,ReSpeaker並沒有自己獨立發展的語音辨識技術,而是直接呼叫(Call,大陸稱為:調用)數家知名科技大廠的語音雲端服務,例如Microsoft的Cognitive Service(感知服務)、Amazon的Alexa Voice Service(簡稱AVS)、Google的Speech API,或者,也可呼叫Wit.ai或Houndify。

能支援多種雲端與離線的語音辨識系統是ReSpeaker很大的特色(Source)

如果ReSpeaker無法連上Internet呼叫這些語音辨識服務,在離線狀況下,也有PocketSphinx可呼用,直接在ReSeapker機內進行辨識運算,了解發話者的字彙意涵,進而採取行動。

且以Microsoft的Cognitive Service為例,談談語音辨識是怎麼一回事。Microsoft Cognitive中的語音辨識區分成Bing Speech API、Custom Speech Service、Speaker Recognition API,簡介定義如下:

- Bing Speech API是將發話轉成文字,轉送到Bing搜尋引擎,而且會嘗試了解發話者真正想搜尋的意向、意涵;

- Custom Speech Service則是更精進辨識,在不同發話方位或噪音環境下也能保有辨識正確性;

- Speaker Recognition API則可以知道發話者是家庭成員的爺爺、奶奶等。

事實上,Microsoft的Cognitive Service並非只有語音辨識,其實也包含視覺辨識、語言辨識、知識辨識、搜尋辨識等。其中「語言辨識」和「語音辨識」不同,前者的功能是辨認一段文字是否有拼錯字?判斷這段文字資訊是哪一國的文字?判斷一段文字中的關鍵字詞為何?好用來建立Tag標籤,方便歸類與搜尋。

Microsoft Cognitive的服務類型

值得注意的是,微軟感知服務最終仍是追求獲利,所以雖可呼用,但卻有限度,以Bing Speech API而言,每個月只能免費呼叫使用5次,每次呼用不得超過15秒,每次呼用不能超過1,000個字元,若是超過,每1,000次呼用收取4美元,呼用時間0-10小時內,每小時收取9美元,10-100小時則每小時收取7.5美元,100小時以上每小時收取5.5美元。

其他服務也類似,免費均只能限度性呼叫,Amazon與Google也類似。此外,Amazon現階段只支援英文與德文辨識,中文尚未支援。

新應用潛力無窮

有關語音辨識的應用,不只有聲控,其實還有許多可以發揮,舉例來說,日本視算(SGI)曾發展一種言花(KOTOHANA)技術,透過語音辨識了解發話者的情緒,是緊張、高興、生氣等,可以有6種情緒,每種情緒有10個刻度,這項技術之後轉至恩益禧(NEC)。

透過語音辨識出情緒可以有多種應用,例如裝置在車內,在駕駛處於興奮狀態(注意力較低)時,汽車的安全系統(ABS緊急煞車系統、Air Bag安全氣囊)會較嚴格感應,反之放寬;當用於餐廳氣氛感應,冷清與熱鬧等差別,進而改變餐廳燈光與音樂 ;也可用來輔助客服人員,確定安撫來電者的怒氣才掛電話;或用在電子寵物上,感應家庭成員的情緒,進而安慰主人等。

事實上,一項人機介面的出現,可能改變許多人的行為模式,甚至是帶來科技應用上的典範轉移,2007年iPhone問世,其觸控介面的影響力就是最好的例子。而今語音辨識的應用已打開市場,下一步可望走向穿戴式及IoT應用,而Maker創意及技術的投入,有機會加速這些事情的發生。

最後,從語音辨識到語言辨識的技術含量,大程度在軟體與演算法上,硬體反而是簡單的接軌,此方面有待更多人參與與努力。

(註:截至發稿前,ReSpeaker尚未上架線上賣場)

- 兩款聯發科Genio單板電腦觀察 - 2025/06/17

- Ollama官方模型分類觀察 - 2025/06/13

- COMPUTEX Taipei 2025量子技術展示觀察 - 2025/05/29

訂閱MakerPRO知識充電報

與40000位開發者一同掌握科技創新的技術資訊!

2019/06/25

您好,請問一下respeaker是如何辨識人聲與非人聲的呢??是分辨波紋嗎? 謝謝。