參賽團體名稱:銀添與六個打工仔

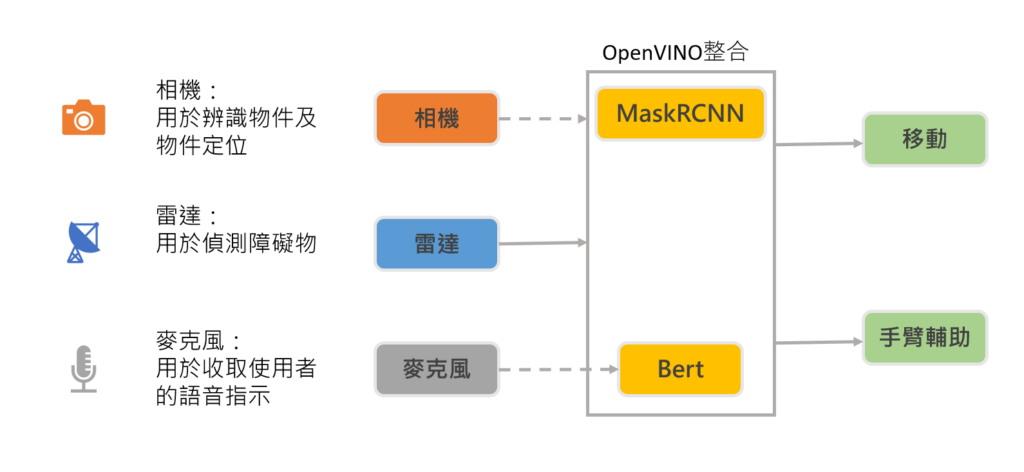

我們構想利用視覺辨識系統結合無人搬運車,以達到自動搬運的功能,能減少因人員在工廠內穿梭所造成的安全疑慮,也能減少送件的人力成本。以語音辨識來分析使用者所下達指令,結合機械手臂來輔助使用者,加上使用MaskRCNN來做物件的辨識訓練,實現無人車搬運。

提案動機

近年來因勞力成本上升,加上勞工意識的抬頭,減少勞力成本和增加勞工安全成了各個企業因更加注意的問題而結合無人車上的機械手臂,加上語音辨識系統,可輔助操作人員執行任務,不用花時間及心力設定系統,用語音即可下達指示,減少分心造成的安全危害。我們構想利用視覺辨識系統結合無人搬運車,以達到自動搬運的功能,能減少因人員在工廠內穿梭所造成的安全疑慮,也能減少送件的人力成本。以語音辨識來分析使用者所下達指令,結合機械手臂來輔助使用者,加上使用MaskRCNN來做物件的辨識訓練,實現無人車搬運。

解決方法

硬體:

- mp1

- Realsense-D435i

- 11th Gen Intel(R) Core(TM)i7 – 11800H

軟體:

- speech-recognition

- ckip

- bert

- maskrcnn

- OpenVINO toolkit

方案概念圖:

本次選用的移動式平台為MP1,為了達到期望能在智慧工廠中只須聽取語音指令就能完成任務的成效,我們運用下列步驟來一一達成。

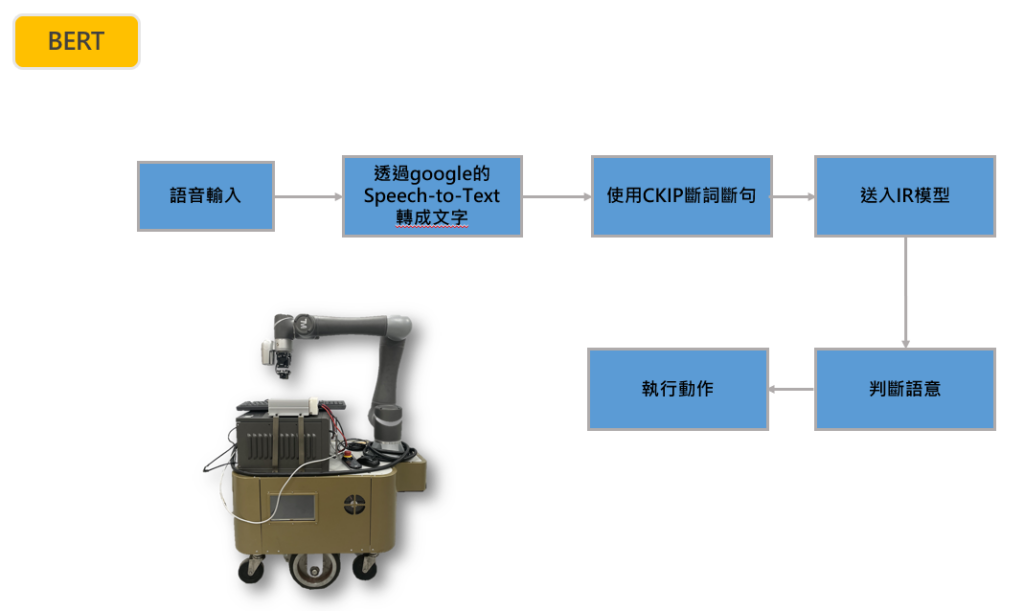

- 首先關於接取任務指令的部分,我們使用Speech-Recongnition來把聲音轉成文字,然後以ckip做斷句後運用bert讓其理解任務內任務內容再將命令給移動平台終端

- 理解任務內容後,會根據指令中有提到的需求地點做辨識以及規畫路徑,到達後接著配合機械手臂上搭載的鏡頭針對指令需求去夾取對應的物件,最後再依照後續的任務去做執行(到…放或將…交給我等等..)

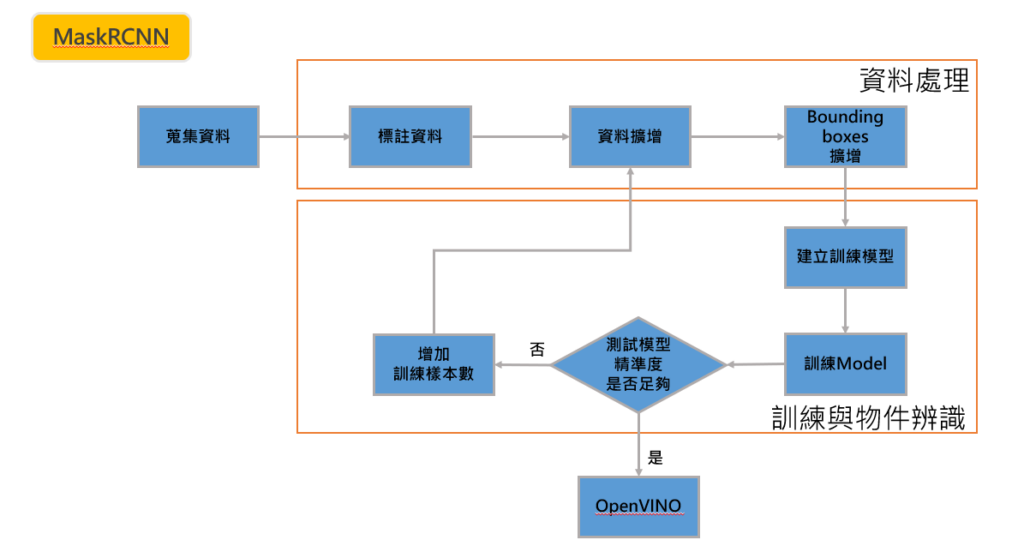

物件辨識及定位:

本專案使用以辨識出物件為目標,自行拍攝物件並進行資料擴增,在建立所需的資料集後,使用MaskRCNN訓練模型,訓練出來的模型可辨識物件的邊緣,可以幫助我們知道物件的長邊及窄邊,使夾爪可以更好的定位出哪個位置及角度可以更穩定的夾取物件。

自行訓練可以減小模型大小,和確保我們所需的精準度,隨時進行校正或增強。

語音辨識:

本專案訓練keyword-spotting及speech-recongnition,當聽到啟動的關鍵字詞後,啟動麥克風開始聽取語音指示,並使用google所提供的speech-to-text功能,將我們收音到的語音訊息轉換為文字,並使用CKIP斷句,送入Bert的模型辨識其中的指令意義,再加以執行我們所指定的動作。

路徑規劃:

本專案使用mp1移動機械手臂,在使用前會先進行場地的地圖建立,當收取語音指示並成功分析完成後,便會移動到指定位置。使用視覺辨識我們語音所指示的物件,當完成辨識完成後,便會規劃夾取路徑。

移動手臂前方的雷達會偵測前方是否有障礙物,若遇到障礙物則停止前進,以確保經過的人員安全。

成果說明與展示

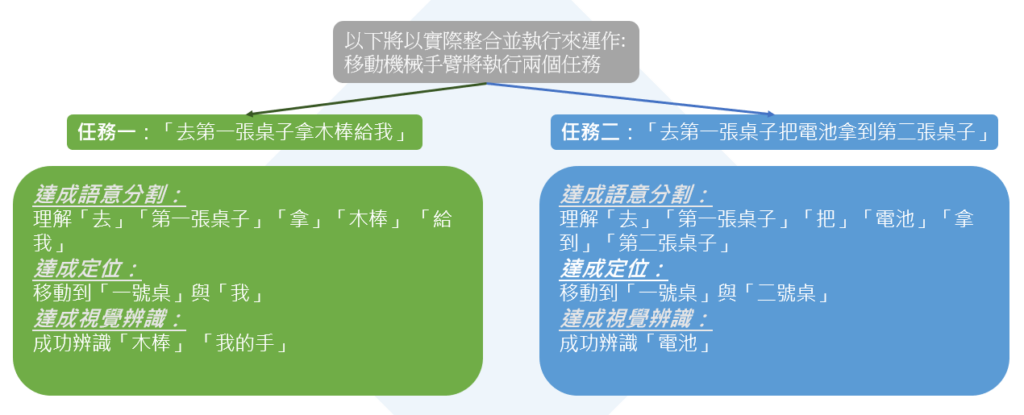

任務一:去第一張桌子拿木棒給我

任務二:去第一張桌子把電池拿到第二張桌子

結論

經過了技術整合,我們實現了用聲音轉換成文字,再將其轉換為機器可理解的指令,包括指定地點、動作和需夾取物件,和使用MaskRCNN做物件辨識,可成功辨識出指定物件及物件的形狀,使手臂更好的判斷夾取角度及位置,最後使用OpenVINO使整體模型推論更加優化,使其更能達成實時(real-time)的成效,最後以語音指示行動機械手臂協助操作員執行任務的目標 ,達到增加人員安全及減少運輸人員的效益。

我們相信語音指示行動機械手臂協助操作員執行任務的概念在許多工廠或作業區都很有利用價值,且也有很大的發展空間,使用了許多較成熟的技術,再次客製化或修正的的研發成本跟研發新技術相比,大幅減少,商轉可能性高,相信未來有許多發展空間。

太牛逼了吧